0,00 €

Mehr erfahren.

- Herausgeber: transcript Verlag

- Kategorie: Geisteswissenschaft

- Serie: Musik und Klangkultur

- Sprache: Deutsch

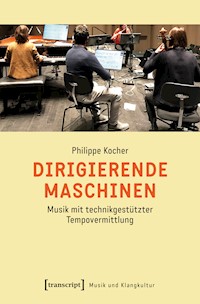

In der musikalischen Aufführungspraxis ist es normalerweise der Mensch, der das Tempo erzeugt. Innerlich ein Tempo zu etablieren und es an das der mitmusizierenden Personen anzugleichen, ist eine grundlegende musikalische Fähigkeit. Was bedeutet es also, wenn das Tempo von einem technischen System vorgegeben wird? Philippe Kocher unterzieht diese besondere Art der Mensch-Maschine-Interaktion einer musikgeschichtlichen, technikgeschichtlichen und medienarchäologischen Betrachtung. Darüber hinaus entwickelt er innerhalb seiner wissenschaftlich-künstlerischen Studie ein eigenes System zur technikgestützten Tempovermittlung und beschreibt dessen Einsatz in der Praxis.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 414

Veröffentlichungsjahr: 2023

Ähnliche

Philippe Kocher (Dr. phil), geb. 1973, lehrt Musiktheorie, Komposition und Computermusik an der Zürcher Hochschule der Künste und forscht am dortigen Institute for Computer Music and Sound Technology (ICST). Er studierte Klavier, Musiktheorie, Komposition und Musikwissenschaft in Zürich, Basel, London und Bern.

Philippe Kocher

Dirigierende Maschinen

Musik mit technikgestützter Tempovermittlung

Inauguraldissertation der Philosophisch-historischen Fakultät der Universität Bern zur Erlangung der Doktorwürde, vorgelegt von Philippe Kocher von Selzach. Von der Philosophisch-historischen Fakultät auf Antrag von Prof. Dr. Anselm Gerhard und Prof. Dr. Michael Harenberg angenommen. Bern, den 19. März 2021

Die Dekanin: Prof. Dr. Gabriele Rippl

Die Open-Access-Ausgabe wird publiziert mit Unterstützung des Schweizerischen Nationalfonds zur Förderung der wissenschaftlichen Forschung.

Bibliografische Information der Deutschen Nationalbibliothek

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über http://dnb.d-nb.de abrufbar.

Dieses Werk ist lizenziert unter der Creative Commons Attribution-NonCommercial- NoDerivs 4.0 Lizenz (BY-NC-ND). Diese Lizenz erlaubt die private Nutzung, gestattet aber keine Bearbeitung und keine kommerzielle Nutzung.

Um Genehmigungen für Adaptionen, Übersetzungen, Derivate oder Wiederverwendung zu kommerziellen Zwecken einzuholen, wenden Sie sich bitte an [email protected] Bedingungen der Creative-Commons-Lizenz gelten nur für Originalmaterial. Die Wiederverwendung von Material aus anderen Quellen (gekennzeichnet mit Quellenangabe) wie z.B. Schaubilder, Abbildungen, Fotos und Textauszüge erfordert ggf. weitere Nutzungsgenehmigungen durch den jeweiligen Rechteinhaber.

Erschienen 2023 im transcript Verlag, Bielefeld

© Philippe Kocher

Umschlaggestaltung: Jan Gerbach, Bielefeld

Umschlagabbildung: Philippe Kocher

Korrektorat: Constanze Lehmann, Berlin

https://doi.org/10.14361/9783839465042

Print-ISBN 978-3-8376-6504-8

PDF-ISBN 978-3-8394-6504-2

EPUB-ISBN 978-3-7328-6504-8

Buchreihen-ISSN: 2703-1004

Buchreihen-eISSN: 2703-1012

Inhalt

Vorwort

Einleitung

Teil I: Musikgeschichte/Technikgeschichte

1.Experimentelle Tempogestaltung: Emmanuel Ghent und das Coordinome

1.1Programmierte Signale

1.2Elliott Carters Double Concerto

1.3Emmanuel Ghents Dithyrambos

1.4Henry Cowells Quartet Romantic

2.Synchronisation zu anderen Medien: die frühe Filmmusik

2.1Die Anfänge der Ton- und Filmaufzeichnung

2.2Technikgestützte Synchronisation von Live-Musik zum Stummfilm

2.3Der Übergang zum Tonfilm

2.4Technikgestützte Synchronisation im Studio

3.Synchronisation ohne Sichtkontakt: Hector Berlioz und das métronome électrique

3.1Berlioz und die Naturwissenschaft

3.2Das Jahr 1855

3.3Wer erfand das métronome électrique?

4.Die Mechanisierung des Tempos: von Galileos Pendel bis zu Mälzels Metronom

4.1Vorgeschichte: Die Quantisierung der Zeit

4.2Die Isochronie der Pendelschwingung

4.3Das ›richtige‹ Tempo

4.4Uhrwerke und Metronome

TeilII: Wissenschaftlichkünstlerische Studie

5.Prämissen

5.1Technik

5.2Praxis

5.3Werke

6.Technikentwicklung: Konzeption und Implementation von Applikationen

6.1Die Applikation für die Aufführung von Musik

6.2Die Applikation für die Komposition von Musik

7.Aufführungspraxis: Musik mit technikgestützter Tempovermittlung

7.1Zusammenspiel und Synchronisation des Tempos

7.2Tempopolyphonie

7.3Musik im Raum

7.4Performative Wirkung

8.Kompositionspraxis: Prozesse des Komponierens und Schreibens

8.1Das Notationssystem als Handlungsraum

8.2Werkbeispiele

8.3Diskussion

Fazitund Ausblick

Anhang: Werkliste

Verzeichnis der zitierten Literatur

Vorwort

Schon als junger Komponist fesselte mich polyphone und mehrschichtige Musik. Bereits in den Kompositionen, die ich als Student schrieb, wagte ich die ersten Versuche, die Selbständigkeit der einzelnen Instrumentenstimmen auch dadurch zu charakterisieren, dass ich sie parallel in verschiedenen Tempi führte. Viele meiner Kompositionen beinhalten seither tempopolyphone Strukturen. Ebenso fasziniert bin ich von der Möglichkeit, den Computer für musikalische Zwecke zu verwenden. Dies führte mich ebenso zur elektroakustischen Musik wie zur computergestützten algorithmischen Komposition.

Mit meinem Forschungsprojekt zu Musik mit technikgestützter Tempovermittlung ist es mir gelungen, meine verschiedenen Interessen zusammenzubringen und mich gleichermaßen als Komponist, Musikinformatiker und Musikwissenschaftler einzubringen. Also komponierte ich tempopolyphone Musik, programmierte eine Software, die den Musiker·innen die verschiedenen Tempi anzeigt, und versuchte beides theoretisch und historisch zu kontextualisieren. Damit war dieses Projekt von Anfang an ein mehrgleisiges Unterfangen, das von mir verlangte, zwischen verschiedenen Gebieten zu oszillieren. Dies erwies sich als ebenso spannend wie herausfordernd, da alle Gebiete ihrer eigenen Logik folgen, unterschiedliche Ansprüche stellen und einen eigenen Jargon sprechen.

Meine Dissertation konnte ich im künstlerisch-wissenschaftlichen Doktoratsprogramm Studies in the Arts (SINTA) der philosophisch-historischen Fakultät der Universität Bern und der Hochschule der Künste Bern realisieren. Dieses Doktoratsprogramm bot mir ein stimulierendes Umfeld. Mein erster Dank gilt meinen beiden Betreuern Prof. Dr. Anselm Gerhard und Prof. Dr. Michael Harenberg für ihre motivierende Unterstützung und die vielen wichtigen Hinweise, Anregungen und Ratschläge, die ich erhalten habe.

Ich hatte das Glück, dass ich die praktischen Teile meiner Forschung im Rahmen meiner Tätigkeit am Institute for Computer Music and Sound Technology (ICST) an der Zürcher Hochschule der Künste durchführen und einen substanziellen Teil meines Arbeitspensums dafür aufwenden konnte. Ebenso wurden etliche Infrastrukturkosten sowie die Honorare für die Konzerte vom ICST getragen. Für diese Unterstützung möchte ich dem Leiter des ICST, Prof. Germán Toro Pérez, meinen Dank aussprechen.

Bei der Software-Entwicklung im Rahmen dieses Forschungsprojekts erhielt ich substanzielle Hilfe von Christian Schweizer, der nicht nur wesentliche Teile zur Software beigetragen hat, sondern mir auch dank seiner Erfahrung als Informatiker viele praktische Hinweise geben konnte. Ihm möchte ich herzlich danken, ebenso wie Tobja Franz, der den Grundstein für die Web-Browser-Version der Applikation PolytempoNetwork legte, die sich in der Praxis als so nützlich erwiesen hat.

Großer Dank gebührt auch den Komponist·innen, die mit ihren Werken zu meinem Forschungsprojekt beigetragen haben: Mathieu Corajod, Kilian Deissler, Cameron Graham, Angel Hernández-Lovera, Carlos Hidalgo, Marc Kilchenmann, Marcelo Lazcano, André Meier, Karin Wetzel und Stefan Wirth. Sie alle haben nicht nur die Konzertveranstaltungen mit wunderbarer Musik bereichert, sondern auch mit ihren kompositorischen Ideen mein Verständnis von tempopolyphoner Musik maßgeblich geprägt. Sie mögen mir verzeihen, dass ich ihre Werke in dieser Arbeit auf nur wenige Aspekte reduziert beschreibe, ich bin mir bewusst, dass dies der künstlerischen Aussage dieser Werke in keiner Weise gerecht wird. Ebenso möchte ich mich bei allen Musiker·innen bedanken, die sich von PolytempoNetwork haben dirigieren lassen. Es sind zu viele, um sie hier einzeln namentlich aufzählen, aber ihr engagiertes und professionelles Spiel hat mich immer wieder davon überzeugt, wie lebendig, sprechend und bewegend maschinendirigierte Musik sein kann.

Philippe Kocher, im Juni 2022

Einleitung

Beim Musizieren ist der Mensch der hauptsächliche Akteur bei der Erzeugung des Tempos. Die Fähigkeit, innerlich ein Tempo zu etablieren und die verrinnende Zeit durch eine regelmäßige Pulsation zu strukturieren, ist eine Universalie der Musikausübung1 und die Grundlage für die Ausführung von mensurierten (notierten) Rhythmen. Wenn mehrere Personen gemeinsamen musizieren, gleichen sie ihre innerlich gefühlten Pulsationen aufeinander ab. Dies gelingt, weil alle Beteiligten – selbst die das Tempo vorgebenden Dirigent·innen – anpassungsfähig sind. Einen musikalischen Puls wahrnehmen und sich zu ihm synchronisieren zu können, ist eine menschenspezifische Fähigkeit, von der sogar angenommen wird, dass sie sich speziell für die Musik entwickelt hat.2

Was bedeutet es nun, wenn ein technisches System dem Menschen das Tempo diktiert? Dies ist die Frage, mit der sich die vorliegende Arbeit befasst. Die Auseinandersetzung mit dieser Frage geschieht in zweifacher Weise: Erstens werden vier historische Beispiele für die Verwendung von technikgestützter Tempovermittlung einer musik- und technikgeschichtlichen Betrachtung unterzogen. Die Sichtweise richtet sich auf das Vergangene und versucht aufzudecken und zu verstehen, unter welchen historischen und gesellschaftlichen Gegebenheiten sich technische Systeme zur Tempovermittlung entwickelt haben. Zweitens werden die Resultate einer praxisbezogenen Studie, bei der selbst ein System zur technikgestützten Tempovermittlung entwickelt und angewendet wurde, dargelegt. Die Sichtweise richtet sich hier auf das Mögliche und fragt, wie heute ein technisches System zur Tempovermittlung aussehen kann und was sich damit künstlerisch erreichen lässt.

Der hier gewählte Ansatz ist transdisziplinär und vereint Musikgeschichte, Technikgeschichte und Medienarchäologie, aber auch Musiktheorie, Musikinformatik und Kompositionspraxis. Eine derart große Breite kann nicht den Anspruch erheben, alle Teilgebiete gründlich zu vertiefen, sie wurde jedoch bewusst gewählt, weil sie ermöglicht, weitreichende Zusammenhänge und disziplinübergreifende Kontexte aufzuzeigen. In diesem Sinne ergänzen sich die historischen Betrachtungen und die auf die Gegenwart ausgerichtete praktische Studie. Durch die Beschäftigung mit der Geschichte kann das gegenwärtige – und möglicherweise auch das zukünftige – künstlerische Handeln verstanden werden. Gleichzeitig ermöglicht die künstlerische Praxis eine Nähe zum Forschungsgegenstand und gestattet damit, eine Perspektive einzunehmen, die bestimmte historische Fragestellungen überhaupt erst aufwirft. Diese gegenseitige Kontextualisierung der historischen und der künstlerisch-praktischen Beschäftigung mit dem Forschungsgegenstand ist dabei nicht beeinträchtigt von der Tatsache, dass die heutige Praxis ganz andere Resultate (Kompositionen und technische Systeme) hervorbringt als die historischen Fallbeispiele.

Die technikgestützte Tempovermittlung ist ein noch wenig erforschtes Gebiet. Zwar existieren zu einzelnen historischen Anwendungsfällen bereits Untersuchungen, aber eine zusammenfassende Darstellung, die sich dieser besonderen Art der Mensch-Maschine-Interaktion widmet, liegt bisher nicht vor. Die vorliegende Arbeit ist ein Schritt in diese Richtung.

Technikbegriff

Zunächst ist es nötig, den in dieser Arbeit verwendeten Technikbegriff zu klären. Das Wort ›Technik‹ wird je nach Kontext anders verwendet und verstanden. Es gibt, besonders in den Geisteswissenschaften, einen weiten Technikbegriff, »der jede Art von kunstfertiger Verfahrensroutine in beliebigen menschlichen Handlungsfeldern umfasst«.3 Spricht man von der Technik des Klavierspiels oder der Technik des Kopfrechnens, sind damit nicht künstliche Geräte gemeint, sondern eine zielgerichtet eingesetzte Fertigkeit des menschlichen Handelns. Um den Technikbegriff zu strukturieren, unterscheidet Friedrich von Gottl-Ottlilienfeld innerhalb dessen, was er als »Technik im allgemeinen« bezeichnet, für verschiedene Bereiche menschlichen Handelns die »Individualtechnik« (z. B. Klavierspiel), die »Sozialtechnik« (z. B. Staatsverwaltung) und die »Intellektualtechnik« (z. B. Kopfrechnen). Daneben stellt er die »Technik im besonderen«, die er »Realtechnik« nennt und zu der er alle »Verfahren und Hilfsmittel des naturbeherrschenden Handelns« zählt.4

In den Technikwissenschaften und tendenziell auch in der Umgangssprache herrscht ein enger Technikbegriff vor, der einzig die gegenständliche Welt der Maschinen und Apparate meint. An Gottl-Ottlilienfelds Realtechnik anschließend entwirft der Technikphilosoph Günther Ropohl folgende Definition: »Technik umfasst (a) die Menge der nutzenorientierten, künstlichen, gegenständlichen Gebilde (Artefakte oder Sachsysteme), (b) die Menge menschlicher Handlungen und Einrichtungen, in denen Sachsysteme entstehen und (c) die Menge menschlicher Handlungen, in denen Sachsysteme verwendet werden.«5 Diese technikwissenschaftliche Definition gilt auch für die Verwendung des Begriffs Technik in dieser Arbeit.

Technisch ausgeführte Musik

Der thematische Rahmen für die vorliegende Arbeit ist die ebenso alte wie bedeutsame Verbindung von Musik und Technik. Thor Magnusson argumentiert, dass die Musikausübung schon immer an der vordersten Front des menschlichen Werkzeuggebrauchs stand und dass die Zweckbestimmung dieser Werkzeuge – von simplen Höhlenflöten zu Harfen, Orgeln, mechanischen Klavieren, Musikautomaten, elektronischer Klangerzeugung und Computersoftware – stets der musikalische Ausdruck war: »[I]f there is anything that might best exemplify human nature, it might be our technologies for musical expression«.6

Das Bestreben, die Musik an nicht-menschliche Agenten zu delegieren und damit auch den zeitlichen Ablauf der Musik in einem Programm festzuhalten, brachte Musikautomaten hervor.7 Für deren Bau und Verwendung reichen die Zeugnisse weit zurück: Die drei Brüder Banū Mūsā, die im 9. Jahrhundert in Bagdad lebten, erschufen einen automatischen Flötenspieler, der islamische Ingenieur Al-Dschazarī baute im 12. Jahrhundert ein Boot mit vier automatischen Musikern (zwei Trommler, ein Harfenspieler und ein Flötist), das auf einem See schwamm und die königlichen Gäste unterhielt.8 Diese arabischen Ingenieure bezogen sich auf die Überlieferung der Arbeiten des griechischen Mathematikers und Ingenieurs Heron von Alexandria aus dem 1. Jahrhundert v. u. Z.9 Verantwortlich dafür, dass dieses Wissen in der frühen Neuzeit schließlich nach Europa überliefert wurde, waren der italienische Naturphilosoph Giambattista Della Porta, der englische Arzt und Philosoph Robert Fludd und vor allem der deutsche Universalgelehrte Athanasius Kircher.10 In seiner Musurgia Universalis formulierte Kircher 1650 die Prinzipien der mechanischen Steuerung von Musikautomaten.11

Spieluhren, Orchestrien und Automaten sind ein unterschätztes Kapitel der europäischen Musikgeschichte. Von musizierenden Maschinen, deren technische Raffinesse sich parallel mit den Fortschritten des Uhrmacherhandwerks entwickelte, ging eine große Faszination aus. Jaques de Vaucanson, der als Konstrukteur von Automaten Berühmtheit erlangte, präsentierte 1737 der Öffentlichkeit seinen automatischen Flötenspieler. Diese lebensgroße Figur besaß ein Repertoire von zwölf Liedern, die auf einer mechanischen Stiftwalze gespeichert waren. Johann Joachim Quantz schien solche Automaten gekannt zu haben. Er erwähnt sie in seinem Versuch einer Anweisung die Flöte traversiere zu spielen:

Man könnte eine musikalische Maschine durch Kunst zubereiten, daß sie gewisse Stücke mit so besonderer Geschwindigkeit spielete, welche kein Mensch, weder mit den Fingern, noch mit der Zunge nachzumachen fähig wäre. Dieses würde auch wohl Verwunderung erwecken; rühren aber würde es niemals […].12

Auch wenn Quantz hier die mangelnde Ausdrucksfähigkeit der mechanischen Musikwiedergabe kritisiert, scheint doch die »Verwunderung« so sehr ein Kriterium gewesen zu sein, dass sich etliche Komponisten mit Automaten befassten und Originalkompositionen für Flötenwerke oder Spieluhren schrieben, z. B. Georg Friedrich Händel (HWV 473, 578, 587–604), Joseph Haydn (Hob. XIX:1–32), Wolfgang A. Mozart (KV 594, 608, 616, zwei Fragmente KV 593a und 615a)13 und Ludwig van Beethoven (WoO 33).

Mechanische Musikinstrumente fanden immer größere Verbreitung, ihre Blütezeit lag zwischen der Mitte des 19. Jahrhunderts und dem Ersten Weltkrieg.14 Die Stiftwalze als Informationsträger wurde um 1880 durch pneumatisch abgetastete Lochstreifen, die erst aus Karton und später aus Papier gefertigt wurden, ersetzt.15 Eine spezielle Form dieser Musikautomaten stellen die automatischen Klaviere dar. In ihrer Form als ›Reproduktionsklaviere‹ wurden sie verwendet, um das aufgezeichnete Spiel bekannter Pianisten wiederzugeben. Im 20. Jahrhundert begannen etliche Komponisten damit, Musik speziell für automatische Klaviere zu schreiben.

Obwohl schon früher Einflüsse der Technik auf die Kunst feststellbar sind, kam um 1920 an vielen Orten eine veritable Maschinenästhetik auf. Das Interesse an der maschinellen Wiedergabe der Musik richtete sich auf zwei Aspekte: Erstens die Objektivität, die durch die Vermeidung von menschlichen Interpret·innen erreicht werden konnte, und zweitens die neue Ästhetik, die durch die Überwindung der menschlichen Grenzen möglich wurde. »For the immediate future there will be only two kinds of music, the Banal, and the Mechanistic«, sagte George Antheil 1922 voraus.16 Der deutsche Musikwissenschaftler und Musikkritiker Hans Heinz Stuckenschmidt stellte gar die zugespitzte Behauptung auf, dass in wenigen Jahren die Rolle des Interpreten der Vergangenheit angehöre und die Zukunft in der mechanischen Musik liege, weshalb die Intuition des Komponisten nun beginnen dürfe, »über die Grenze der vom Menschen ausführbaren Techniken hinauszuführen«.17

Bei den Donaueschinger Kammermusiktagen fand 1926 ein Konzert mit dem Titel »Originalkompositionen für mechanische Instrumente« statt. Alle Stücke waren für ein Selbstspielklavier der Firma Welte-Mignon komponiert. Dass dieses Konzert einen Beitrag leisten sollte, eine neue Musikgattung zu etablieren, kommt in Paul Hindemiths Progammhefttext deutlich zum Ausdruck:

Zudem fehlen bis jetzt (von einigen Ausnahmen abgesehen) fast gänzlich Originalkompositionen von Qualität für ›mechanische‹ Instrumente. Erst wenn eine selbständige, spezifische Literatur vorhanden ist, wird man die Möglichkeit zu ernsthafter Debatte haben. […] Die Kompositionen sind teils von der Firma Welte nach der schriftlichen Vorlage der Komposition gestanzt […], teils wurden sie von den Autoren selbst auf die Rolle geschrieben […]18

Im darauf folgenden Jahr fand im Rahmen desselben, nunmehr nach Baden-Baden verlegten Musikfests ein weiteres Konzert statt, das mit »Originalwerke für mechanische Instrumente« überschrieben war. In einer wiederum im Programmheft erschienenen Erörterung zur mechanischen Musik misst Hindemith der vom Komponisten eigenhändig in die Notenrolle gestanzten Musik eine besondere Bedeutung zu:

Nur die vom Komponisten beschriebene Rolle kann uns hier interessieren. Sie allein ist geeignet, Musik zu übertragen, die höchsten künstlerischen Ansprüchen zu genügen befähigt ist. Sie ist die eigentliche ›mechanische Musik‹.19

Damit rückt Hindemith vor allem seine eigene Arbeit ins richtige Licht. Wenn er schon nicht der Erste war, der mechanische Musik komponierte, wollte er wenigstens ein Hauptvertreter der ›eigentlichen‹ Ausprägung dieser musikalischen Gattung sein. Darin zeigt sich auch ein Aspekt dieser Bestrebungen zur Objektivierung der Musik: Auch wenn man den Menschen als Interpreten vermeiden wollte, der Komponist als Subjekt blieb weiterhin im Zentrum. Im selben Text diskutiert Hindemith auch die geläufigen Argumente für und gegen die mechanische Musik und plädiert schließlich dafür, sie als eigenständige Form des Musizierens anzusehen, weil sie die von Menschen gespielte Musik nicht konkurrenziere, sie weder nachahmen noch ersetzen wolle. Gleichzeitig warnt er aber auch vor technischen Spielereien, die sich selbst genügen:

Wohl ist es verlockend, auf einem elektrischen Klavier ohne Mühe Stellen spielen zu lassen, die sechs Hände nicht bewältigen könnten, aber hier ist es gerade wie in der ›anderen‹ Musik auch: Es ist vollkommen uninteressant, ob ein Stück mehr oder weniger brillant geschrieben ist, wenn der musikalische Inhalt wertlos ist. Die Vorzüge des Apparats liegen lediglich in seiner absoluten Eindeutigkeit, Klarheit, Sauberkeit und der Möglichkeit höchster Präzision – Eigenschaften, die das menschliche Spiel nicht besitzt, deren es auch nicht bedarf.20

Stimmen für eine technische, nicht vom Menschen eingeschränkte Musikwiedergabe erklangen auch in Frankreich. In einem Interview mit der französischen Literatur- und Kunstzeitung Comœdia äußerte Arthur Honegger 1928 seine Ansichten zur mechanischen Musik:

La musique mécanique permet d’établir l’interprétation-type. L’avenir est dans l’orchestre uniquement mécanique, qui offrira d’abord l’avantage de ne plus être limité par les possibilités humaines d’étendue et de durée. […] Je crois à l’avenir de la mécanique dans le domaine musical, au développement de la musique par la machine et peut-être – peut-être – à la résurrection du théâtre lyrique par les moyens scientifiques modernes, seuls capables de résoudre les problèmes créés par les exigences grandissantes des interprètes humains.

– En les supprimant?

– Oui.21

Natürlich lösten solche Technikverherrlichungen immer auch heftigen Widerspruch aus. Stellvertretend sei hierfür der deutsche Musikkritiker und Musikessayist Adolf Weißmann genannt, der 1928 ein Buch mit dem Titel Die Entgötterung der Musik veröffentlichte, in dem er die Auswirkungen der modernen Technik auf die Musik kritisiert:

Das Schwerste, ja das Unerhörte, das noch in keiner Periode der Musikentwicklung aufgetreten ist, ist die Maschine, der Mechanismus, der den musizierenden Menschen entwurzeln will. Ob und wie es ihm gelingen wird, sich mit ihr auseinanderzusetzen, ob der neue Mensch sich gerade musikschaffend oder anders betätigen wird, läßt sich nicht prophezeien. Die technischen Umwälzungen schreiten fort; der Mensch wandelt mit ihnen. Wir wissen von einer vergangenen göttlichen Musik; hoffen auf das Genie, das auch über die Maschine siegt.22

Bei den Annäherungen an die Technik in den 1920er Jahren ging es um ein Entweder-oder: Eine von der Subjektivität der Interpretation und den Grenzen der menschlichen Möglichkeiten befreite Musikpraxis wurde einer ausdrucksvollen, menschlichen gegenübergestellt. Im weiteren Verlauf des 20. Jahrhunderts kam es zu einer zunehmenden Technisierung der Gesellschaft, was auch in verschiedener Weise in der Musik Spuren hinterließ. An die Stelle der Alternative ›Mensch oder Maschine‹ tritt die Mensch-Maschine-Verbindung.23 Das zeigt sich besonders in der Verwendung von elektronischen Musikinstrumenten und des Computers, aber auch daran, dass kompositorische Konzepte der Musik des 20. Jahrhunderts sich immer stärker an einem naturwissenschaftlichen oder technischen Denkideal orientieren. ›Mathematische‹ Konzepte und Verfahrensweisen lassen sich z. B. im Serialismus und in anderen musterbasierten Kompositionsstilen finden.24 Dass dies nicht zwingend bedeutet, dass damit auch eine Entmenschlichung des musikalischen Ausdrucks angestrebt wurde, zeigt sich in einer Äußerung von Elliott Carter, dessen Musik gerade als Beispiel für komplexe Musik gerne genannt wird. Zu Conlon Nancarrow und seinen Studies for Player Piano sagt Carter:

I’ve got a funny feeling about that because of this friend of mine who’s written so many pieces for player piano. They are so mechanical. He’s really carried it out to a degree that I’ve never heard in electronic music. This mechanical aspect is something I don’t like. To me, performance of music depends a great deal on the imagination of the performer, and I see my music as something that is going to be played by people, and something that is going to interest them.25

Diese Haltung, für die Carter hier beispielhaft steht, ist bis heute weit verbreitet. Auch wenn die Techniknutzung in der Musik unserer Zeit kaum mehr als Besonderheit zu bezeichnen ist, wird dennoch oftmals Wert darauf gelegt, dass sich in irgendeiner Weise menschliche Subjektivität zeigt. Es scheint geradezu zwingend zu sein, dass gewisse Aspekte des musikalischen Ausdrucks menschlich bleiben. Vielleicht steckt die Angst dahinter, als Mensch ersetzbar zu sein.26

Auch bei der im Rahmen der vorliegenden Arbeit durchgeführten Studie zur technikgestützten Tempovermittlung ließ sich das beobachten: Eine häufige Reaktion – nicht auf ein gehörtes Stück, sondern nur schon auf die verbale Schilderung, dass das Tempo technisch vorgegeben werde – war Ablehnung. Oft wurde befürchtet, dass das technisch vermittelte Tempo dem musikalischen Vortrag seine Flexibilität und damit seine Menschlichkeit nehme, und es wurde a priori angenommen, dass technikgestützte Tempovermittlung für die meiste Musik gar nicht zu einem ästhetisch erstrebenswerten Resultat führen könne. Die Feststellung, dass die technikgestützte Tempovermittlung die menschliche Flexibilität einschränkt, ist richtig. Man möchte ihr aber entgegenhalten, dass nicht nur danach gefragt werden sollte, was die technikgestützte Tempovermittlung verunmöglicht, sondern auch danach, was sie im Gegenzug ermöglicht.

Die Geschichte der technikgestützten Tempovermittlung

Die in dieser Arbeit untersuchten Fallbeispiele stehen für exemplarische historische Konstellationen und unterscheiden sich stark voneinander. Sie zeigen die Breite der möglichen Anwendungen, die unter dem Begriff technikgestützte Tempovermittlung zu fassen sind. Das gemeinsame Thema, das die Fallbeispiele verbindet, ist die Verwendung technischer Werkzeuge zur Übermittlung des musikalischen Tempos an menschliche Akteure. Die Unterschiede liegen in der Art der verwendeten technischen Mittel und in der Weise, in der das Tempo den Musiker·innen angezeigt wird. Die Unterschiede liegen auch in den künstlerischen Zielen, die durch die technikgestützte Tempovermittlung angestrebt werden. Es kann sich dabei um die ›mechanische‹ Objektivierung des Tempos handeln, die Synchronisation von Musiker·innen untereinander oder zu einem Medienzuspiel oder die Realisierung von ›unspielbar‹ komplizierten Tempostrukturen, wie sie z. B. bei der Tempopolyphonie auftreten. Ebenso steht jedes Fallbeispiel in seinem eigenen technikgeschichtlichen Kontext. Die zur Verfügung stehenden technischen Mittel – das kann z. B. das Uhrwerk, die Telegrafie, der Film oder die Computertechnik sein – werden aufgegriffen und den Bedürfnissen der Musikpraxis angepasst.

Ziel der Untersuchung der historischen Beispiele ist, anhand der Erkenntnisse, die sich aus der Betrachtung vergangener Techniknutzungen ergeben, ein Verständnis für die heutige Praxis zu erlangen. Dieses Ziel folgt der Theorie der Medienarchäologie, die sich der Vergangenheit zuwendet, um die Gegenwart zu verstehen, und sich dabei auch explizit um vergessene und fragmentarisch überlieferte Techniken kümmert: »Media archaeology is introduced as a way to investigate the new media cultures through insights from past new media, often with an emphasis on the forgotten, the quirky, the non-obvious apparatuses, practices and inventions.«27 In diesem Sinne sollen die historischen Fallbeispiele hier nicht als Schritte in einer geradlinigen Evolution der Systeme zur technikgestützten Tempovermittlung verstanden werden. Auch wenn es Parallelen zu den heutigen Techniken gibt, dürfen die historischen Techniken nicht einfach auf den Status von bloßen Vorläufern reduziert werden. Es geht nicht um die Suche nach historischen Kontinuitäten oder dem Ursprung der technikgestützten Tempovermittlung, sondern um das Verständnis, das man erlangt, wenn man die historischen Fälle in ihrer Individualität betrachtet. Die Reihenfolge, in der die historischen Fallbeispiele in dieser Arbeit abgehandelt werden, folgt der Assoziation des Ausgrabens. Das Vorgehen ist chronologisch ›rückwärts‹, ausgehend vom jüngsten und der heutigen Praxis am nächsten stehenden Beispiel werden immer tiefere Sedimentschichten freigelegt.

Das erste Kapitel befasst sich mit dem Komponisten Emmanuel Ghent, dessen Pionierleistung darin bestand, ein Verfahren zu entwickeln, um einen tempopolyphonen Click-Track herzustellen. Dieses Verfahren ermöglichte ihm, seine tempopolyphone Musik aufzuführen, und gleichzeitig spornte es ihn an, besonders anspruchsvolle Tempostrukturen zu entwerfen. Die von Ghent erhaltenen Beschreibungen der einzelnen Produktionsschritte dokumentieren, mit wie viel Aufwand die Herstellung eines solchen Click-Tracks verbunden war. Zwei Werke der Komponisten Henry Cowell und Elliott Carter bieten dazu ergänzende Gegenbeispiele. Sie besitzen beide eine komplexe rhythmische Struktur, wurden aber nicht für die Aufführung mit einem Click-Track komponiert. Carter verwendete nie ein technisches Hilfsmittel zur Tempovermittlung und fand in der rhythmischen Ausdifferenzierung genügend Möglichkeiten, um zu einer musikalischen Mehrschichtigkeit zu gelangen. Cowell wollte mit seinem Werk eine spekulative Rhythmustheorie exemplifizieren und nahm dafür in Kauf, dass sein Werk unspielbar war – zumindest bis zu jenem Zeitpunkt, an dem man doch einen Click-Track zur Hilfe nahm.

Das zweite Kapitel befasst sich mit der Filmmusik und dokumentiert zahlreiche technische Verfahren, die in der Zeit von Mitte der 1910er bis Anfang der 1930er Jahre entwickelt wurden. Sie wurden verwendet, wenn die Musik mit dem Bild genau übereinstimmen musste, z. B. bei der Lichtspieloper. Den Musiker·innen wurde das Tempo angezeigt, indem entweder auf dem Filmbild ein Taktgeber (ein Dirigent, ein Lichtsignal) zu sehen war oder ein Notenband synchron mitlief. Diese Verfahren wurden zunächst bei Live-Musik zur Filmvorführung angewendet und später bei Tonaufnahmen im Studio. Als sich Ende der 1920er Jahre der Tonfilm durchsetzte, konnten Bild und Musik in einer noch nie dagewesenen Genauigkeit koordiniert werden. Diese Genauigkeit war neu und faszinierte die Filmmusikkomponisten, entsprechend gründlich wurden ihre Möglichkeiten ausgeschöpft. Man kann in diesem Sinne die Ästhetik des Mickey-Mousing als eine Reaktion auf die Möglichkeiten der Technik verstehen.

Das dritte Kapitel wendet sich einer Kuriosität aus der Mitte des 19. Jahrhunderts zu. 1855 verwendete Hector Berlioz – und auch noch einige andere, weniger prominente Kapellmeister – ein métronome électrique. Es handelte sich dabei um eine Apparatur, bei der am Dirigentenpult eine Taste betätigt werden konnte, um an einer anderen Stelle elektromagnetisch einen Taktstock zu bewegen und damit z. B. einen Chor hinter der Bühne zu dirigieren. Ein technikgeschichtlicher Zusammenhang lässt sich leicht finden: Die Elektrizität und die Telegrafie, zwei der wichtigsten technischen Neuerungen dieser Zeit, wurden hier für eine musikalische Anwendung übernommen. Aber es zeigt sich auch die Bedeutung der beteiligten Akteure. Bei diesem Beispiel in der Person des exzentrischen, aber auch an Naturwissenschaft interessierten Hector Berlioz, der eine solche Apparatur für seine Musik verwendete.

Das vierte Kapitel widmet sich Mälzels Metronom, insbesondere seiner Vorgeschichte. Etliche Verfahren, um das musikalische Tempo mechanisch zu erfassen, sind dem Metronom vorausgegangen. Es wäre jedoch eine Vereinfachung, sie alle in eine Linie zu stellen und jede Verwendung eines Fadenpendels oder eines Uhrwerks zur Bestimmung des musikalischen Tempos als ›frühes Metronom‹ zu bezeichnen. Vielmehr muss differenziert werden, welche Bedeutung die Akteure aus Wissenschaft, Musikpraxis und Mechanik hatten und wie sie miteinander interagierten. Im Gegensatz zu der umfangreich vorliegenden Fachliteratur, die dieses Thema im Hinblick auf die historische Aufführungspraxis behandelt, wird hier der Fokus stärker auf die technikgeschichtliche Entwicklung gelegt: Die Suche nach einer Methode, das ›richtige‹ Tempo festzuhalten, wird in einen Zusammenhang mit den Entwicklungen der Wissenschaft und der Uhrmacherkunst gebracht.

Studie

Der zweite Teil dieser Arbeit stellt den historischen Betrachtungen eine praxisbasierte Studie gegenüber. So unterschiedlich und individuell wie die betrachteten historischen Fallbeispiele sind, versteht sich auch diese Studie als ein einzelner, exemplarischer Fall für die Anwendung von technikgestützter Tempovermittlung. Sie steht ebenso in einem technikgeschichtlichen Kontext, bei dem es sich hier um das frühe 21. Jahrhundert handelt, und sie ist ebenso geprägt von der Arbeit und der Interaktion der beteiligten Personen. Bei der Diskussion dieser Studie werden nicht nur die technischen Mittel und ihre Verwendung in Betracht gezogen, sondern auch ein Fokus auf die künstlerische Praxis und die entstandenen Werke gelegt.

Im fünften Kapitel wird die gesamte Studie überblickt und die Rahmenbedingungen, Zielsetzungen, Fragestellungen und Vorgehensweisen beschrieben. Für die hier beschriebene Studie wurde selbst Technik entwickelt und keine bestehenden Produkte verwendet. Dadurch konnte auch die Wechselwirkung, die sich zwischen technischer Entwicklung und künstlerischer Anwendung ergibt, thematisiert werden. Verschiedene Komponist·innen wurden beauftragt, Werke zu schreiben, und es wurden einige Konzerte durchgeführt, in denen die aufführungspraktischen Wirkungen beobachtet werden konnten.

Die technischen Entwicklungen, die im Rahmen der Studie entstanden sind, werden im sechsten Kapitel genauer beleuchtet. Es handelt sich um zwei Applikationen. Die erste Applikation dient zur Tempovermittlung mittels mehrerer in einem lokalen Netzwerk verbundener Computer. Die zweite Applikation ist ein Hilfsmittel zur Konstruktion von Tempostrukturen. In ihr ist auch ein Verfahren implementiert, das die mathematischen Probleme löst, die sich bei der kontrapunktischen Koordination verschiedener Temposchichten ergeben.

Im siebten Kapitel werden die aufführungspraktischen Möglichkeiten, die sich durch technikgestützte Tempovermittlung ergeben, diskutiert. Dazu werden die Erkenntnisse, die aus der Aufführung der Werke und der Anwendung der Applikationen in der Praxis entstanden sind, ausgewertet. Zentral ist dabei die Frage, ob es Musik gibt, bei der die technikgestützte Tempovermittlung nicht nur ein Hilfsmittel, sondern eine Notwendigkeit ist, und ob dies zu Phänomenen führt, die sich auch der Wahrnehmung des Publikums erschließen.

Das achte Kapitel schließlich beleuchtet die Kompositionsprozesse und verfolgt die Frage, welche dialektische Beziehung zwischen technikgestützter Aufführungspraxis und kompositorischem Denken besteht. Da es sich bei den Werken, die im Rahmen der Studien entstanden sind, um traditionell notierte Instrumentalmusik handelt, bietet es sich an, die Notate (Skizzen und Reinschriften) zu untersuchen. Die Betrachtung der Kompositionsprozesse anhand der Schreibprozesse ist aber noch aus einem weiteren Grund interessant. Die traditionelle Partiturdarstellung eignet sich schlecht für tempopolyphone Musik und behindert so viele Vorgänge, bei denen das Schreiben selbst ein Teil des musikalischen Erfindens ist. Auf diese Schwierigkeiten reagierten die Komponist·innen mit Arbeitsstrategien, die – wie sie auch immer geartet waren – Auswirkungen auf die Musik hatten.

1Es gibt auch pulsfreie Formen der Musikausübung, die jedoch so viel seltener auftreten, dass man sie als Spezialfälle bezeichnen muss.

2 John Bispham: Rhythm in Music: What is it? Who has it? And Why?, in: Music Perception: An Interdisciplinary Journal 24 (2006), S. 125–134.

3Günter Ropohl: Allgemeine Technologie. Eine Systemtheorie der Technik, 3., überarbeitete Auflage, Karlsruhe: Universitätsverlag Karlsruhe 2009, S. 29.

4Friedrich von Gottl-Ottlilienfeld: Wirtschaft und Technik, Tübingen: J. C. B. Mohr 1923 (Grundriss der Sozialökonomie, II. Teil), S. 7–9.

5Ropohl: Allgemeine Technologie, S. 31; diese Definition wurde auch in die Richtlinie 3780 Technikbewertung – Begriffe und Grundlage des VDI (Verein Deutscher Ingenieure e.V.) übernommen.

6Thor Magnusson: Sonic Writing. Technologies of Material, Symbolic and Signal Inscriptions, New York: Bloomsbury Academic 2019, S. 1 f.

7Die Zusammenhänge, die zwischen den Entwicklungen verschiedener programmierbar ablaufender Maschinen (Rechnern, Musikautomaten und Webstühlen) bestehen, skizziert Teun Koetsier: On the prehistory of programmable machines: Musical automata, looms, calculators, in: Mechanism and Machine Theory 36 (2001), S. 589–603.

8Zu arabischen Musikautomaten vgl. Siegfried Zielinski/Eilhard Wiedemann: Allah’s Automata: Artifacts of the Arab-Islamic Renaissance (800–1200), Ostfildern: Hatje Cantz 2015.

9Ebd., S. 21.

10Vgl. Siegfried Zielinski: Archäologie der Medien. Zur Tiefenzeit des technischen Hörens und Sehens, Reinbek bei Hamburg: Rowohlt Taschenbuch 2002.

11Athanasius Kircher: Musurgia universalis sive Ars magna consoni et dissoni in X libros digesta, Rome: Francesco Corbelletti 1650; deutsche Übersetzung von Günter Scheibel, hg. von Markus Engelhardt und Christoph Hust auf: https://www.hmt-leipzig.de/home/fachrichtungen/institut-fuer-musikwissenschaft/forschung/musurgia-universalis/volltextseite.

12Johann Joachim Quantz: Versuch einer Anweisung die Flöte traversiere zu spielen, Berlin 1752, S. 113.

13Zu Mozart und seiner Fantasie in f-Moll für eine mechanische Orgel KV 608, vgl. Annette Richards: Automatic Genius: Mozart and the Mechanical Sublime, in: Music & Letters 80 (1999), S. 366–389.

14Peter Reidemeister: Körper, Seele, Musik, Maschine – Relationen und Wandlungen, in: Michael Harenberg/Daniel Weissberg (Hg.), Klang (ohne) Körper. Spuren und Potenziale des Körpers in der elektronischen Musik, Bielefeld: transcript, S. 45–74, hier S. 65.

15Ebd., S. 68.

16George Antheil: Jazz, in: Der Querschnitt 2 (1922), S. 172 f.

17Hans Heinz Stuckenschmidt: Die Mechanisierung der Musik, in: Pult und Taktstock 2 (1925), zit. nach Nils Grosch: Die Musik der Neuen Sachlichkeit, Stuttgart u. a.: Metzler 1999, S. 51.

18Paul Hindemith: Zu unserem Programm, in: Aufsätze, Vorträge, Reden, hg. von Giselher Schubert, Zürich: Atlantis 1994, S. 16–18, hier S. 16 f.

19Paul Hindemith: Zur mechanischen Musik, in: Ebd., S. 19–24, hier S. 20.

20Ebd., S. 22.

21Comœdia, 23. Februar 1928, S. 1. »Die mechanische Musik erlaubt es, Modellinterpretationen festzulegen. Die Zukunft liegt im vollständig mechanischen Orchester, das vor allem den Vorteil bieten wird, in Umfang und Dauer nicht mehr durch die menschlichen Möglichkeiten eingeschränkt zu sein. […] Ich glaube an die Zukunft der Mechanik in der Musik, an die Entwicklung von Musik durch Maschinen und vielleicht – vielleicht – an die Auferstehung der Oper durch moderne wissenschaftliche Mittel, die allein dazu in der Lage sind, die Probleme zu lösen, die durch die wachsenden Anforderungen an die menschlichen Darsteller entstehen.« – »Indem man sie abschafft?« – »Ja.« (Übersetzung des Autors).

22Adolf Weißmann: Die Entgötterung der Musik, Stuttgart u. a.: Deutsche Verlags-Anstalt 1928, S. 106.

23Marion Saxer: Spiel (mit) der Maschine. Musikalische Medienpraxis in der Frühzeit von Phonographie, Selbstspielklavier, Film und Radio, Bielefeld: transcript 2016, S. 22.

24Vgl. dazu Martha Brech: »Können eiserne Brücken nicht schön sein?«. Über das Zusammenwachsen von Technik und Musik im 20. Jahrhundert, Hofheim: Wolke 2006.

25Cole Gagne/Tracy Caras: Soundpieces. Interviews with American Composers, Metuchen: Scarecrow Press 1982, S. 90.

26Vgl. dazu Matthias Zehnder: Die digitale Kränkung. Über die Ersetzbarkeit des Menschen, Basel: NZZ Libro 2019.

27Jussi Parikka: What is Media Archaeology?, Cambridge: Polity Press 2012, S. 2.

Teil I: Musikgeschichte/Technikgeschichte

1.Experimentelle Tempogestaltung: Emmanuel Ghent und das Coordinome

Rhythm has been a most unyielding problem in recent music, as viewed from the difficulties it presents in notation, performance, and perception, not to mention the very process of composition itself.

Emmanuel Ghent1

Am 15. Januar 1966 wurde in der Konzertreihe Composers Forum in New York Emmanuel Ghents Blechbläserquintett Dithyrambos uraufgeführt. Weil die Instrumente in diesem Werk über weite Strecken gleichzeitig in verschiedenen Tempi zu spielen haben, musste ein technisches Hilfsmittel zur zeitlichen Koordination verwendet werden. Ghent hatte dazu ein eigenes Verfahren entwickelt: Mit einem lochkartengesteuerten Apparat, dem sogenannten Coordinome (Abb. 1.1), erzeugte er Metronomsignale, die auf Tonband aufgezeichnet und den fünf Musikern bei der Aufführung über Ohrhörer zugespielt wurden.2 Anhand dieses Beispiels soll der Frage nachgegangen werden, welche Abhängigkeit zwischen tempopolyphoner Musik und technikgestützter Tempovermittlung besteht. Dazu werden die technischen Details des Coordinome beschrieben und die Arbeitsschritte geschildert, die zur Herstellung der Metronomsignale nötig waren. Zudem werden anhand von Dithyrambos sowie zwei weiteren Werken, die ebenfalls mit dem Coordinome und Ghents Denkweise in Zusammenhang stehen, verschiedene tempopolyphone Kompositionskonzepte betrachtet.

Abbildung 1.1: Das Coordinome.

Quelle: Ghent, The Coordinome in Relation to Electronic Music, S. 33.

Ghent wurde 1925 in Montreal, Kanada, geboren.3 Er betätigte sich seit seiner Jugend als Komponist, schrieb aber insgesamt nur wenige, meist kammermusikalische Werke.4 Trotz dieses früh erwachten Interesses für die kreative Beschäftigung mit Musik begann Ghent erst im Alter von 36 Jahren, privaten Kompositionsunterricht bei Ralph Shapey in New York zu nehmen. Dieser Kompositionsunterricht dauerte von 1961 bis 1963 und scheint Ghent musikalisch stark geformt zu haben. Erst in dieser Zeit begann seine eigentliche Karriere als Komponist und entsprechend ist das erste in seinem offiziellen Werkverzeichnis aufgeführte Werk Entelechy für Viola und Klavier aus dem Jahre 1963. Schon in diesem Werk zeigt sich Ghents kompositorisches Interesse an der Gleichzeitigkeit von regelmäßigen, aber verschieden schnellen Rhythmen. Man kann aber noch nicht von ›echter‹ Tempopolyphonie sprechen, weil er diese Rhythmen mit entsprechenden Notenwerten in einem gemeinsamen Tempo notierte. Um dieses Interesse weiterzuverfolgen, entwarf Ghent eine mechanische Vorrichtung, die er Polynome nannte. Es handelte sich dabei um eine Art tempopolyphones Metronom, das er auch gleich für seine nächsten Kompositionen Triality und Triality II (1964) für Violine, Trompete und Fagott verwendete. In den Performance notes schreibt Ghent bei Triality: »It is intended that this music be played with the assistance of a polynome […] an instrument which can simultaneously beat up to 7 different tempi«, und bei Triality II: »Although it is not absolutely required, the polynome will greatly facilitate the performance of this work. The polynome is an instrument that can maintain multiple separate beats each in fixed relation to each other, at the same or different tempi«.5 Erst nachdem er mit dem Polynome Erfahrungen in der Praxis gesammelt hatte, entwickelte Ghent das Coordinome.

Es war die Kombination von zwei Gegebenheiten, die Ghents Erfindergeist anspornte. Einerseits sein Interesse an tempopolyphoner Musik und andererseits sein Wille, das Mittel, um die Aufführbarkeit einer solchen Musik zu ermöglichen, in einer technischen Lösung zu suchen. Nach einigem Experimentieren war das Coordinome funktionsfähig und Ghent konnte es in der Folge für die Aufführung seiner Werke nutzen. Es wäre aber zu einseitig, im Coordinome bloß das Werkzeug zur Realisierung von komplexen kompositorischen Konzepten zu sehen. Ebenso kann man annehmen, dass Ghent diese kompositorischen Konzepte auch gerade deshalb entwickelte, weil er das Potenzial des technischen Systems ausschöpfen wollte. Es ist also von einer Wechselbeziehung auszugehen: Kompositorische Ideen führten zur Entwicklung einer technischen Lösung, die Verfügbarkeit dieser Technik ihrerseits zu kompositorischen Ideen. Da Ghent in einer Person der Komponist der Werke und der Entwickler des technischen Systems war, führte diese Gegenseitigkeit besonders schnell zu Ergebnissen.

1.1Programmierte Signale

Ghent publizierte 1967 zwei wissenschaftliche Artikel. Im ersten, Programmed Signals to Performers, schildert er die Anwendung des Coordinome aus der Perspektive der Aufführungs- und Kompositionspraxis von Instrumentalmusik,6 im anderen, The Coordinome in Relation to Electronic Music, erläutert er eine völlig andere Verwendung des Coordinome – nämlich als ein Kompositionswerkzeug für elektroakustische Musik –, beschreibt aber die technischen Funktionen viel detaillierter.7 Das Coordinome war im Wesentlichen ein Apparat, der einen Lochstreifen abtastete und akustische Signale ausgab. Ghent entwickelte es zusammen mit Stein G. Raustein an der New York University. Beim Lesen des Lochstreifens wurde bei jedem Loch ein Mechanismus aktiviert, der mittels eines Relais das Eingangssignal für eine kurze Zeit zum Ausgang durchschaltete. Lag also am Eingang ein kontinuierliches Signal an, war das Ausgangssignal nichts anderes als eine rhythmisierte Form dieses Eingangssignals (Abb. 1.2). Ein solcher Schaltmechanismus lag achtmal vor und damit konnte das Coordinome acht verschiedene Signalwege parallel steuern, war also – musikalisch gesprochen – achtstimmig polyphon.

Abbildung 1.2: Blockschaltbild des Coordinome (eine von acht Einheiten).

Quelle: Ghent, The Coordinome in Relation to Electronic Music, S. 34.

Um kurze, geräuschhafte Metronomsignale zu erzeugen, verwendete Ghent in einer frühen Version dieses Signalsystems zunächst für alle Kanäle weißes Rauschen als Eingangssignal und die einzelnen Ausgangssignale wurden den Musiker·innen individuell zugeführt. Dies bedeutete jedoch, an allen Proben und Konzerten auf das Coordinome und eine Person, die es bedienen kann, angewiesen zu sein. Das war offensichtlich zu umständlich, ließ sich aber vermeiden, indem die Ausgangssignale des Coordinome auf Tonband aufgezeichnet wurden. War dieses Tonband einmal produziert, benötigte es für die Wiedergabe bloß eine Bandmaschine und einen Tontechniker und damit eine viel weniger spezialisierte Ausrüstung und Expertise. Da aber für die damaligen Verhältnisse eine achtkanalige Aufzeichnung zu aufwendig gewesen wäre, fand Ghent folgende Lösung: Jeder Kanal erhielt ein eigenes sinusoidales Eingangssignal mit einer bestimmten Frequenz und die rhythmisierten Ausgangssignale wurden zusammengemischt und monophon auf einer einzigen Tonbandspur aufgezeichnet. Um das für die einzelnen Musiker·innen relevante Metronomsignal wieder aus dieser Mischung zu extrahieren, wurden Decoder genannte Bandpassfilter verwendet (Abb. 1.3). Damit die Decodierung mit der nötigen Trennschärfe vorgenommen werden konnte, war es wichtig, dass die Frequenzen genügend Abstand voneinander hatten; Ghent verwendete Frequenzen im Abstand von halben Oktaven, d. h. 250, 350, 500, 700, 1000 Hz usw.

Abbildung 1.3: Blockschaltbild der Signalübertragung zu den Interpreten.

Quelle: Ghent, The Coordinome in Relation to Electronic Music, S. 35.

Für die Übermittlung der Metronomsignale an die Musiker·innen war folgende Infrastruktur nötig: Das Ausgangssignal des Tonbandgeräts wurde durch ein Gerät geführt, das das Signal aufbereitete und von Störgeräuschen befreite, indem erstens alle nicht benötigten Frequenzen herausgefiltert und zweitens nur Signale über einem bestimmten Pegel verstärkt wurden. Gleichzeitig funktionierte dieses Gerät auch als Stromversorgung für die Decoder. Das Kabel zu den Interpreten musste lang genug sein, damit es bis zur Hinterbühne reichte.8 In regelmäßigen Abständen entlang dieses Kabels gab es Anschlüsse, an denen die Interpret·innen ihre Decoder, Apparate etwa von der Größe eines Transistorradios, anschließen konnten.9

Notation der Signalrhythmen

Mit dem Coordinome hatte Ghent einen Apparat entwickelt, um die für die Aufführung seiner Musik benötigten, rhythmisierten Signale zu erzeugen. Doch bevor er das Coordinome überhaupt in Betrieb nehmen konnte, musste er noch etliche Arbeitsschritte ausführen, bis schließlich der benötigte Lochstreifen hergestellt war. Der erste Schritt bestand darin, für alle Instrumente an jeder Stelle der Partitur die Rhythmen der Metronomsignale festzulegen. Dazu mussten die passenden Notenwerte gefunden und das ihnen überlagerte Akzentmuster bestimmt werden, wobei die hier zu treffenden Entscheidungen umso leichter fielen, je eindeutiger sich in der Musik bereits eine bestimmte Metrik finden ließ. Anschließend trug Ghent in der Partitur über dem Notensystem jedes Instruments die rhythmische Struktur des entsprechenden Metronomsignals ein. Dafür verwendete er folgende Schreibweise: Er fasste die Noten mit einem Balken oder mit einer Linie mitten durch die Notenhälse zu Gruppen zusammen und setzte auf die jeweils erste Note einer Gruppe das Zeichen x, womit er bezeichnete, dass dieses Metronomsignal durch einen Akzent hervorgehoben werden sollte. Dadurch schaffte er eine metrische Gliederung, die es den Ausführenden ermöglichte, die Gruppen auch bei der akustischen Wiedergabe der Metronomsignale gut identifizieren zu können (Abb. 1.4).

Abbildung 1.4: Notation der Signalrhythmen.

Quelle: Ghent, Programmed Signals to Performers. A New Compositional Resource, S. 98.

Für die Signale wählte Ghent möglichst einfache Rhythmen aus lauter gleichen Notenwerten. An Stellen mit einem plötzlichen Tempowechsel fügte er entweder vor dem Tempowechsel ein paar vorbereitende Taktschläge im neuen Tempo hinzu, oder er wählte nach dem Tempowechsel eine Schlagunterteilung in kleineren Notenwerten, um das neue Tempo gut zu stützen. Für Abschnitte, bei denen ein neues Tempo mit einer ausgehaltenen Note oder einer Pause beginnt, waren solche vorbereitenden Taktschläge natürlich nicht nötig. Ein weiteres akustisches Zeichen waren sogenannte Tripelsignale, drei schnell aufeinanderfolgende Signale, mit denen wichtige Orientierungspunkte im Stück angezeigt werden konnten, z. B. das Ende einer längeren Pause.

In der Notation des Signalrhythmus gab es weder Taktarten noch Taktstriche; eine metrische Gliederung war jedoch durch die Gruppierung der Taktschläge und die Betonungen gegeben. An gewissen Stellen in der Partitur zog Ghent schraffierte Linien durch alle Notensysteme, um damit zu bezeichnen, wo an den Proben eingesetzt werden kann (Abb. 1.5).

Abbildung 1.5: Ausschnitt aus Dithyrambos: Notensystem mit hinzugefügtem Rhythmus für die Metronomsignale, eine schraffierte Linie, die eine Studienziffer anzeigt, und ein Tripelsignal.

Quelle: Ghent, Dithyrambos, S. 20.

Herstellung des Lochstreifens

Auf das Einrichten der Partitur folgten die Arbeitsschritte, die zur Herstellung des Lochstreifens für das Coordinome und schließlich zur Produktion der Tonbandspur mit den Metronomsignalen führten. Ghent nannte diese Tätigkeiten eine mühselige Fleißarbeit, was sich gut nachvollziehen lässt, da sie tatsächlich ziemlich aufwendig sind und kaum etwas mit Musik, sondern viel mehr mit Mathematik und Technik zu tun haben. Nachdem alle Taktschläge, Akzente und Tripelsignale in der Partitur bezeichnet worden waren, mussten für alle Noten dieses Signalrhythmus die absoluten Zeiten berechnet werden, wozu sich die Verwendung einer Rechenmaschine anbot. Die nunmehr ausgerechneten Zeiten wurden dann von einem professionellen Locher (keypunch operator) oder einem Assistenten manuell auf Lochkarten übertragen. Dafür wurden sogenannte Port-A-Punch-Lochkarten im 40-Spalten-Format verwendet (Abb. 1.6).10 Eine einzelne Karte entsprach einer Sekunde, durch die vorhandene Anzahl an Spalten konnte diese Sekunde in Zeiteinheiten von 1/40-Sekunden (0.025 Sekunden) unterteilt werden. Die Zeilen der Lochkarte entsprachen den einzelnen Stimmen, d. h. den einzelnen Signalkanälen des Coordinome. Ein einzelnes Loch in der Lochkarte erzeugte ein Signal von 0.025 Sekunden Dauer, vier Löcher direkt hintereinander resultierten in einem längeren Signal, was dazu verwendet wurde, die akzentuierten Taktschläge anzugeben. Die Tripelsignale wurden x-x-x gelocht. Nachdem – Karte für Karte, Sekunde für Sekunde – ein Kartensatz für das ganze Stück gelocht worden war, wurde die Information des Kartensatzes in einem sogenannten Stapelverarbeitungsprozess auf einen Lochstreifen übertragen.

Abbildung 1.6: Eine IBM Port-A-Punch-Lochkarte im 40-Spalten-Format.

Quelle: Wikimedia, gemeinfrei.

Dieser Lochstreifen konnte nun vom Coordinome gelesen werden. Da das Coordinome einen Antriebsmotor mit variabler Geschwindigkeit besaß, konnte der Lochstreifen auch so abgetastet werden, dass sich ein anderes Gesamttempo ergab, während die einzelnen Tempi untereinander in derselben Relation blieben. Um die Musik auch in einem gemächlicheren Tempo üben zu können, bot es sich an, für die Probe immer auch ein zweites Tonband vorzubereiten, auf dem die Signalrhythmen in verlangsamtem Tempo aufgezeichnet wurden. Zuletzt mussten auf dem Tonband noch an den entsprechenden Stellen mit einem Klebeband Markierungen angebracht werden, um die ›Studienziffern‹ zu bezeichnen. Damit konnte der Tontechniker, der die Bandmaschine bediente, an den Proben die richtigen Stellen schnell finden und die Wiedergabe präzise starten.

Synchronisationspunkte

Es gibt verschiedene Strategien und Vorgehensweisen beim Komponieren tempopolyphoner Musik. Es kann eine Tempostruktur im Vornherein entworfen werden und die Koinzidenzen, d. h. die Stellen, wo die Taktschläge der verschiedenen Tempi zusammenfallen, so wie sie sich ergeben, können akzeptiert und kompositorisch genutzt werden. Es kann aber auch sein, dass im Prozess der kompositorischen Ausarbeitung der Wunsch aufkommt, das Zusammentreffen der Taktschläge an einer anderen Stelle künstlich zu erzeugen. In seinem Artikel Programmed Signals to Performers spricht Ghent genau diesen Sachverhalt an. In einem Notenbeispiel zeigt er eine kurze Passage für Violine und Cello (Abb. 1.7). Beide Instrumente spielen in verschiedenen Tempi und beide Stimmen sind mit einem Signalrhythmus versehen. Die in dem Notenbeispiel eingetragenen gestrichelten Linien bezeichnen Koordinationspunkte, d. h. Stellen, an denen – aus Gründen, die nicht weiter ausgeführt werden – die beiden Instrumente rhythmisch zusammentreffen müssen. Dies führt jedoch zu folgendem Problem: Zwischen dem zweiten und dritten Koordinationspunkt vergehen vier Sekunden, was sich leicht an der Violinstimme ablesen lässt (vier Viertel im Tempo q = 60). In der Cellostimme ist Tempo = 100 vorgegeben und in diesem Tempo lassen sich vier Sekunden nicht mit einer ganzzahligen Anzahl Viertelnoten ausfüllen.11 Zudem findet genau an dieser Stelle auch ein Tempowechsel von = 100 zu = 84 statt. Dass das neue Tempo mit vier vorbereitenden Metronomsignalen, die die Sechzehntel des neuen Tempos anzeigen, auch noch vorweggenommen werden soll, macht die Sache erst recht kompliziert.12

Abbildung 1.7: Synchronisation durch das Einsetzen eines ›unbestimmten‹ Notenwerts.

Quelle: Ghent, Programmed Signals to Performers. A New Compositional Resource, S. 101.

Die Lösung, die Ghent für dieses Problem vorschlägt, ist einfach, aber elegant. Mit dem Notenkopf w wird ein Notenwert von ›unbestimmter‹ Dauer angezeigt. Dies gilt auch für den Signalrhythmus, wo in dieser Weise ein um einen nicht näher bestimmten Wert verlängerter Taktschlag angezeigt wird. Damit umgeht Ghent die Notwendigkeit, eine zwar rechnerisch korrekte, aber umständliche und schwer leserliche rhythmische Notation verwenden zu müssen. Weil es sich zudem nicht um ein Zeichen aus der traditionellen Notation handelt (z. B. eine Fermate, ein Atemzeichen oder ein Zäsurzeichen), ist es auch frei von jeglichen ungewollten Konnotationen. Diese notationstechnische Lösung erlaubt eine große Freiheit in der Gestaltung von Tempopolyphonien. Weil die Regelmäßigkeit des Taktschlags kurz unterbrochen und (ggf. in einem neuen Tempo) wieder aufgenommen werden kann, bietet sich die Möglichkeit, alle aus der Tempodisposition entstehenden Diskontinuitäten des Taktschlags in einfacher Weise darzustellen.

Der Lösung von Ghent soll hier noch eine alternative Möglichkeit gegenübergestellt werden: Statt einen abrupten Tempowechsel vorzunehmen und einen ›unbestimmten‹ Notenwert bezeichnen zu müssen, könnte das Tempo auch interpoliert werden. Dazu müsste zwischen dem zweiten und dritten Koordinationspunkt in der Cellostimme das Tempo allmählich von = 100 nach = 84 verlangsamt werden, und zwar in einer Art und Weise, dass sich der dritte Koordinationspunkt wieder an der gewünschten Stelle ergibt. Eine Gegenüberstellung mit Ghents Lösung findet sich in Abb. 1.8. Es zeigt sich, dass bei der Variante mit der Tempointerpolation auch die Sechzehntelunterteilung des Signalrhythmus nicht mehr nötig ist, weil das neue Tempo durch den allmählichen Übergang vorbereitet wird. Die ›unbestimmte‹ Zeitdauer, die Ghent auf eine einzige Note legt, wird durch die Interpolation auf mehrere Noten verteilt, wie sich aus der Zeitangabe ablesen lässt.

Abbildung 1.8: Gegenüberstellung von zwei Lösungen für ein Synchronisationsproblem: Ghents Variante mit abruptem Tempowechsel und einem ›unbestimmten‹ Notenwert sowie eine alternative Variante mit einer Interpolation des Tempos.

Man mag darüber spekulieren, weshalb Ghent sich nicht selbst für die Lösung mit einer Interpolation entschied. Verschiedene Gründe könnten ausschlaggebend sein: Ghent wollte nicht mit allmählichen Tempoänderungen (accelerando und ritardando) komponieren, sondern bevorzugte das klare Nebeneinander von konstanten, eindeutig zueinander proportionierten Tempi. Zudem sind die Berechnungen, die nötig werden, solche Tempoänderungen zu koordinieren, mathematisch anspruchsvoll und gehen weit über das bloße Aufaddieren von Schlagdauern, wie es Ghent zur Vorbereitung seiner Lochkarten benötigte, hinaus.13

Mensch und Maschine

Die Auflistung der vielen, teilweise langwierigen Arbeits- und Denkschritte bei der Einrichtung der Partitur, der Berechnung der Signalrhythmen und der Herstellung des Lochbandes macht eine Sache klar: Diese Art der technikgestützten Aufführungspraxis war mit viel Arbeit verbunden und Ghent konnte seine komplexe tempopolyphone Musik nur realisieren, weil er bereit war, diese Arbeit in Kauf zu nehmen. An dieser Stelle soll nochmals ein Blick auf Ghents Biografie geworfen werden, wobei jetzt besonders seine Ausbildung interessiert. Ghent studierte 1942–46 Biochemie an der McGill University in Montreal. Sein Hauptfach war also ein naturwissenschaftliches und seine Beschäftigung mit Musik, so vielfältig sie auch war, fand nebenbei statt. Er besuchte Musikkurse bei diversen Lehrern am McGill Conservatory, lernte Fagott und spielte es im McGill Orchestra. Er komponierte Kammermusik und spielte Sousaphon in der McGill Canadian Officers’ Training Corps Military Marching Band. Nachdem Ghent sein Grundstudium mit einem Bachelor of Science abgeschlossen hatte, studierte er weitere vier Jahre an der medizinischen Fakultät von McGill und erreichte 1950 den Hochschulabschluss Doctor of Medicine. Darauf übersiedelte er 1951 nach New York, besuchte während der nächsten vier Jahre das W. A. White Institute of Psychoanalysis und erhielt 1956 sein Diplom in Psychoanalyse. Trotz seiner offensichtlichen musikalischen Begabung entschied sich Ghent für einen Bildungsweg, der mit einem naturwissenschaftlichen Grundstudium begann.14 Es liegt nahe, eine Verbindung zwischen seinem naturwissenschaftlichen und seinem musikalischen Denken anzunehmen. Man kann eine solche Verbindung einerseits in den konstruktiven und mathematischen Aspekten seiner tempopolyphonen Kompositionskonzepte sehen, andererseits in der Tatsache, dass er die Lösung des Synchronisationsproblems in einem technischen Verfahren suchte und auch bereit war, die ›nicht-musikalischen‹ Arbeitsschritte, die dieses Verfahren mit sich bringt, auf sich zu nehmen.

Nach Dithyrambos verwendete Ghent das Coordinome noch ein zweites Mal als Hilfsmittel zur Koordination verschiedener Tempi. Am 27. September 1966, im selben Jahr, in dem die Premiere von Dithyrambos stattfand, wurde in New York auch Ghents Werk Hex, an Ellipsis für Trompete, elf Instrumente und Tonband uraufgeführt. Hier wurden die Metronomsignale nicht nur dazu verwendet, die Interpret·innen untereinander zu koordinieren, sondern auch, um das gesamte Ensemble mit einem elektroakustischen Zuspiel zu synchronisieren. Dazu kam ein vierspuriges Tonbandgerät zum Einsatz: Eine Spur enthielt die Signale für die Interpret·innen, die restlichen drei Spuren das Zuspiel. Die damit erreichte Präzision im zeitlich koordinierten Zusammenspiel von akustischen Instrumenten und Tonband war bestechend und ließ einen Kritiker der New York Times schreiben: »This wild excursion into the beyond of electronic music, may be the most successful combination of live musicians and tape so far.«15 Bei Hex, an Ellipsis setzte Ghent das Coordinome aber nicht nur dafür ein, die Metronomsignale für die Musiker·innen zu erzeugen, sondern verwendete es auch als Arbeitsgerät für die Herstellung der elektroakustischen Klänge. Er ließ das Coordinome den zeitlichen Ablauf der Klangsynthese kontrollieren, indem er die Ausgangssignale durch einen Digital-analog-Wandler führte und zur Steuerung der spannungsabhängigen Parameter eines Moog-Synthesizers verwendete.16 Hier bahnte sich ein neues Interesse an, dem Ghent sich nun vermehrt zuwandte: die Klangsynthese.

Das nächste Werk, das Ghent komponierte, Helices (1969) für Violine, Klavier und Tonband, ist ebenfalls tempopolyphon, bei etlichen Abschnitten sind zwei verschiedene Metronomzahlen angegeben und manchmal kommen sogar allmähliche Tempoänderungen (accelerando oder ritardando) vor, die nur von einem Instrument ausgeführt werden, während das andere ein konstantes Tempo beibehält. Überraschenderweise ließ Ghent aber für dieses Werk das Coordinome als Mittel zur Tempokoordination weg und versuchte, die Synchronisation durch andere Mittel zu erreichen. So gibt er z. B. an einer Stelle, wo das Klavier = about 64 und die Violine = 116 spielt, die Anweisung: »