Erhalten Sie Zugang zu diesem und mehr als 300000 Büchern ab EUR 5,99 monatlich.

- Herausgeber: Plassen Verlag

- Kategorie: Fachliteratur

- Sprache: Deutsch

Die "großen Neun" haben eines gemeinsam: Sie alle treiben mit Macht die Entwicklung künstlicher Intelligenz (KI) voran – und dieses Thema polarisiert: Entweder ist KI der Heilsbringer schlechthin oder aber eine tödliche Gefahr für die Menschheit. Doch wie heißt es so schön? Die Wahrheit liegt irgendwo dazwischen. Futuristin und Bestsellerautorin Amy Webb macht sich auf die Suche nach der Wahrheit. Sie erklärt unter anderem, weshalb wir KI nicht gigantischen Tech-Konzernen und auch nicht einzelnen Weltmächten wie China überlassen dürfen. Sie zeigt auf, was Politik, Wirtschaft und jeder von uns tun kann, damit künstliche Intelligenz sich am Ende nicht als Fluch, sondern als Segen herausstellt.

Sie lesen das E-Book in den Legimi-Apps auf:

Seitenzahl: 447

Veröffentlichungsjahr: 2019

Das E-Book (TTS) können Sie hören im Abo „Legimi Premium” in Legimi-Apps auf:

Ähnliche

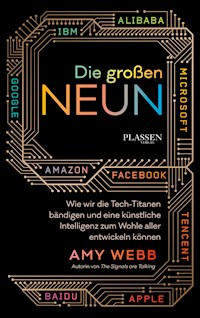

Die großenNEUN

Wie wir die Tech-Titanenbändigen und eine künstlicheIntelligenz zum Wohle allerentwickeln können

AMY WEBB

Autorin von The Signals are Talking

Die Originalausgabe erschien unter dem Titel

THE BIG NINE: How the Tech Titans & Their Thinking Machines Could

Warp Humanity

ISBN 978-1-5417-7375-2

Copyright der Originalausgabe 2019:

Copyright © 2019 by Amy Webb.

All rights reserved.

Published by PublicAffairs, an imprint of Perseus Books, LLC, a subsidiary of Hachette Book Group, Inc.

Copyright der deutschen Ausgabe 2019:

© Börsenmedien AG, Kulmbach

Übersetzung: Petra Pyka

Gestaltung Cover: Pete Garceau, Daniela Freitag

Gestaltung, Satz und Herstellung: Sabrina Slopek

Gesamtherstellung: Daniela Freitag

Lektorat: Sebastian Politz

Druck: GGP Media GmbH, Pößneck

ISBN 978-3-86470-638-7

eISBN 978-3-86470-639-4

Alle Rechte der Verbreitung, auch die des auszugsweisen Nachdrucks, der fotomechanischen Wiedergabe und der Verwertung durch Datenbanken oder ähnliche Einrichtungen vorbehalten.

Bibliografische Information der Deutschen Nationalbibliothek:

Die Deutsche Nationalbibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie; detaillierte bibliografische Daten sind im Internet über <http://dnb.d-nb.de> abrufbar.

Postfach 1449 95305 Kulmbach

Tel: +49 9221 9051-0 Fax: +49 9221 9051-4444

E-Mail: [email protected]

www.plassen.de

www.facebook.com/plassenverlag

Für meinen Vater Don Webb, den authentischstenund intelligentesten Menschen, den ich kenne.

INHALT

EINLEITUNGBevor es zu spät ist

TEIL 1GEISTER IN DER MASCHINE

KAPITEL 1Geist und Maschine – eine ganz kurze Geschichte der KI

KAPITEL 2Die Inselwelt der KI-Stämme

KAPITEL 3Tausend kleine Nadelstiche – die unbeabsichtigten Folgen der KI

TEIL 2SZENARIEN FÜR UNSERE ZUKUNFT

KAPITEL 4Von hier zur künstlichen Superintelligenz – die Warnsignale

KAPITEL 5Das dritte Computerzeitalter als Blütezeit – das optimistische Szenario

KAPITEL 6Mit Millionen von Nadelstichen leben lernen – das pragmatische Szenario

KAPITEL 7Die Réngōng-Zhìnéng-Dynastie – das Katastrophenszenario

TEIL 3DIE LÖSUNG DER PROBLEME

KAPITEL 8Kieselsteine und Felsblöcke – wie sich die Zukunft der KI ins Lot bringen lässt

DANK

QUELLENNACHWEIS

ENDNOTEN

EINLEITUNG

BEVOR ES ZU SPÄT IST

Künstliche Intelligenz gibt es bereits. Allerdings sieht sie anders aus, als wir alle erwartet haben. Sie ist das stille Rückgrat unserer Finanzsysteme, unseres Stromnetzes und der Lieferkette im Einzelhandel. Sie ist die unsichtbare Infrastruktur, die uns durch den Verkehr leitet, uns bei Tippfehlern sagt, was wir eigentlich meinen, und bestimmt, was wir kaufen, anschauen, hören und lesen sollten. Sie ist die Technologie, auf der unsere Zukunft aufbaut, weil sie in alle Aspekte unseres Lebens eingreift: Gesundheit und Medizin, Wohnen, Landwirtschaft, Verkehr, Sport und sogar Liebe, Sex und Tod.

KI ist kein Technologietrend, kein Modewort und kein flüchtiger Zeitvertreib – sie ist das dritte Computerzeitalter. Wir befinden uns mitten in einer maßgeblichen Umwälzung, ganz ähnlich wie die Generation, die die industrielle Revolution erlebte. Damals bemerkte anfangs kaum einer den um sich greifenden Wandel, weil er sich im Verhältnis zu einem Lebensalter so langsam vollzog. Doch am Ende war die Welt nicht mehr wiederzuerkennen: Großbritannien und die Vereinigten Staaten hatten sich zu den beiden dominanten Weltmächten entwickelt und verfügten über das industrielle, militärische und politische Kapital, um den Verlauf des nächsten Jahrhunderts zu prägen.

Alle reden unablässig über KI und darüber, was sie für unsere Zukunft bedeutet. Die gängigen Argumente haben Sie sicher schon gehört: Die Roboter nehmen uns die Arbeitsplätze weg, die Roboter stellen die Wirtschaft auf den Kopf und irgendwann töten die Roboter Menschen. Vor 200 Jahren führten die Menschen die gleichen Diskussionen, nur nicht über „Roboter“, sondern über „Maschinen“. Natürlich machen wir uns Gedanken über die Auswirkungen neuer Technologien auf unsere Jobs und unsere Verdienstmöglichkeiten, denn wir haben ja schon in vielen Branchen erlebt, was Disruption anrichten kann. Verständlicherweise denken wir bei KI unwillkürlich an HAL 9000 aus 2001: Odyssee im Weltraum, WOPR aus WarGames – Kriegsspiele, Skynet aus Terminator, Rosie aus Die Jetsons, Dolores aus Westworld oder eine andere der vielen Hundert vermenschlichten KI aus der Popkultur. Wer nicht unmittelbar im KI-Ökosystem tätig ist, dem erscheint die Zukunft entweder fantastisch oder furchterregend – allerdings aus vollkommen falschen Gründen.

Wer nicht tief in den KI-Forschungs- und Entwicklungsalltag eingebunden ist, kann die Signale nicht deuten, weshalb sich der öffentliche Diskurs über KI auf die Roboter-Obersten aus aktuellen Filmen bezieht oder aber einen manischen, zügellosen Optimismus widerspiegelt. Mangelnde Nuancierung ist Teil des Entstehungsproblems der KI: Manche überschätzen ihre Anwendungsmöglichkeiten gewaltig, während andere behaupten, sie würde eine nicht aufzuhaltende Waffe werden.

Ich weiß das, weil ich den Großteil der letzten zehn Jahre mit der Forschung an KI zugebracht habe und mit Menschen und Organisationen innerhalb und außerhalb des KI-Ökosystems zu tun hatte. Ich habe viele verschiedene Unternehmen im Epizentrum der künstlichen Intelligenz beraten, darunter Microsoft und IBM. Ich habe externe Stakeholder getroffen und beraten: Wagniskapitalgeber und Private-Equity-Manager, führende Mitarbeiter des US-amerikanischen Verteidigungs- und Außenministeriums sowie diverse Parlamentarier, die Regulierung für die einzige Möglichkeit halten. Außerdem habe ich an Hunderten von Sitzungen mit akademischen Forschern und Technologen teilgenommen, die an vorderster Front arbeiten. Wer unmittelbar im KI-Sektor tätig ist, teilt selten die extrem apokalyptischen oder utopischen Zukunftsvisionen, die in den Nachrichten so im Vordergrund stehen.

Der Grund dafür: Alle, die tatsächlich an der Zukunft der KI bauen – ganz ähnlich übrigens wie Forscher in anderen wissenschaftlichen Disziplinen –, würden die Erwartungen gern dämpfen. Es braucht Geduld, Zeit, Geld und Durchhaltevermögen, um wichtige Meilensteine zu erreichen, und das wird gern vergessen. Die Forscher ackern vor sich hin, lösen nach und nach sehr komplizierte Probleme und machen dabei oft nur geringfügige Fortschritte. Diese Menschen sind intelligent, weltoffen und meiner Erfahrung nach auch empathisch und umsichtig.

Die allermeisten von ihnen arbeiten bei neun Tech-Titanen: Google, Amazon, Apple, IBM, Microsoft und Facebook in den Vereinigten Staaten und Baidu, Alibaba und Tencent in China. Sie entwickeln KI, um eine bessere, schönere Zukunft für uns alle einzuläuten. Ich bin der festen Überzeugung, dass die Chefs dieser neun Unternehmen von einem tief empfundenen Altruismus geleitet werden – und von dem Wunsch, dem Allgemeinwohl zu dienen: Sie erkennen ganz klar das Potenzial der KI, das Gesundheitswesen zu verbessern und die Lebenserwartung zu erhöhen, anstehende Klimaprobleme zu lösen und Millionen Menschen aus der Armut herauszuholen. Die konkreten positiven Effekte ihrer Arbeit können wir bereits jetzt in allen Branchen und in unserem Alltag wahrnehmen.

Problematisch ist aber, dass externe Kräfte die neun großen Tech-Unternehmen – und damit alle, die innerhalb des Ökosystems tätig sind – unter Druck setzen und sich gegen deren beste Absichten für unsere Zukunft verschwören. Warum das so ist, liegt auf der Hand.

In den USA machen gnadenlose Marktansprüche und unrealistische Erwartungen in Bezug auf neue Produkte und Dienstleistungen eine langfristige Planung unmöglich. Wir erwarten von Google, Amazon, Apple, Facebook, Microsoft und IBM auf ihren Jahreshauptversammlungen eindrucksvolle Ankündigungen zu neuen KI-Produkten – als ob Durchbrüche in Forschung und Entwicklung planbar wären. Stellen solche Unternehmen nicht jedes Mal noch glanzvollere Produkte vor als im Vorjahr, werten wir das bereits als Misserfolg oder fragen, ob es das schon mit der KI gewesen sei. Oder aber wir äußern Zweifel an der Unternehmensführung. Nie geben wir solchen Firmen ein paar Jahre Zeit, um in Ruhe zu arbeiten, ohne regelmäßig spektakuläre Ergebnisse einzufordern. Wehe, wenn ein solches Unternehmen beschließt, ein paar Monate lang gar keine offiziellen Erklärungen abzugeben – dann deuten wir das Schweigen unweigerlich als Vorboten eines aufsehenerregenden „Skunkworks“-Projekts.

Die US-Regierung hat keine groß angelegte Strategie – weder für KI noch für unsere längerfristige Zukunft. Statt also koordinierte nationale Strategien zu entwickeln, um innerhalb der Regierung organisatorische Kapazitäten aufzubauen, statt unsere internationalen Allianzen zu erweitern und zu stärken und unser Militär auf die Kriegführung der Zukunft vorzubereiten, haben die Vereinigten Staaten die KI der politischen Drehtür überantwortet. Statt Grundlagenforschung über KI zu finanzieren, hat die US-Regierung die Forschung und Entwicklung de facto in die Privatwirtschaft ausgelagert und den Launen der Wall Street überlassen. Statt KI als Chance zur Schaffung neuer Arbeitsplätze und für Wachstum zu begreifen, wittern amerikanische Parlamentarier nur überall technologiebedingte Arbeitslosigkeit. Dafür machen sie wiederum die großen US-Tech-Anbieter verantwortlich. Dabei könnten sie diese Unternehmen einladen, sich auf oberster Regierungsebene an der strategischen Planung zu beteiligen (soweit eine solche überhaupt stattfindet). Unseren KI-Pionieren bleibt gar nichts anderes übrig, als miteinander um einen vertrauensvollen direkten Draht zu Ihnen, zu mir, zu unseren Schulen, unseren Krankenhäusern, unseren Kommunen und unserer Wirtschaft zu wetteifern.

In den Vereinigten Staaten leiden wir unter einem verhängnisvollen Mangel an Weitblick. Unser Vorgehen ist geprägt von einer gegenwartsorientierten Mentalität und unsere Planung fokussiert sich mehr auf die nächsten paar Lebensjahre als auf jeden anderen Zeithorizont. Eine solche Einstellung favorisiert kurzfristige technische Leistungen, entzieht sich aber jeder Verantwortung dafür, wie sich Technologie auf lange Sicht entwickeln könnte, für die Auswirkungen und für die Ergebnisse unseres Handelns. Wir vergessen allzu leicht, dass sich ernsthaft auf die Zukunft auswirken kann, was wir heute tun. Kein Wunder also, dass wir die weitere Entwicklung der KI im Grunde an sechs börsengehandelte Unternehmen delegiert haben, die zwar Erstaunliches zuwege bringen, doch deren finanzielle Interessen nicht immer mit dem in Einklang stehen, was für unsere persönliche Freiheit, unsere Gesellschaft und unsere demokratischen Ideale am besten ist.

In China ist die Entwicklung der KI dagegen fest in die ehrgeizigen Pläne der Regierung eingebunden. China schafft eifrig alle Voraussetzungen, um sich zum unangefochtenen KI-Hegemonen der Welt zu entwickeln. Im Juli 2017 stellte die chinesische Regierung ihren Plan zur Entwicklung der nächsten Generation künstlicher Intelligenz vor, demzufolge sie bis 2030 zum globalen Marktführer in der KI avancieren möchte – mit einer mindestens 150 Milliarden US-Dollar1 schweren Inlandsindustrie. Damit war die Investition eines Teils des staatlichen Investitionsfonds in neue Labors und Start-ups ebenso verbunden wie die Gründung eigener Schulen, um die nächste Generation chinesischer KI-Talente auszubilden.2 Im Oktober desselben Jahres erläuterte der chinesische Präsident Xi Jinping seine Pläne in Bezug auf KI und Big Data ausführlich in einer Rede vor Tausenden von Parteifunktionären. KI, so Xi, werde zu Chinas Übergang in eine der fortschrittlichsten Volkswirtschaften der Welt beitragen. Chinas Wirtschaft ist schon heute 30-mal so groß wie noch vor 30 Jahren. Baidu, Tencent und Alibaba mögen große Aktiengesellschaften sein, doch wie alle chinesischen Großkonzerne müssen auch sie sich dem Willen Pekings beugen.

Chinas enorme Bevölkerung von 1,4 Milliarden Bürgern liefert dem Land die größte und möglicherweise wichtigste natürliche Ressource des KI-Zeitalters: menschliche Daten. Um die Algorithmen zur Mustererkennung zu verfeinern, sind gewaltige Datenmengen erforderlich – weshalb die chinesischen Systeme zur Gesichtserkennung wie Megvii und SenseTime für Investoren so attraktiv sind. Alle Daten, die von chinesischen Bürgern generiert werden, wenn sie telefonieren, online einkaufen und Fotos in sozialen Netzwerken posten, helfen Baidu, Alibaba und Tencent, erstklassige KI-Systeme zu entwickeln. China hat einen großen Vorteil: Es unterliegt nicht den Datenschutz- und Sicherheitsbeschränkungen, die den Fortschritt in den Vereinigten Staaten bremsen könnten.

Doch wir müssen die Entwicklungsrichtung von KI im breiteren Kontext der übergeordneten Zukunftspläne Chinas betrachten. Im April 2018 hielt Xi eine große Rede über seine Vision für China als globale Cyber-Supermacht. Die Rede wurde von Chinas staatlichem Nachrichtendienst Xinhua in Teilen veröffentlicht. Xi beschreibt darin ein neues Governance-Netzwerk für den Cyberspace und ein Internet, das „positive Informationen verbreiten, den richtigen politischen Kurs beibehalten und die öffentliche Meinung und die Werte in die richtige Richtung lenken“ werde.3 Die autoritären Regelungen, nach denen wir alle leben sollten, wenn es nach China ginge, weichen stark von der Redefreiheit, der Marktwirtschaft und der dezentralen Machtverteilung ab, die wir im Westen so schätzen.

KI ist Teil einer Reihe nationaler Erlasse und Gesetze, die auf die Kontrolle und Überwachung aller innerhalb Chinas generierten Informationen, der Daten seiner Bürger sowie der Daten der Bürger seiner diversen strategischen Partner abzielen. Einer dieser Erlasse schreibt allen ausländischen Unternehmen vor, Daten über chinesische Staatsbürger auf Servern innerhalb der Grenzen Chinas zu speichern. Dadurch können staatliche Sicherheitsorgane nach Belieben auf personenbezogene Daten zugreifen. Eine andere Initiative – die chinesische Polizei-Cloud – soll Menschen mit psychischen Störungen überwachen und verfolgen, aber auch Personen, die die Regierung öffentlich kritisiert haben sowie die muslimische ethnische Minderheit der Uiguren. Im August 2018 erklärten die Vereinten Nationen, es lägen glaubwürdige Berichte darüber vor, dass China ganz im Westen des Landes Millionen von Uiguren in geheimen Lagern festhalte.4 Chinas Integrated Joint Operations Platform setzt KI ein, um Musterabweichungen zu erkennen – ob zum Beispiel jemand seine Rechnungen nicht pünktlich zahlt. Ein KI-gestütztes Sozialkreditsystem wurde einem Leitsatz in den offiziellen Planungsdokumenten zufolge entwickelt, um eine problemfreie Gesellschaft zu errichten, indem „dem Vertrauenswürdigen jede Bewegungsfreiheit ermöglicht wird, während der Diskreditierte kaum noch einen Schritt tun kann“.5 Um die „Vertrauenswürdigkeit“ zu fördern, werden die Bürger anhand verschiedener Datenpunkte eingestuft wie „Heldentaten“ (für die Extrapunkte vergeben werden) oder „Strafzettel“ (für die Punkte abgezogen werden). Wer eine niedrige Punktzahl hat, tut sich schwerer, wenn er eine Arbeitsstelle finden, ein Eigenheim kaufen oder seine Kinder in einer Schule anmelden möchte. In einigen Städten werden Fotos der punktestarken Bewohner ausgestellt.6 In anderen Städten wie Shandong werden Bürger, die als Fußgänger die Verkehrsregeln missachten, schon öffentlich auf digitalen Anzeigetafeln angeprangert und die Bilder werden automatisch an das beliebte soziale Netzwerk Weibo weitergeschickt.7 Wem das so fantastisch vorkommt, dass er es kaum glauben mag, der sollte sich vergegenwärtigen, dass China auch erfolgreich eine Ein-Kind-Politik durchgesetzt hat, um einen Rückgang der Bevölkerungszahl zu erzwingen.

Diese politischen Maßnahmen und Strategien sind Ideen aus dem inneren Kreis um Präsident Xi Jinping, der sich die letzten zehn Jahre lang ganz und gar auf die Entwicklung einer neuen Identität Chinas und dessen Umbau zu unserer vorherrschenden globalen Supermacht konzentriert hat. China ist heute autoritärer als unter allen vorausgegangenen Regierungschefs seit dem Vorsitzenden Mao Tse-tung und die Förderung und Nutzung von KI sind grundlegende Voraussetzungen für Xis Anliegen. Die Belt-and-Road-Initiative ist eine groß angelegte geoökonomische Strategie, verkleidet als Infrastrukturprogramm nach dem Vorbild der alten Seidenstraßenrouten, die China über den Nahen Osten und Afrika mit Europa verbanden. China baut nicht nur Brücken und Straßen, es exportiert im Zuge dessen auch seine Überwachungstechnik, sammelt Daten und vergrößert zudem nebenbei auch den Einfluss seiner Kommunistischen Partei in aller Welt, was unserer derzeitigen liberalen demokratischen Ordnung diametral entgegensteht. Eine weitere solche nationale Strategie, die Xi verfolgt, ist die Global Energy Interconnection. Sie soll das erste globale Stromnetz der Welt einrichten und verwalten. China hat bereits Wege gefunden, eine neuartige Ultra-Hochspannungskabeltechnologie zu skalieren, die Strom aus seinem äußersten Westen bis nach Schanghai liefern kann – und es schließt bereits Verträge ab, um seine Nachbarländer mit Energie zu versorgen.

Diese und viele weitere Initiativen sind clevere Methoden, sich langfristig auf nichtmilitärischem Wege Macht zu sichern. Ein brillanter Schachzug von Xi, dessen Partei im März 2018 dafür stimmte, seine Amtszeit nicht mehr zu befristen, sodass er im Prinzip lebenslang Präsident bleiben kann. Xis Endziel ist glasklar: Er will eine neue Weltordnung schaffen, in der China de facto den Ton angibt. Und genau in dieser Phase von Chinas diplomatischer Expansion ziehen sich die Vereinigten Staaten irreparabel aus langjährigen globalen Bündnissen und Verträgen zurück, während Präsident Trump einen neuen Bambusvorhang errichtet.

Die Zukunft der KI entwickelt sich derzeit in zwei Richtungen, die in vieler Hinsicht nicht dem entsprechen, was das Beste für die Menschen wäre. Chinas KI-Vorstoß ist Teil eines koordinierten Versuchs, eine neue Weltordnung unter Führung von Präsident Xi zu errichten, während in Amerika Marktkräfte und Konsumdenken die Hauptmotive sind. Diese Dichotomie ist für uns alle ein schwerwiegender Nachteil. Könnten wir sie auflösen, entfiele damit auch das anstehende Kernproblem mit der KI – und genau das soll dieses Buch erreichen. Die neun Großunternehmen verfolgen möglicherweise dasselbe hehre Ziel – den Code maschineller Intelligenz zu knacken, um Systeme zu bauen, die wie Menschen denken können –, doch das Ergebnis ihrer Arbeit könnte der Menschheit nicht wiedergutzumachenden Schaden zufügen.

Ich halte KI grundsätzlich für eine positive Kraft – eine Kraft, die die nächsten Generationen der Menschheit voranbringen und uns helfen wird, unsere idealistischeren Zukunftsvisionen zu verwirklichen.

Aber ich bin auch Pragmatikerin. Wir alle wissen, dass Menschen auch in bester Absicht ungewollt viel Unheil anrichten können. In der Technologie und vor allem im Zusammenhang mit KI müssen wir uns stets ganz bewusst sowohl auf die angestrebten Nutzungsmöglichkeiten als auch auf unbeabsichtigten Missbrauch einstellen. Das gilt vor allem für heute und die absehbare Zukunft, in der KI in alles hineinspielt: Weltwirtschaft, Erwerbsbevölkerung, Landwirtschaft, Verkehr, Bankwesen, Umweltüberwachung, Bildung, Militär und nationale Sicherheit. Bleibt KI in den USA und in China auf ihrem aktuellen Entwicklungskurs, könnte die Welt daher im Jahr 2069 ganz anders aussehen als im Jahr 2019. Stützen sich Strukturen und Systeme der Gesellschaft vermehrt auf KI, werden wir feststellen, dass in unserem Namen getroffene Entscheidungen womöglich für Maschinen vollkommen logisch sind – nur für uns nicht.

Wir Menschen verlieren unsere Erkenntnis ebenso schnell, wie die der Maschinen zum Leben erwacht. Wir passieren die ersten wichtigen Meilensteine in der technischen und geopolitischen Entwicklung von KI, doch mit jedem neuen Fortschritt verschwindet die KI immer mehr aus unserem Blickfeld. Wie unsere Daten gewonnen und aufbereitet werden, ist immer weniger offensichtlich, und die Entscheidungsprozesse autonomer Systeme werden immer undurchsichtiger für uns. Es tut sich daher eine Verständniskluft bezüglich der Frage auf, wie sich KI im Moment auf unseren Alltag auswirkt, und diese Kluft wird sich in künftigen Jahren und Jahrzehnten exponentiell vergrößern. Die Distanz möglichst zu verringern durch eine Kritik an dem Entwicklungskurs, auf dem sich die KI derzeit befindet, ist meine Mission mit diesem Buch. Mein Ziel ist es, die Diskussion über künstliche Intelligenz zu demokratisieren und Ihnen mehr Informationen darüber zu liefern, was uns bevorsteht – damit die realen Auswirkungen der KI auf unsere Zukunft für Sie ganz persönlich konkret und relevant werden, bevor es zu spät ist.

Die Menschheit steht vor einer existenziellen Krise im eigentlichen Wortsinn – weil sich niemand mit der einfachen Frage auseinandersetzt, die für KI von Anfang an so grundlegend ist: Was passiert mit der Gesellschaft, wenn wir Macht auf ein System übertragen, das von einer kleinen Gruppe von Menschen entwickelt wurde und Entscheidungen für alle treffen soll? Was passiert, wenn solche Entscheidungen von Marktkräften oder von parteipolitischem Ehrgeiz beeinflusst werden? Die Antwort spiegelt sich in unseren Zukunftschancen, in der Art und Weise, wie uns der Zugang verwehrt wird, in unseren gesellschaftlichen Konventionen, in den Regeln, nach denen unsere Wirtschaft funktioniert, und sogar in unseren zwischenmenschlichen Beziehungen wider.

Dies ist kein Buch über die üblichen Debatten um KI. Es ist Warnung und Konzept für eine bessere Zukunft zugleich. Es stellt die Abneigung gegen langfristige Planungen in den Vereinigten Staaten infrage und macht deutlich, wie schlecht unsere Unternehmen, Bildungsstätten und Behörden auf KI vorbereitet sind. Es zeichnet ein schonungsloses Bild der verwobenen geopolitischen, wirtschaftlichen und diplomatischen Strategien Chinas im Zuge der Umsetzung seiner großen Vision von einer neuen Weltordnung. Und es fordert zu kühner Führung unter extrem schwierigen Bedingungen auf. Denn, wie Sie bald merken werden: Unsere gemeinsame Zukunft braucht einen Helden.

Es folgt ein Handlungsaufruf in drei Teilen. Im ersten Teil erfahren Sie, was KI eigentlich ist und welche Rolle die großen Neun bei ihrer Entwicklung spielen. Außerdem tauchen wir tief ein in die jeweiligen Situationen, vor denen die großen Neun stehen – die betroffenen Unternehmen in Amerika und Baidu, Alibaba und Tencent in China. Im zweiten Teil werden Ihnen detaillierte, plausible Zukunftsszenarien für die nächsten 50 Jahre im Zuge der Weiterentwicklung von KI präsentiert. Die drei vorgelegten Szenarien reichen von optimistisch über pragmatisch bis zu katastrophal und offenbaren die Chancen und die Risiken im Zuge unserer Entwicklung von schwacher künstlicher Intelligenz zu starker künstlicher Intelligenz und künstlicher Superintelligenz. Diese Szenarien sind durchaus krass – sie sind das Ergebnis datengesteuerter Modelle und vermitteln Ihnen einen tiefgehenden Eindruck von der potenziellen Entwicklung der KI und ihren Auswirkungen auf unser Leben. Im dritten Teil biete ich taktische und strategische Lösungen für alle Probleme an, die in den Szenarien ermittelt werden, sowie einen konkreten Plan zum Neustart der aktuellen Konfiguration. Der dritte Teil soll uns den nötigen Ruck geben, aktiv zu werden. Daher enthält er spezifische Empfehlungen für unsere Regierungen, die Manager der großen Neun und auch für Sie ganz persönlich.

Jeder heute lebende Mensch kann für die Zukunft der künstlichen Intelligenz eine entscheidende Rolle spielen. Die Entscheidungen, die wir heute über KI treffen – selbst die scheinbar banalen –, werden den Lauf der Menschheitsgeschichte für immer verändern. Wenn die Maschinen erwachen, merken wir möglicherweise, dass unsere KI-Systeme trotz unserer Hoffnungen und altruistischen Ambitionen verheerend für die Menschheit sind.

So muss es aber nicht kommen.

Die großen Neun sind nicht die Bösewichte in dieser Geschichte. Sie sind vielmehr unsere größten Hoffnungsträger.

Lesen Sie weiter. Wir können nicht einfach abwarten und zusehen, was kommt. KI ist nämlich schon da.

Teil 1

GEISTER IN DER MASCHINE

KAPITEL 1

GEIST UND MASCHINE – EINE GANZ KURZE GESCHICHTE DER KI

Die Wurzeln der modernen künstlichen Intelligenz reichen Hunderte von Jahren zurück, in eine Zeit, lange bevor die großen Neun KI-Agenten mit Namen wie Siri, Alexa oder ihr chinesisches Gegenstück Tiān Māo entwickelt haben. Die ganze Zeit über gab es nie die eine klare Definition für KI, wie es sie für andere Technologien gibt. KI ist nicht so einfach konkret zu beschreiben, denn KI kann für so Vieles stehen, und dieser Bereich wächst ständig weiter. Was noch in den 1950er-Jahren als KI galt – ein Rechner, der in der Lage war, schriftlich zu dividieren –, erscheint heute kaum noch als fortschrittliche technische Entwicklung. Das wird auch als „seltsames Paradoxon“ bezeichnet: Ist eine neue Technologie erst einmal erfunden und hat sich massenhaft verbreitet, wird sie für uns unsichtbar. Prompt halten wir eine solche Technologie nicht mehr für KI.

In ihrer einfachsten Form ist künstliche Intelligenz ein System, das autonome Entscheidungen trifft. Die Aufgaben, die KI erfüllt, duplizieren oder ahmen Akte menschlicher Intelligenz nach – wie die Erkennung von Geräuschen und Gegenständen, die Problemlösung, das Sprachverständnis und den Einsatz von Strategie, um Ziele zu erreichen. Manche KI-Systeme sind ungeheuer breit angelegt und führen rasend schnell Millionen von Berechnungen durch, andere sind dagegen sehr eng gefasst und nur für eine bestimmte Aufgabe gedacht, etwa zum Aufspüren von Schimpfwörtern in E-Mails.

Die Fragen, die sich uns dazu aufdrängen, sind immer wieder dieselben: Können Maschinen denken? Was würde es für eine Maschine bedeuten, zu denken? Was bedeutet es für uns, zu denken? Was ist Denken eigentlich? Woher wollen wir – definitiv und zweifelsfrei – wissen, dass wir wirklich originelle Gedanken haben? Solche Fragen begleiten uns seit Jahrhunderten und sie stehen im Mittelpunkt der Gegenwart und Zukunft der KI.

Bei der Untersuchung, wie Maschinen und Menschen denken, stellt sich folgendes Problem: Das Wort „denken“ ist untrennbar mit dem Begriff „Geist“ verbunden. Im Merriam-Webster Dictionary wird „denken“ definiert als „im Geist bilden oder haben“, während das Oxford Dictionary die Bedeutung folgendermaßen erklärt: „seinen Geist aktiv nutzen, um zusammenhängende Ideen zu entwickeln“. Schlagen wir das Wort „Geist“ in beiden Quellen nach, wird es im Kontext von „Bewusstsein“ definiert. Doch was ist Bewusstsein? Laut beiden Nachschlagewerken ist es die Eigenschaft oder Verfassung, zu begreifen und zu reagieren. Unterschiedliche Gruppierungen – Psychologen, Neurowissenschaftler, Philosophen, Theologen, Ethiker und Informatiker – nähern sich dem Konzept des Denkens auf verschiedenen Wegen.

Wenn Sie Alexa einsetzen, um herauszufinden, ob in Ihrem Lieblingslokal noch ein Tisch frei ist, treten Sie beide bewusst in einen Dialog über das Essen ein, obwohl Alexa nicht weiß, wie es sich anfühlt, wenn man in einen knackigen Apfel beißt, kohlensäurehaltiges Mineralwasser auf der Zunge prickelt oder Erdnussbutter am Gaumen klebt. Bitten Sie Alexa, die Eigenschaften solcher Lebensmittel zu beschreiben, so schildert sie Ihnen en détail, wie Sie diese erleben. Alexa hat aber keinen Mund – wie kann sie da Nahrung so wahrnehmen, wie Sie das tun?

Sie sind ein biologisch einzigartiges Individuum, dessen Speicheldrüsen und Geschmacksknospen ein bisschen anders angeordnet sind als beispielsweise meine. Trotzdem wissen wir beide aus Erfahrung, was ein Apfel ist und wie ein Apfel im Allgemeinen schmeckt, welche Beschaffenheit er hat und wie er riecht. Wir haben im Lauf unseres Lebens gelernt, einen Apfel zu erkennen – und zwar durch Verstärkungslernen. Jemand hat uns beigebracht, wie ein Apfel aussieht, wozu er gut ist und was ihn von anderen Früchten unterscheidet. Mit der Zeit und ohne dass wir uns dessen bewusst waren, konnten unsere autonomen biologischen Mustererkennungssysteme immer besser bestimmen, was ein Apfel ist – selbst wenn uns nur ein paar der nötigen Datenpunkte zur Verfügung standen. Schon wenn Sie nur den zweidimensionalen Umriss eines Apfels in Schwarz-Weiß sehen, wissen Sie, worum es sich dabei handelt – obwohl Geschmack, Geruch, Knackigkeit und all die anderen Daten fehlen, die Ihrem Gehirn signalisieren: Das ist ein Apfel. Doch Sie und Alexa haben auf eine viel ähnlichere Art und Weise gelernt, was ein Apfel ist, als Sie sich vielleicht vorstellen können.

Alexa ist kompetent – aber ist sie auch intelligent? Muss ihre maschinelle Wahrnehmung sämtliche Qualitäten menschlicher Wahrnehmung haben, damit wir ihr „Denken“ als gleichwertige Spiegelung des unseren anerkennen? Der Bildungspsychologe Dr. Benjamin Bloom befasste sich im Zuge seiner akademischen Laufbahn vor allem mit der Erforschung und Klassifizierung des Denkens. 1956 veröffentlichte er seine berühmte Taxonomie zur Klassifizierung von Lernzielen und Bildungsstufen. Die Grundlage bildet das Erlernen von Fakten und grundlegenden Konzepten, gefolgt vom Verständnis und der Anwendung des Wissens in neuen Situationen, der Bewertung, Rechtfertigung und Beurteilung von Informationen und schließlich eigener kreativer Gedanken. Als Kinder sind wir zunächst auf das Lernen und Verstehen fokussiert. So müssen wir erst lernen, dass eine Flasche Milch enthält, bevor wir verstehen, dass die Flasche eine Vorder- und eine Rückseite hat, obwohl wir sie nicht sehen.

Dieselbe Hierarchie gilt auch für das maschinelle Lernen. 2018 komponierte und produzierte ein KI-System namens Amper selbst Musik für das Album I AM AI. Harmoniefolge, Instrumentierung und Percussion wurden von Amper entwickelt, auf der Grundlage ursprünglicher Parameter wie Genre, Stimmung und Länge. So entstanden in wenigen Minuten komplette Stücke. Die (menschliche) Künstlerin Taryn Southern arbeitete mit Amper an dem Album zusammen – und das Resultat ist die stimmungs- und seelenvolle Ballade „Break Free“ mit über 1,6 Millionen YouTube-Aufrufen, die im klassischen Radio zum Hit wurde. Doch bevor Amper diesen Song erschaffen konnte, musste das System erst lernen, welche qualitativen Elemente und quantitativen Daten eine große Ballade ausmachen – wie man Notenwerte und Taktschläge berechnet und wie man in der Musik Tausende von Mustern erkennt (zum Beispiel Akkord- und Harmoniefolgen und rhythmische Akzente).

Kreativität, wie sie von Amper an den Tag gelegt wurde, ist der Höhepunkt der Bloom’schen Taxonomie – doch war sie schlicht ein eingelernter mechanischer Prozess? Oder ein Beispiel für menschenähnliche – oder eine ganz anders geartete – Kreativität? Hat Amper so über Musik gedacht wie ein menschlicher Komponist? Man könnte behaupten, dass Ampers „Gehirn“ – ein neuronales Netz, das in einem Gehäuse Algorithmen und Daten einsetzt – vielleicht nicht so anders ist als das Gehirn eines Beethoven aus organischen Neuronen, das in dem Gehäuse seines Schädels Daten verarbeitet und Muster erkennt. Unterschied sich der kreative Prozess von Amper tatsächlich von dem Beethovens, als dieser seine Fünfte komponierte, die mit dem berühmten Da-da-da-DAMM, Da-da-da-DAMM beginnt, um dann von Dur in Moll zu wechseln? Beethoven hat die ganze Sinfonie nicht komplett neu erfunden – auf diese ersten vier Noten folgen eine harmonische Sequenz, Teile von Tonleitern, Arpeggios und andere übliche Zutaten, aus denen viele Kompositionen bestehen. Hören Sie beim Scherzo vor dem Finale genau hin, und sie erkennen Muster, die er sich bei Mozarts Sinfonie Nr. 40 ausgeborgt hat, die 20 Jahre zuvor geschrieben worden war – 1788 nämlich. Mozart stand unter dem Einfluss seines Rivalen Antonio Salieri und seines Freundes Franz Joseph Haydn, die ihrerseits von den Werken früherer Komponisten wie Johann Sebastian Bach, Antonio Vivaldi und Henry Purcell und deren Musik beeinflusst waren, die von Mitte des 17. bis Mitte des 18. Jahrhunderts entstand. In ihren Kompositionen lassen sich auch Parallelen zu noch älteren Komponisten aus dem 15. bis 17. Jahrhundert erkennen, wie Jakob Arcadelt, Jean Mouton und Johannes Ockeghem. Und diese wiederum waren geprägt von den frühesten Komponisten des Mittelalters – wir könnten das Einflussmuster zurückverfolgen bis zur allerersten schriftlichen Komposition, der sogenannten „Seikilos-Stele“, einer Marmorsäule von einer altgriechischen Grabstätte aus dem 1. Jahrhundert, in die eine musikalische Notation eingemeißelt war. Wir könnten sogar noch weiter zurückgehen – bis in die Zeit, als aus Knochen und Elfenbein die ersten primitiven Flöten geschnitzt wurden, vermutlich vor 43.000 Jahren. Dabei geht die Forschung davon aus, dass unsere frühesten Vorfahren davor schon gesungen haben, bevor sie sprechen lernten.1

Wie wir Menschen „verdrahtet“ sind, ist das Ergebnis von Jahrmillionen der Evolution. Die Verdrahtung der modernen KI basiert auf einer ganz ähnlichen langen evolutionären Entwicklung, die bis zu den Mathematikern, Philosophen und Wissenschaftlern der Antike zurückreicht. Menschheit und Maschinen haben nur dem Anschein nach unterschiedliche Pfade eingeschlagen. In Wirklichkeit war unsere Evolution stets miteinander verflochten. Der Homo sapiens lernte aus seinem Umfeld und gab Eigenschaften an künftige Generationen weiter, diversifiziert und repliziert durch die Erfindung fortschrittlicher Technologien wie Landwirtschaft, Jagdwerkzeuge und Penicillin. Es dauerte 11.000 Jahre, bis aus den 6 Millionen Erdenbürgern der Neusteinzeit die 7 Milliarden Menschen geworden waren, die die Erde heute bevölkern.2 Das von KI-Systemen „bewohnte“ Ökosystem – die Parameter für Lernen, Daten, Algorithmen, Prozessoren, Maschinen und neuronale Netze – verbessert und wiederholt sich exponentiell. Es wird nur Jahrzehnte dauern, bis sich KI-Systeme verbreiten und in alle Lebensbereiche Eingang finden.

Ob Alexa nun einen Apfel genauso wahrnimmt wie wir und ob Ampers Kompositionen wirklich „originell“ sind, sind im Grunde Fragen zu unserer Auffassung vom Denken. Unsere heutige künstliche Intelligenz ist eine Mischung aus dem, was Philosophen, Mathematiker, Wissenschaftler, Roboteringenieure, Künstler und Theologen in Tausenden von Jahren hervorgebracht haben. Ihr Ziel – und unseres in diesem Kapitel – ist, den Zusammenhang zwischen dem Denken und den Denkfabriken zu begreifen. Welcher Zusammenhang besteht zwischen dem menschlichen Geist und den – oder ungeachtet der – Maschinen, die von den großen Neun in China und den Vereinigten Staaten gebaut werden?

Gibt es den Geist in der Maschine?

Die Grundlagen der KI lassen sich bis ins antike Griechenland zurückverfolgen, zu den Ursprüngen der Philosophie, der Logik und der Mathematik. In vielen Schriften Platons sagt Sokrates „Erkenne dich selbst“ und er meinte damit, um sich zu verbessern und die richtigen Entscheidungen zu treffen, müsse man zunächst den eigenen Charakter kennen. Neben anderen Errungenschaften erfand Aristoteles den Syllogismus und unser erstes formallogisches System zur Deduktion. Etwa zeitgleich entwickelte der griechische Mathematiker Euklid eine Methode, den größten gemeinsamen Teiler zweier natürlicher Zahlen zu ermitteln. Damit hatte er den ersten Algorithmus in die Welt gesetzt. Aus ihrer Arbeit erwuchsen zwei maßgebliche neue Ideen: dass bestimmte physikalische Systeme nach logischen Regeln funktionieren und dass das menschliche Denken selbst ein symbolisches System sein könnte. Das regte Philosophen, Theologen und Wissenschaftler zu jahrhundertelangen Nachforschungen an. War der Körper eine komplexe Maschine? Ein Gefüge aus Hunderten weiterer Systeme, die alle zusammenarbeiteten – wie in einer großen Standuhr? Und der Geist? War er ebenfalls eine komplexe Maschine? Oder etwas ganz anderes? Ein göttlicher Algorithmus oder der Zusammenhang zwischen dem Geist und der physischen Welt ließ sich weder be- noch widerlegen.

Im Jahr 1560 baute ein spanischer Uhrmacher namens Juanelo Turriano einen kleinen mechanischen Mönch, den er im Namen König Philipps II., dessen Sohn sich auf wundersame Weise von einer Kopfverletzung erholt hatte, der Kirche zum Geschenk machte.3 Der Mönch hatte erstaunliche Fähigkeiten – er konnte über den Tisch laufen, ein Kruzifix und einen Rosenkranz hochheben, sich reuevoll auf die Brust schlagen und seine Lippen bewegen, als würde er beten. Er war der erste Automat – die mechanische Darstellung eines Lebewesens. Das Wort „Roboter“ existierte zwar noch nicht, doch der Mönch war eine bemerkenswerte kleine Erfindung, die das Publikum damals schockiert und verwirrt haben musste. Seinerzeit kam wohl kaum jemand auf den Gedanken, dass ein kleiner Automat irgendwann in ferner Zukunft nicht nur einfache Bewegungen nachahmen, sondern in den Fertigungsstraßen von Fabriken, in Forschungslabors und in Gesprächen am Küchentisch den Menschen ersetzen könnte.

Der kleine Mönch war die Inspiration für die erste Generation von Roboteringenieuren, die immer komplexere, dem Menschen nachempfundene Maschinen entwickeln wollte: Bald schon konnten Automaten schreiben, tanzen und malen. Das brachte eine Gruppe von Philosophen dazu, Fragen dazu zu stellen, was einen Menschen eigentlich ausmachte. Wenn es möglich war, Automaten zu bauen, die menschliches Verhalten nachahmten, waren Menschen dann von Gott gebaute Automaten? Oder waren wir komplexe Systeme mit der Fähigkeit, logisch und kreativ zu denken?

Der englische Staatstheoretiker und Philosoph Thomas Hobbes beschrieb die rationale Erkenntnis in De corpore, dem ersten Teil seiner großartigen Trilogie über Naturwissenschaft, Psychologie und Politik, als Berechnung. 1655 schrieb er: „Unter rationaler Erkenntnis verstehe ich Berechnung. Berechnen heißt entweder die Summe von zusammengefügten Dingen finden oder den Rest erkennen, wenn eins vom andern abgezogen wird. Also ist rationale Erkenntnis dasselbe wie Addieren und Substrahieren.“4 Doch woher sollten wir wissen, ob wir bei diesem Prozess einen freien Willen hatten?

Als Hobbes am ersten Teil seiner Trilogie schrieb, veröffentlichte der französische Philosoph René Descartes seine Meditationen und fragte darin, ob wir mit Sicherheit sagen könnten, dass das, was wir wahrnehmen, auch real sei. Wie konnten wir unser eigenes Bewusstsein nachweisen? Welcher Beleg war erforderlich, um zu folgern, dass unsere Gedanken wirklich unsere eigenen und die Welt um uns herum real war? Descartes war Rationalist und glaubte, dass man durch Deduktion zu Fakten gelangte. Er führte ein berühmtes Gedankenexperiment durch. Er bat seine Leser, sich vorzustellen, ein Dämon würde gezielt eine Illusion ihrer Welt erschaffen. Wäre die physische, sinnliche Erfahrung der Leserin, in einem See zu schwimmen, nur das Konstrukt des Dämons, könnte sie nicht wissen, dass sie schwamm. Doch Descartes vertrat die Ansicht, wenn sich die Leserin ihrer eigenen Existenz bewusst sei, erfülle sie die Kriterien für Wissen. „Ich bin, ich existiere, wann immer es von mir ausgesprochen oder vom Verstand begriffen wird, ist notwendigerweise wahr“, schrieb er über seinen berühmten Satz.5 Anders ausgedrückt: Unsere Existenz ist über jeden Zweifel erhaben, auch wenn es in unserer Mitte einen trügerischen Dämon gibt. Oder: Ich denke, also bin ich.

Später stellte Descartes in seiner Abhandlung über den Menschen die These auf, dass Menschen vermutlich einen Automaten erschaffen könnten – in diesem Fall in Form eines kleinen Tiers –, der sich nicht von einem echten Tier unterscheiden ließe. Doch selbst wenn wir eines Tages einen mechanischen Menschen entwickelten, würde dieser nie für echt gehalten, so Descartes, weil es ihm an Geist und damit an Seele mangeln würde. Anders als Menschen könnte eine Maschine nie die Kriterien für Wissen erfüllen – sie könnte nie unser Bewusstsein haben. Nach der Auffassung von Descartes fand Bewusstsein im Inneren statt – die Seele war der Geist in den Maschinen unserer Körper.6

Ein paar Jahrzehnte später setzte sich der deutsche Mathematiker und Philosoph Gottfried Wilhelm Leibniz mit der Idee auseinander, dass die menschliche Seele selbst programmiert sei. Er argumentierte, der Geist sei selbst ein Gehäuse. Gott habe die Seele und den Körper von Natur aus als harmonisch geschaffen. Der Körper mochte eine komplexe Maschine sein, doch eine mit einem göttlichen Regelwerk. Unsere Hände bewegen sich, wenn wir das so beschließen. Wir haben aber nicht alle Mechanismen geschaffen oder erfunden, die die Bewegung ermöglichen. Empfinden wir Schmerzen oder Vergnügen, sind diese Empfindungen das Ergebnis eines programmierten Systems, einer kontinuierlichen Kommunikationsleitung zwischen Körper und Geist.

Leibniz entwickelte ein eigenes Gedankenexperiment, um zu veranschaulichen, dass Gedanken und Wahrnehmung untrennbar mit dem Menschsein verbunden seien. Stellen Sie sich vor, sie betreten eine Mühle. In dem Gebäude befinden sich Maschinen, Rohstoffe und Arbeiter. Es ist ein komplexes System aus einzelnen Teilen, die harmonisch auf ein gemeinsames Ziel hinarbeiten. Einen Geist könnte es aber nie haben. Leibniz schrieb: „Wir sehen Bestandteile des ganzen Mühlengetriebes, wie sie sich drehen, aneinanderstoßen, ziehen, allein der Geist, das Denken bleibt uns verborgen.“ Er wollte darauf hinaus, dass, ganz gleich wie hoch entwickelt die Mühle, die Maschine oder der Automat auch sei, Menschen niemals eine Maschine konstruieren könnten, die des Denkens oder der Wahrnehmung mächtig wäre.7

Dennoch faszinierte Leibniz die Vorstellung, Facetten des Denkens wiederzugeben. Ein paar Jahrzehnte zuvor bezeichnete ein wenig bekannter englischer Autor namens Richard Braithwaite, der ein paar Bücher über Sozialverhalten geschrieben hatte, menschliche „Computer“ als hochqualifizierte, schnelle, präzise Menschen, die gut rechnen konnten.8 Währenddessen befasste sich der französische Mathematiker und Erfinder Blaise Pascal, der die Grundlage für das gelegt hatte, was wir heute als Wahrscheinlichkeitsaussage kennen, mit der Automatisierung von Rechenaufgaben. Pascal beobachtete, wie sein Vater mühevoll mit der Hand Steuern berechnete, und wollte ihm die Arbeit erleichtern. Also begann er, an einem automatischen Rechner zu arbeiten, einem mit Zahnrädern und beweglichen Ziffern.9 Die Rechenmaschine funktionierte und regte Leibniz dazu an, seine Gedanken zu präzisieren: Maschinen würden zwar nie eine Seele haben, doch es könnte irgendwann möglich sein, eine Maschine zu bauen, die in der Lage sei, so logisch zu denken wie ein Mensch. 1673 beschrieb Leibniz seine Staffelwalzenmaschine, eine neuartige Rechenmaschine, die ein binäres Entscheidungssystem einsetzte.10 Diese Maschine glich einem Billardtisch mit Kugeln, Löchern, Stöcken und Kanälen. Die Maschine öffnete die Löcher durch Einsatz einer Reihe von Einsen (offen) und Nullen (geschlossen).

Leibniz’ theoretische Staffelwalzenmaschine bereitete den Boden für weitere Theorien, darunter die Vorstellung, wenn sich logisches Denken auf Symbole reduzieren ließe und infolgedessen als Rechensystem analysiert werden könnte, und wenn Geometrieaufgaben durch Symbole und Zahlen gelöst werden könnten, sich dann alles auf Bits reduzieren ließe – auch menschliches Verhalten. Damit wich er maßgeblich von den früheren Philosophen ab: Die Maschinen der Zukunft könnten menschliche Denkprozesse wiedergeben, ohne dadurch gegen die göttliche Vorsehung zu verstoßen. Das Denken erforderte nicht unbedingt Wahrnehmung, Sinne oder Seele. Leibniz stellte sich einen Rechner vor, der in der Lage wäre, allgemeine Aufgaben zu lösen – auch solche, die nicht mathematischer Natur wären. Er stellte die Hypothese auf, dass sich Sprache im Rahmen eines universellen Sprachübersetzers auf atomare mathematische und wissenschaftliche Konzepte reduzieren lassen könnte.11

Folgen Geist und Maschine einfach einem Algorithmus?

Wenn Leibniz damit recht hätte, dass Menschen Maschinen mit Seelen wären und eines Tages seelenlose Maschinen erfinden würden, die in der Lage wären, unsagbare komplexe Gedanken zu fassen, dann könnte es auf der Welt eine binäre Klasse von Maschinen geben: wir und sie. Doch damit hatte die Debatte erst begonnen.

Ab 1738 konstruierte der Künstler und Erfinder Jacques de Vaucanson eine Reihe von Automaten für die französische Akademie der Wissenschaften, darunter auch eine komplexe naturgetreue Ente. Sie imitierte nicht nur die Bewegungen einer lebendigen Ente, schlug mit den Flügeln und pickte Körner, sondern konnte auch den Verdauungsprozess nachahmen. Das lieferte den Philosophen neuen Stoff zum Nachdenken: Wenn etwas aussah und quakte wie eine Ente, war es dann wirklich eine Ente? Gehen wir davon aus, dass die Ente irgendeine Art von Seele hat, wäre das dann ein ausreichender Beleg dafür, dass die Ente auch ein Bewusstsein hat – und alles, was damit zusammenhängt?

Der schottische Philosoph David Hume lehnte die Vorstellung ab, dass die Bestätigung der Existenz als solche bereits der Nachweis eines Bewusstseins sei. Anders als Descartes war Hume Empiriker. Er entwickelte ein neues wissenschaftliches Regelwerk auf der Grundlage beobachtbarer Sachverhalte und logischer Argumente. Während de Vaucanson seine verdauende Ente vorführte – als noch längst keine Rede von künstlicher Intelligenz war –, schrieb Hume in Ein Traktat über die menschliche Natur: „Die Vernunft ist nur ein Sklave der Affekte und sollte nichts anderes sein“. Hier verwendete Hume „Affekte“ im Sinne von „nicht rationalen Motivationen“ und wollte sagen, dass unser Verhalten nicht von abstrakter Logik, sondern von solcherlei Reizen gesteuert wird. Sind Eindrücke schlicht unsere Wahrnehmung dessen, was wir sehen, berühren, fühlen, schmecken und riechen können, und Ideen Wahrnehmungen von Dingen, mit denen wir nicht direkt in Kontakt kommen, so glaubte Hume, dass unsere Existenz und unser Verständnis der Welt um uns herum auf einem Konstrukt menschlicher Wahrnehmung beruhte.

Im Zuge der Fortschritte bei der Arbeit an Automaten, die immer realistischer wurden, und ernsthafterer Überlegungen über Computer und denkende Maschinen nahm der französische Arzt und Philosoph Julien Offray de La Mettrie eine ebenso radikale wie skandalöse Untersuchung über Menschen, Tiere und Automaten in Angriff. In einer 1747 zunächst anonym veröffentlichten Abhandlung schrieb La Mettrie, Menschen seien Tieren erstaunlich ähnlich, und ein Affe könne eine menschliche Sprache erlernen, wenn er „richtig ausgebildet“ würde. La Mettrie folgerte ferner, dass Menschen und Tiere nur Maschinen seien, die von ihren Instinkten und Erfahrungen gesteuert würden. „Der menschliche Körper ist eine Maschine, die selbst ihre Triebfedern aufzieht; … und folgerichtig ist die Seele nur ein Bewegungsprinzip beziehungsweise ein empfindlicher materieller Teil des Gehirns“.12

Die Vorstellung, dass Menschen schlicht materiegesteuerte Maschinen seien – Zahnräder, die bestimmte Funktionen ausführten –, implizierte, dass wir weder besonders noch einzigartig waren. Sie deutete ferner darauf hin, dass wir möglicherweise sogar programmierbar waren. Traf das zu, und waren wir bisher bereits in der Lage gewesen, naturgetreue Enten und kleine Mönche zu bauen, sollte daraus folgen, dass sich der Mensch eines Tages selbst nachbauen – und eine Vielzahl intelligenter, denkender Maschinen konstruieren könnte.

War es möglich, eine denkende Maschine zu bauen?

In den 1830er-Jahren experimentierten die Mathematiker, Ingenieure und Wissenschaftler bereits eifrig in der Hoffnung, Maschinen zu bauen, die dieselben Berechnungen durchführen konnten wie menschliche „Computer“. Die englische Mathematikerin Ada Lovelace und der Wissenschaftler Charles Babbage erfanden die sogenannte „Differenzmaschine“ und postulierten später eine fortschrittlichere „analytische Maschine“, die eine Reihe vorgegebener Schritte einsetzte, um Rechenaufgaben zu lösen. Dass die Maschine womöglich mehr vermochte, als Zahlen zu berechnen, daran hatte Babbage nicht gedacht. Es war Lovelace, die in den Fußnoten zu einer wissenschaftlichen Abhandlung, die sie übersetzte, auf einen brillanten Gedanken verfiel und spekulierte, dass eine leistungsfähigere Version der Maschine auch für andere Zwecke eingesetzt werden könnte.13 Konnte die Maschine Symbole manipulieren, die ihrerseits verschiedenen Dingen zugeordnet werden konnten (wie Musiknoten), dann könnte man sie auch für Denkprozesse außerhalb der Mathematik einsetzen. Sie glaubte zwar nicht, dass ein Computer je dazu fähig sein könnte, selbstständig zu denken, doch sie stellte sich ein komplexes System vor, das Anweisungen befolgen und so viele alltägliche Arbeitsabläufe von Menschen nachmachen könnte. Damals erschien das manchem wenig bemerkenswert, doch Ada hatte im Grunde das erste vollständige Computerprogramm für eine künftige, leistungsfähige Maschine geschrieben – und zwar Jahrzehnte vor der Erfindung der Glühbirne.

Knapp 250 Kilometer nördlich von Cambridge, wo Lovelace und Babbage an der Universität arbeiteten, spazierte ein junger mathematischer Autodidakt namens George Boole in Doncaster über ein Feld, als er eine Eingebung hatte und beschloss, sein Leben der Erklärung der Logik des menschlichen Denkens zu widmen.14 Dieser Spaziergang brachte hervor, was wir heute als Boole‘sche Algebra kennen – eine Methode zur Verallgemeinerung logischer Operatoren (wie „und“, „oder“ und „nicht“) durch die Verwendung von Symbolen und Zahlen. So würde sich aus „richtig und richtig“ „richtig“ ergeben, was physischen Schaltungen und Gattern im Rechner entspricht. Boole brauchte zwei Jahrzehnte, um seine Ideen formell festzuhalten. Und es sollte weitere 100 Jahre dauern, bis jemand merkte, dass die Boole‘sche Logik und Wahrscheinlichkeit dazu beitragen könnte, Computer von automatischen Grundrechnern zu komplexeren Denkmaschinen zu entwickeln. Es war aber noch nicht möglich, eine Denkmaschine zu bauen – die nötigen Prozesse, Werkstoffe und Energie waren noch nicht vorhanden –, sodass die Theorie nicht auf die Probe gestellt werden konnte.

Der Sprung von der theoretischen Denkmaschine zum Rechner, der menschliches Denken nachahmte, vollzog sich in den 1930er-Jahren, als zwei bahnbrechende Arbeiten publiziert wurden: „A Symbolic Analysis of Switching and Relay Circuits“ von Claude Shannon und „On Computable Numbers, with an Application to the Entscheidungsproblem“ von Alan Turing. Shannon studierte Elektrotechnik am MIT und belegte als Wahlfach Philosophie – eine ungewöhnliche Wahl. Primäres Referenzmaterial für Shannons Dissertation war Booles An Investigation of the Laws of Thought. Sein Doktorvater Vannevar Bush animierte ihn dazu, die Boole‘sche Logik auf physikalische Schaltungen zu übertragen. Bush hatte eine weiterentwickelte Version der Analytical Engine – der mechanischen Rechenmaschine von Lovelace und Babbage – gebaut. Der Prototyp seines Analogrechners hieß „Differential Analyzer“ und war vom Konzept her eher eine Ad-hoc-Lösung. Damals existierte noch keine systematische Theorie, die vorschrieb, wie elektrische Schaltungen auszusehen hatten. Shannons Durchbruch bestand darin, dass er Booles symbolische Logik zur Konstruktion elektrischer Schaltungen heranzog und erklärte, wie diese Logik eingesetzt werden konnte, um mit Einsen und Nullen einen funktionstüchtigen Schaltkreis herzustellen. Shannon hatte herausgefunden, dass Computer zwei Ebenen aufwiesen: die physische (das Gehäuse) und die logische (den Code).

Während Shannon daran arbeitete, physikalische Schaltungen mit Boole‘scher Logik zu vereinigen, stellte Turing Leibniz‘ Universalübersetzer auf die Probe, der sämtliches mathematische und naturwissenschaftliche Wissen darstellen konnte. Turing wollte einen Nachweis zum sogenannten Entscheidungsproblem führen. Dieses lautet ungefähr folgendermaßen: Kann es einen Algorithmus geben, der ermitteln kann, ob eine willkürliche mathematische Aussage richtig oder falsch ist? Die Antwort sollte negativ ausfallen. Turing konnte nachweisen, dass kein solcher Algorithmus existiert. Nebenbei erarbeitete er aber ein mathematisches Modell für eine universelle Rechenmaschine.15

Damit veränderte sich alles. Turing dachte, dass ein Programm und die von diesem herangezogenen Daten in einem Computer gespeichert werden konnten – damals in den 1930er-Jahren ebenfalls eine radikale These. Bis dato ging die Konsensmeinung dahin, dass die Maschine, das Programm und die Daten jeweils unabhängige Einheiten waren. Turings Universalrechner erklärte erstmals, warum alle drei Elemente ineinandergriffen. Aus mechanischer Sicht konnte die Logik, die Stromkreisen und Schaltungen zugrunde lag, in dem Programm und den Daten kodiert werden. Diese Aussagen waren von enormer Bedeutung: Das Gehäuse, das Programm und die Daten waren Teil eines Ganzen – vergleichbar mit dem Menschen! Wir sind ebenfalls Gehäuse (unsere Körper), Programme (autonome Zellfunktionen) und Daten (unsere DNA, kombiniert mit indirekten und direkten sensorischen Informationen).

Gleichzeitig kreuzten sich endlich die Wege der langen Tradition der Automaten, die 400 Jahre zuvor mit dem kleinen, gehenden, betenden Mönch begonnen hatte, und der Arbeit Turings und Shannons. Der amerikanische Produzent Westinghouse baute für die Weltausstellung 1939 einen relaisbasierten Roboter namens Elektro the Moto-Man. Es war ein glatter goldfarbener Riese mit Rollen unter den Füßen. Er hatte 48 elektrische Relais, die auf der Grundlage eines Telefon-Relais-Systems funktionierten. Elektro reagierte mittels zuvor aufgezeichneter, über einen Plattenspieler abgespielter Sätze auf Befehle, die über einen Telefonhörer eingegeben wurden. Es handelte sich dabei um einen anthropomorphisierten Computer, der in der Lage war, ohne direkte menschliche Beteiligung in Echtzeit rudimentäre Entscheidungen zu treffen – etwa, was er antworten sollte.

Den Schlagzeilen, Science-Fiction-Kurzgeschichten und Wochenschaunachrichten aus dieser Zeit zufolge hatten die Menschen damit offenbar überhaupt nicht gerechnet und reagierten schockiert und besorgt auf all diese Entwicklungen. Ihnen kam es so vor, als seien die voll entwickelten „Denkmaschinen“ quasi über Nacht auf der Bildfläche erschienen. Der Science-Fiction-Autor Isaac Asimov veröffentlichte mit „Liar!“ in der Ausgabe von Astounding Science Fiction vom Mai 1941 eine visionäre Kurzgeschichte. Er reagierte damit auf die Forschungsergebnisse, die er in Grenzbereichen wahrnahm. Darin trat er für seine drei Gesetze der Robotik ein:

1.Ein Roboter darf einem Menschen weder Schaden zufügen noch durch Untätigkeit zulassen, dass ein Mensch zu Schaden kommt.

2.Ein Roboter muss den Befehlen der Menschen gehorchen, außer solchen Befehlen, die ihn in Konflikt mit dem ersten Gesetz bringen.

3.Ein Roboter muss seine Existenz verteidigen, solange er dabei nicht in Konflikt mit dem ersten und zweiten Gesetz gerät.

Später setzte Asimov noch sein sogenanntes nulltes Gesetz hinzu, das über allen anderen Gesetzen steht: „Ein Roboter darf der Menschheit weder Schaden zufügen noch durch Untätigkeit zulassen, dass die Menschheit zu Schaden kommt.“

Würde eine Denkmaschine wirklich denken?

1943 veröffentlichten die Psychiatrieforscher der Universität von Chicago Warren McCulloch und Walter Pitts ihre wegweisende Arbeit „A Logical Calculus of the Ideas Immanent in Nervous Activity“, die ein neuartiges System zur Modellierung biologischer Neuronen in einer einfachen neuronalen Netzwerkarchitektur für Intelligenz beschrieb. Wenn Gehäuse, Programme und Daten, wie Turing behauptet hatte, ineinandergriffen, und wenn der Mensch ein ähnlich elegant konzipiertes Gehäuse mit der Fähigkeit zur Verarbeitung von Daten war, so folgte daraus, dass es möglich sein könnte, eine denkende Maschine zu bauen, wenn diese den für das Denken zuständigen Teilen des Menschen nachempfunden würde – unseren Gehirnen. McCulloch und Pitts postulierten eine moderne Computertheorie des Geistes und des Gehirns, ein „neuronales Netz“. Statt sich auf die Maschine als Hardware und das Programm als Software zu fokussieren, stellten sie sich ein neuartiges symbiotisches System vor, das in der Lage war, enorme Datenmengen aufzunehmen – genau wie wir Menschen. Computer waren damals noch leistungsfähig genug, um diese Theorie auf die Probe zu stellen – doch das Forschungspapier regte andere dazu an, auf ein neuartiges intelligentes Computersystem hinzuarbeiten.

Klarer wurde das Bindeglied zwischen intelligenten Computersystemen und autonomen Entscheidungsprozessen, als der ungarisch-amerikanische Universalgelehrte John von Neumann mit seinen Fachkenntnissen in Informatik, Physik und Mathematik eine umfangreiche Abhandlung zu angewandter Mathematik veröffentlichte. Das 641 Seiten starke Werk, das er 1944 mit dem Princeton-Ökonomen Oskar Morgenstern als Co-Autor verfasste, erklärte bis ins kleinste Detail, wie die Wissenschaft der Spieltheorie die Grundlage aller wirtschaftlichen Entscheidungen aufdeckte. Diese Arbeit führte zu den gemeinsamen Projekten von Neumanns mit den amerikanischen Streitkräften, die bereits an einem neuartigen elektrischen Rechner gearbeitet hatten: dem Electronic Numerical Integrator and Computer, kurz ENIAC. Ursprünglich waren die Befehle, die dem ENIAC zugrunde lagen, fest in das System eingebunden. Das bedeutete, dass mit jedem neuen Programm das komplette System neu verdrahtet werden musste. Inspiriert von Turing, McCulloch und Pitts, entwickelte von Neumann eine Methode zur Speicherung von Programmen auf dem Rechner. Das war der Übergang vom ersten Computerzeitalter (Tabellierung) in die neue Ära der programmierbaren Systeme.

Turing selbst arbeitete inzwischen an einem Konzept für ein neuronales Netz aus Computern mit einer Maschinenarchitektur mit gespeicherten Programmen. 1949 wurde Turing in The London Times mit folgenden Worten zitiert: „Ich wüsste nicht, warum sie (die Maschine) nicht in beliebige der Bereiche, die gewöhnlich vom menschlichen Intellekt abgedeckt werden, vordringen und mit diesem letztlich gleichberechtigt konkurrieren sollte. Ich würde noch nicht einmal Sonette ausschließen, wenngleich dieser Vergleich möglicherweise nicht ganz fair ist, denn ein von einer Maschine verfasstes Sonett wüsste wohl nur eine andere Maschine richtig zu würdigen.“ Ein Jahr darauf beschäftigte sich Turing in einem in der Philosophiezeitschrift Mind veröffentlichten Artikel mit den von Hobbes, Descartes, Hume und Leibniz aufgeworfenen Fragen. Er stellte darin eine These auf und schlug einen Test vor: Sollte ein Computer eines Tages in der Lage sein, Fragen so zu beantworten, dass er dadurch nicht von einem Menschen zu unterscheiden war, dann lag zwangsläufig ein „Denkprozess“ vor. Sie kennen diesen Artikel vermutlich unter einer anderen Bezeichnung: Turing-Test.

Er begann mit einer mittlerweile berühmten Frage, die schon so viele Philosophen, Theologen, Mathematiker und Wissenschaftler vor Turing gestellt und beantwortet hatten: „Können Maschinen denken?“ Doch Turing, der sich der jahrhundertelangen Diskussion um Geist und Maschine durchaus bewusst war, verwarf die Frage als zu pauschal, um zu einem sinnvollen Diskurs beizutragen. „Maschine“ und „denken“ waren mehrdeutige Wörter und boten zu viel Raum für subjektive Interpretation. (Immerhin war über ihre Bedeutung bereits 400 Jahre lang eifrig geschrieben worden.)

Das Spiel baute auf Täuschung auf und war „gewonnen“, sobald es einem Computer gelang, sich erfolgreich als Mensch auszugeben. Der Test läuft folgendermaßen ab: mit einem Menschen, einer Maschine und einem räumlich von beiden getrennten Fragesteller. Ziel des Spiels ist für den Fragesteller, herauszufinden, welche Antworten von dem Menschen stammen und welche von der Maschine. Dem Fragesteller werden eingangs die Bezeichnungen X und Y mitgeteilt, er weiß aber nicht, welche davon für den Computer steht. Er darf nur Fragen stellen wie: „Kann mir X bitte sagen, ob X Schach spielt?“ Am Ende des Spiels muss der Fragesteller herausfinden, wer X war und wer Y. Der andere Mensch hat die Aufgabe, dem Fragesteller dabei zu helfen, die Maschine zu erkennen. Die Maschine hat die Aufgabe, den Fragesteller fälschlicherweise davon zu überzeugen, dass sie in Wirklichkeit der andere Mensch ist. Über das Spiel schrieb Turing: „Ich bin überzeugt, dass es in rund 50 Jahren möglich sein wird, Computer mit einer Speicherkapazität von rund 109 zu programmieren, die das Nachahmungsspiel so gut beherrschen, dass ein durchschnittlicher Fragesteller nach fünfminütiger Befragung nur mit 70-prozentiger Wahrscheinlichkeit erkennen kann, wer der Mensch ist und wer die Maschine.“16

Doch als Wissenschaftler wusste Turing, dass sich seine Theorie nicht beweisen ließ – zumindest nicht zu seinen Lebzeiten. Wie sich herausstellen sollte, lag das Problem aber nicht in Turings mangelnder empirischer Evidenz zum Nachweis, dass Maschinen eines Tages denken würden, und auch nicht in der Zeitfrage – Turing meinte, es würde vermutlich bis Ende des 20. Jahrhunderts dauern, bis man seinen Test erstmals durchführen könnte. „Wir dürfen hoffen, dass Maschinen irgendwann auf allen rein intellektuellen Gebieten mit Menschen konkurrieren werden“, schrieb Turing. Das eigentliche Problem lag aber in dem nötigen Schritt zu der Überzeugung, dass Maschinen eines Tages sehen, denken und sich erinnern können werden – und dass der Mensch diesem Fortschritt im Wege stehen könnte. Das hätte von Turings Forscherkollegen verlangt, Erkenntnis ohne Spiritualität wahrzunehmen und an die Plausibilität intelligenter Maschinen zu glauben, die – anders als der Mensch – unbewusst Entscheidungen treffen würden.

Sommer und Winter für KI

1955 wollten die Professoren Marvin Minsky (Mathematik und Neurologie) und John McCarthy (Mathematik) zusammen mit Claude Shannon (Mathematiker und Krytpograf bei den Bell Labs) und Nathaniel Rochester (Informatiker bei IBM) einen zweimonatigen Workshop durchführen, um Turings Arbeit und die vielversprechenden Aussichten auf maschinelles Lernen auszuloten. Ihre Theorie: Wenn es möglich war, alle Merkmale menschlicher Intelligenz zu beschreiben, dann konnte man einer Maschine auch beibringen, sie nachzuahmen.17 Dazu war aber eine breite, vielfältige Gruppe von Fachleuten aus vielen verschiedenen Gebieten erforderlich. Sie waren überzeugt, dass man wesentlich vorankommen könnte, wenn eine interdisziplinäre Gruppe von Forschern zusammengerufen würde, die den ganzen Sommer über ununterbrochen intensiv zusammenarbeiten konnte.

Von entscheidender Bedeutung war dabei die Zusammenstellung der Gruppe. Daraus sollte das Netzwerk der wenigen Ingenieure, Sozialwissenschaftler, Informatiker, Psychologen, Mathematiker, Physiker und kognitiven Fachleute werden, die grundlegende Fragen dazu stellen und beantworten würden, was es bedeutet, „zu denken“, wie unser „Geist“ funktioniert und wie man Maschinen beibringen kann, so zu lernen wie wir Menschen. Dahinter stand die Absicht, dass dieses vielfältige Netz auch weiterhin in der Forschung und an der künftigen Entwicklung dieses neuen Fachgebiets zusammenarbeiten würde. Weil es ein neuartiger interdisziplinärer Ansatz zur Entwicklung denkender Maschinen sein sollte, brauchte man auch einen neuen Namen für diese Aktivitäten. Am Ende einigte man sich auf eine zwar nicht ganz eindeutige, doch elegante Bezeichnung: künstliche Intelligenz.