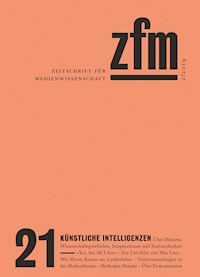

Zeitschrift für Medienwissenschaft 21 E-Book

0,00 €

Mehr erfahren.

- Herausgeber: transcript Verlag

- Kategorie: Geisteswissenschaft

- Serie: ZfM - Zeitschrift für Medienwissenschaft

- Sprache: Deutsch

Die Zeitschrift für Medienwissenschaft steht für eine kulturwissenschaftlich orientierte Medienwissenschaft, die Untersuchungen zu Einzelmedien aufgreift und durchquert, um nach politischen Kräften und epistemischen Konstellationen zu fragen. Sie stellt Verbindungen zu internationaler Forschung ebenso her wie zu verschiedenen Disziplinen und bringt unterschiedliche Schreibweisen und Textformate, Bilder und Gespräche zusammen, um der Vielfalt, mit der geschrieben, nachgedacht und experimentiert werden kann, Raum zu geben.

Selbstfahrende Autos, humanoide Roboter, adaptive Nanodrohnen oder smarte Supermärkte – KI hat als Technologie, Konzept und soziotechnisches Gefüge Konjunktur. Heft 21 der Zeitschrift für Medienwissenschaft fragt nach dem Verhältnis von Medien und KI – nach der Intelligenz unserer Medien/Umgebungen und den Medien künstlicher Intelligenzen. Welche Medien brauch(t)en künstliche Intelligenzen? Warum kann oder muss eine Kritik der KI mit einer Kritik des neoliberalen Kapitalismus und seines Gesellschaftsmodells verzahnt sein? Wie können die Ansätze der Medienwissenschaft genutzt werden, um den ›bias‹ (race, gender, class) von KI-Systemen und -Praktiken zu analysieren?

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 435

Veröffentlichungsjahr: 2019

Ähnliche

2/2019GESELLSCHAFT FÜR MEDIENWISSENSCHAFT (HG.)

EDITORIAL

Medienwissenschaft zu betreiben bedeutet immer auch, sich zu fragen, was die Voraussetzungen und Bedingungen der eigenen Forschung sind. Die Medialität von Dingen und Ereignissen wird häufig erst in der Beschäftigung mit ihrer Theorie und Geschichte, ihrer Technik und Ästhetik freigelegt. In diesem Sinne betreibt die ZfM eine kulturwissenschaftlich orientierte Medienwissenschaft, die Untersuchungen zu Einzelmedien aufgreift und durchquert, um nach politischen Kräften und epistemischen Konstellationen zu fragen.

Unter dieser Prämisse sind Verbindungen zu internationaler Forschung ebenso wichtig wie die Präsenz von Wissenschaftler_innen verschiedener disziplinärer Herkunft. Die ZfM bringt zudem verschiedene Schreibweisen und Textformate, Bilder und Gespräche zusammen, um der Vielfalt, mit der geschrieben, nachgedacht und experimentiert werden kann, Raum zu geben.

Jedes Heft eröffnet mit einem SCHWERPUNKTTHEMA , das von einer Gastredaktion konzipiert wird. Unter EXTRA erscheinen aktuelle Aufsätze, die nicht auf das Schwerpunktthema bezogen sind. DEBATTE bietet Platz für theoretische und/oder (wissenschafts-)politische Stellungnahmen. Die Kolumne WERKZEUGE reflektiert die Soft- und Hardware, die Tools und Apps, die an unserem Forschen und Lehren mitarbeiten. In den BESPRECHUNGEN werden aktuelle Veröffentlichungen thematisch in Sammelrezensionen diskutiert. Die LABORGESPRÄCHE setzen sich mit wissenschaftlichen oder künstlerischen Forschungslaboratorien und Praxisfeldern auseinander. Von Gebrauch, Ort und Struktur visueller Archive handelt die BILDSTRECKE. Aus gegebenen Anlässen konzipiert die Redaktion ein INSERT.

Getragen wird die ZfM von den Mitgliedern der Gesellschaft für Medienwissenschaft, aus der sich auch die Redaktion (immer wieder neu) zusammensetzt. Es gibt verschiedene Möglichkeiten, sich an der ZfM zu beteiligen: (1) die Entwicklung und redaktionelle Betreuung eines Schwerpunktthemas, (2) die Einreichung von Aufsätzen und Reviewessays für das Heft und (3) von Buchrezensionen und Tagungsberichten für die Website. Die Veröffentlichung der Aufsätze erfolgt nach einem Peer-Review-Verfahren. Alle Beiträge sind im Open Access verfügbar. Auf www.zfmedienwissenschaft.de befinden sich das Heftarchiv, aktuelle Besprechungen und Beiträge in den Web-Extras, der Gender-und der Open-Media-Studies-Blog sowie genauere Hinweise zu Einreichungen.

DANIEL ESCHKÖTTER, MAJA FIGGE, JANA MANGOLD, KATHRIN PETERS,FLORIAN SPRENGER, STEPHAN TRINKAUS, THOMAS WAITZ, BRIGITTE WEINGART

INHALT

Editorial

KÜNSTLICHE INTELLIGENZEN

C. ERNST / I . KALDRACK / J. SCHRÖTER / A. SUDMANN

KÜNSTLICHE INTELLIGENZENEinleitung in den Schwerpunkt

CLEMENS APPRICH

Die Maschine auf der Couch Oder: Was ist schon ‹künstlich› an Künstlicher Intelligenz?

G. GRAMELSBERGER / M. RAUTZENBERG / S. WIEMER / M. FUCHS

«Mind the Game!»Die Exteriorisierung des Geistes ins Spiel gebracht

P. KLIMCZAK / I . KUSCHE / C. TSCHÖPE / M. WOLFF

Menschliche und maschinelle Entscheidungsrationalität Zur Kontrolle und Akzeptanz Künstlicher Intelligenz

TOBIAS MATZNER

Autonome Trolleys und andere Probleme Konfigurationen Künstlicher Intelligenz in ethischen Debatten über selbstfahrende Kraftfahrzeuge

RAINER MÜHLHOFF

Menschengestützte Künstliche Intelligenz Über die soziotechnischen Voraussetzungen von «deep learning»

DIETER MERSCH

Kreativität und Künstliche Intelligenz Einige Bemerkungen zu einer Kritik algorithmischer Rationalität

TAHANI NADIM / NELI WAGNER im Gespräch mit ANJA BRELJAK / CHRISTIAN SCHWINGHAMMER

«Influencing the Machine?»

MARTIN HENNIG / KILIAN HAUPTMANN

Alexa, optimier mich! KI-Fiktionen digitaler Assistenzsysteme in der Werbung

BILDSTRECKE

ANDY KING vorgestellt von Kathrin Peters

You Are All I See

LABORGESPRÄCH

MAX LINZ im Gespräch mit BRIGITTE WEINGART

Weitermachen Sanssouci Ein Uni-Film

EXTRA

HANNA ENGELMEIER

Halb Buch, halb QR-Code Mit Maren Kames am Lyriktelefon

GOTTFRIED SCHNÖDL

Emanation, Umkehrung, Ausstreichung (De-)Naturalisierungen in Technik- und Medientheorie

DEBATTE

Methoden der Medienwissenschaft

BIRGIT SCHNEIDER

Unstete Methoden! Für eine offene Methodenpraxis mit digitalen Medien

CLAUS PIAS

Schätzen, Rechnen und die Medien des medialen Apriori

ERHARD SCHÜTTPELZ

Methoden sind die Praktiken einer theoretischen Fragestellung

PATRICK VONDERAU

Methode als wissenschaftssoziales Problem

WERKZEUGE

THOMAS WAITZ

Nicht NichtstunÜber Prokrastination

BESPRECHUNGEN

DAWID KASPROWICZ

Die Wiederkehr der Zaubermaschinen. Drei Bücher zur viel diskutierten Disziplin des «machine learning»

MARIE-LUISE ANGERER

«Synaptic chips, non-cognizers, and wild minds». Begriffe, Modelle, Geschichten

SVEN SEIBEL

Vom «giving voice» zur «audibility». Bedingungen und Praktiken der Vernehmbarkeit

ELISA BARTH

Provozierende Fülle Eine Erinnerung an Michel Serres

AUTOR_INNEN

BILDNACHWEISE

IMPRESSUM

KÜNSTLICHE INTELLIGENZEN

What does AI see? What does AI know? – An AI Memory Game. Screenshots aus der Online-Video-Datenbank «Something Something» der Twenty Billion Neurons GmbH. Sie wird zum Training von künstlichen neuronalen Netzwerken eingesetzt. Montage: Julia Eckel, 2019

KÜNSTLICHE INTELLIGENZEN

Einleitung in den Schwerpunkt

Verfahren der Künstlichen Intelligenz (KI) greifen in immer mehr Bereiche von Kultur und Gesellschaft ein: Selbstfahrende Autos, die Vorhersage von Börsenkursen, Diagnosesysteme der Medizin, Sprachassistenten, Computerspiele, Übersetzungsdienste, neuartige Smartphonekameras, smarte und zu Rassismus neigende Bots, Überwachungstechnologien und autonome Waffensysteme sind nur einige der Beispiele, die die gegenwärtige Konjunktur von KI illustrieren. Die großen Linien der gesellschaftlichen Auseinandersetzung rund um intelligente Maschinen bewegen sich in den bekannten Bahnen zwischen (Er-)Lösungsversprechen und Untergangsprophezeiungen. Doch längst hat auch eine differenzierte Debatte begonnen, in der KI und mit ihr assoziierte Technologien als das große «sociotechnical imaginary»1 unserer Zeit in seiner Komplexität und Vielschichtigkeit fassbar wird. Ehemals eher wenig beachtete Themen wie Superintelligenz, Post- und Transhumanismus, social robots und Maschinenethik sind jedenfalls im Mainstream angekommen.2

Doch wie auch immer die derzeitige Debatte läuft: Umso mehr KI als eine Größe fassbar wird, die über Gesellschaft mitbestimmt, umso klarer ist geworden, dass die Realität dieser Technologie maßgeblich durch Medien geprägt wird. Die Forschung an und Entwicklung von KI-Verfahren setzt umfänglich technische und nicht-technische Medien voraus. Damit sind nicht nur spezifisch technische Konfigurationen und Konstellationen von Software und Hardware angesprochen oder Medien im unspezifischen Sinne soziotechnischer Mediatoren von Wissenschaft und Technologie. Vielmehr sind z.B. gerade gegenwärtige KI-Technologien im hohen Maße von unterschiedlichen Medien (Bilder, Texte, Sprachen, Töne) als Lerndaten abhängig, die zudem massenhaft vorliegen müssen, damit intelligente Systeme ihre Aufgaben überhaupt erfüllen können. Umgekehrt ist KI Objekt medialer Darstellungen, Politiken und Narrative, in denen Technologie im weitesten Sinn als gesellschaftlicher Gegenstand konkretisiert wird.3

Zwar wurden die Geschichte und die Effekte vernetzter digitaler Medien schnell als Forschungsgegenstände der Medienwissenschaft akzeptiert, das gilt aber nicht für KI, deren Beziehung und Relevanz für den Gebrauch von Medientechnologien lange ein eher randständiges Thema war.4 Vor diesem Hintergrund versammelt der vorliegende Schwerpunkt Beiträge, die sich KI in ihren unterschiedlichen Formen nähern und medienwissenschaftliche Einsätze der Analyse erproben. In dieser Einleitung möchten wir das Feld entfalten und schlagen dafür drei Dimensionen vor, die geeignet sein können, medienwissenschaftliche Sichtweisen zu charakterisieren. Erstens werden fachspezifische Diskurse und Schlaglichter der KI-Entwicklung skizziert; zweitens wird die Ideen- und Wissenschaftsgeschichte der KI thematisiert, welche auch die (inter-)disziplinären Bezüge zu Philosophie, Anthropologie und Kognitionswissenschaft sichtbar macht; und drittens schlagen wir vor, zwischen Imaginationen von KI und ihren soziotechnischen Realisierungen zu unterscheiden, um die diskursive Dynamik rund um KI-basierte Technologien fassen zu können. Damit die Ordnungen des Feldes sowie die technischen Verfahren und deren Unterschiede erschlossen werden können, folgen wir den Systematiken der KI-Entwicklung und -Forschung, ihren Diskursivierungen und Differenzierungen.

I.Fachspezifische Diskurse und Schlaglichter der KI-Entwicklung

Fragt man, was das Trennende und Gemeinsame der KI-Technologien in Bezug auf Medien und hinsichtlich der mit ihnen verbundenen Praktiken ist, unterteilen sich die KI-Verfahren in unterschiedliche Forschungsfelder bzw. Arbeitsgebiete, die ihrer Bezeichnung nach einen deutlichen Medienbezug erkennen lassen, z.B. das Feld der computer vision, bei dem es darum geht, wie Computer ihre Umwelt visuell wahrnehmen und die Informationen der Umwelt verarbeiten können. Zu denken ist auch an das natural language processing, innerhalb dessen das Ziel verfolgt wird, Maschinen auf das Verständnis von Sprachen und Texten zu trainieren.5 Der Blick in diese Bereiche zeigt exemplarisch, dass derzeit maschinelle Lernverfahren und speziell Ansätze künstlicher neuronaler Netzwerke (KNN) entscheidend für KI und ihre aktuellen Anwendungen sind. Diese Technologien stellen in der Allianz mit Medientechnologien und ihren Gebrauchspraktiken die gegenwärtig einflussreichste Form der Umsetzung von KI dar.6

Berührt ist damit eine zwar idealtypische, aber im Grundsatz tragfähige Unterscheidung – nämlich der Differenz zwischen den sogenannten subsymbolischen bzw. konnektionistischen Modellen und den ‹symbolischen› Ansätzen.7 Letztere zeichnen sich dadurch aus, dass sie versuchen, logische Schlussfolgerungsregeln als symbolische Operationen zu programmieren und auf formale Repräsentationen von Wissen anzuwenden. Die Grundidee dieses Ansatzes ist, wie Allen Newell und Herbert A. Simon schreiben, Intelligenz an die Manipulation formaler Tokens in «physikalischen Symbolsystemen» zu binden, diese Symbolsysteme als Instantiation einer universellen Maschine zu verstehen und mit den Mitteln des «Digitalcomputers» nachzubauen.8 Subsymbolische bzw. konnektionistische Ansätze hingegen basieren – in Orientierung am Leitbild der Funktionsweise biologischer Gehirne und ihrer neuronalen Strukturen – auf dem quasiinduktiven bzw. quasiphänomenologischen Erlernen von Mustern in simulierten oder empirischen Welten.9 Gegenwärtig haben subsymbolische bzw. konnektionistische Verfahren besondere Konjunktur. In Bezug auf ihre Präsenz im medialen Diskurs scheint KI fast synonym mit KNN und deep learning zu sein.

Die aktuelle Hochphase subsymbolischer KNN zeichnete sich spätestens im Jahr 2012 ab, als ein Team der University of Toronto den sogenannten ImageNet-Wettbewerb gewann und im Feld der computer vision dank sogenannter convolutional neural networks und leistungsfähiger, parallelorganisierter Hardware die Konkurrenz vorheriger bzw. anderer Ansätze weit hinter sich ließ.10 Dieser Leistungssprung war insofern überraschend, als KNN zu dieser Zeit nicht die dominante Technologie zur Entwicklung von KI war.11 Die Grundlagen der KNN wurden in den 1940er und 1950er Jahren erarbeitet, u.a. auf der Basis der Forschungsleistungen von Warren S. McCulloch, Walter Pitts, Donald O. Hebb und Frank Rosenblatt.12 Dabei ist zu bedenken, dass die von McCulloch und Pitts entworfene ‹Zelle› für «A Logical Calculus of the Ideas Immanent in Nervous Activity»13 entwickelt wurde, um zu untersuchen, ob menschliche Gehirne Turing-berechenbare Funktionen berechnen können. Doch später sollten diese ‹Zellen› als Netz für Mustererkennung eingesetzt und mit der Hebb’schen Lernregel ausgestattet werden.14

Entscheidend für die (Selbst-)Geschichtsschreibung der KI-Forschung ist dann die Dartmouth-Konferenz, zu der sich zahlreiche führende Köpfe unterschiedlicher Disziplinen im Sommer 1956 versammelten, um sich über das junge Forschungsfeld auszutauschen. Ebenso berühmt wie die Zusammenkunft der Forscher selbst war der Antrag, den die Initiatoren der Konferenz, unter anderem John McCarthy, Marvin L. Minsky, Nathaniel Rochester sowie Claude E. Shannon, mit Datum vom 31. August 1955 an die Rockefeller Foundation zur Finanzierung des Sommerprojekts richteten. Bekannt ist dieser Antrag vor allem wegen der Prägung des Begriffs der artificial intelligence. Ähnlich interessant sind aus heutiger Sicht die einzelnen Forschungsschwerpunkte, die im proposal hervorgehoben werden, darunter der Hinweis auf die Simulation der Lernfähigkeit von Maschinen sowie bereits die Herausstellung neuronaler Netze. Aus medienwissenschaftlicher Perspektive erscheint es rückblickend besonders bemerkenswert, dass als Aspekt des artificial intelligence problem explizit erwähnt wird, «how a computer can be programmed to use a language», während Herausforderungen der computer vision lediglich implizit unter dem Stichwort abstractions als Forschungsproblem eine vage Erwähnung finden.15

Von wenigen Konjunkturphasen abgesehen, so etwa in Folge der Etablierung der sogenannten backpropagation als zentralem Lernalgorithmus ab ca. Mitte der 1980er Jahre, galten KNN lange Zeit als ein nur wenig aussichtsreicher Pfad der KI-Entwicklung. Diese Einschätzung ist inzwischen durch die Vielzahl industrieller Anwendungen dieses Ansatzes eindrucksvoll widerlegt worden. Dennoch gibt es zahlreiche Wissenschaftler_innen, die auf fundamentale Beschränkungen der subsymbolischen KI aufmerksam machen und die durch sie evozierten technoutopischen Visionen kritisieren. So sind zwar subsymbolische Verfahren für die Frage, wie Computer ihre Umwelt visuell wahrnehmen und die Informationen der Umwelt verarbeiten können, sehr relevant – ähnliches gilt für das schon erwähnte natural language processing. Allerdings müssen in beiden Anwendungsfeldern Kategorisierungen vorgenommen werden, für die es semantische Konzepte braucht. Daher integrierte z.B. IBMs Watson, 2011 durch den Sieg gegen zwei menschliche Kandidaten in der Quizshow Jeopardy! bekannt geworden, neben Verfahren des maschinellen Lernens auch Wissensrepräsentationen und logische Schlussfolgerungen. Inzwischen werden Konzepte zu einem cognitive computing entwickelt, in denen verschiedene Verfahrensweisen von KI in hybriden Systeme kombiniert werden.16 Galten in den Anfangsjahren von KI das logische Schließen in Gestalt von Rechnen bzw. Mathematik sowie der Sprache bzw. des rationalen Dialogs als Vorbilder, so sind die kognitiven Architekturen heute in starkem Maße mit der Modellierung und Simulation affektiver Intelligenz befasst. Dies berührt in entscheidender Weise das Thema der Ausgestaltung der immer enger mit dem Körper verbundenen Interfaces zwischen Menschen und Maschinen.17 Spätestens seit den 2000er Jahren wird dazu geforscht, dass und wie Emotionen und Affekte schnellere Entscheidungen ermöglichen als rationales Abwägen. Insbesondere für die Robotik-Entwicklung sind diese Ansätze interessant, damit Roboter (in zukünftigen Situationen) Handlungsentscheidungen treffen können.

Derzeit wird im globalen Maßstab massiv – und historisch beispiellos – in KI-Technologien und speziell KNN investiert. Die großen Tech-Konzerne wie Alphabet, Facebook oder Microsoft sind rasch auf das neue Leistungsvermögen von KNN aufmerksam geworden und haben begonnen, KI-Unternehmen bzw. Start-ups mit entsprechender Spezialisierung aufzukaufen bzw. prominente Pionier_innen der KNN-Forschung zu verpflichten.18 Das Streben nach einer, auch im politischen Sinne, führenden Position im Bereich der KI-Entwicklung ist zu einem globalen Wettbewerb geworden. In dem 2017 veröffentlichten Next Generation Artificial Intelligence Development Plan des chinesischen Staatsrates wird KI zu einer nationalen Aufgabe erklärt: «Artifical intelligence brings new opportunities for social construction».19 Die «historical opportunity», weltweit die Führung in dieser Schlüsseltechnologie übernehmen zu können, sei jedenfalls konsequent zu nutzen.20

Auf dieser Ebene kommt es zu einer Prägung der sich entwickelnden KI-Formen durch die Medien und ihre industriellen Ökonomien.21 Dabei geht es um Grundsatzfragen der Organisation, Steuerung und Kontrolle riesiger Datenmengen unterschiedlicher Medienarten in ihren ethischen, rechtlichen oder militärischen Dimensionen. Mehr denn je verweisen ökonomische Fragen immer auch auf eine Politik der KI. Die Bandbreite ist groß: So kann man die im Kontext der jüngst qua europäischer Gesetzgebung möglich gemachten Upload-Filter für Onlineplattformen und Social-Media-Anwendungen nennen. Oder man denke an maschinelle Lernverfahren als Grundlage von Empfehlungsalgorithmen, die – wie etwa bei Netflix – Angebote personalisiert gestalten und mithin den Traum wiederbeleben, den kommerziellen Erfolg ihrer Produkte berechenbar zu machen.22 Ganz andere Ausmaße haben die bisher in ihrer Breite noch nicht wirklich absehbaren Pläne staatlicher Überwachung im Rahmen des chinesischen social credit-Systems23 – die Liste lässt sich erweitern.

Inzwischen liegt eine reiche Forschung zu den verschiedenen Technologien und Computing-Paradigmen vor, welche die Entwicklung von KI begünstigen, etwa im Kontext des Internet of Things, des Ubiquitous Computing oder von Big Data.24 Von wenigen wichtigen Ausnahmen abgesehen, sind die jüngeren Entwicklungen der KI und in Sonderheit die maschinellen Lernverfahren in den meisten Disziplinen der Geistes-, Kultur- und Sozialwissenschaften aber nur selten untersucht worden. Doch mit dem gegenwärtigen KI-Hype ändert sich die Situation. Adrian Mackenzie etwa hat in seinem Band Machine Learners das maschinelle Lernen einer machttheoretischen Analyse unterzogen, die unter anderem auf einer diagrammatischen Perspektive aufbaut.25 Vor allem aber fasst er die entsprechenden Technologien als «human-machine ensembles», die immer nur im Plural als machine learners adressiert werden können.26 Dieses Motiv klingt auch im Titel des vorliegenden Schwerpunktes an.

II.Ideen- und Wissensgeschichte der KI

Eine zweite Zugriffsmöglichkeit zur Erschließung der KI-Forschung besteht darin, die ideengeschichtlichen Pfade in Bezug auf die Differenz zwischen menschlichen und maschinellen kognitiven Leistungen zu verfolgen. Nach Niklas Luhmann hat die humanistische Tradition die «Kognition» als «eine Art Reservatbegrifflichkeit» genutzt und «mit Vorstellungen über Vernunft, Verstand und Reflexionsvermögen spezifiziert», um den Maschinen eine nur sekundäre Rolle als «Ergänzungen und Entlastungen des menschlichen Handlungsvermögens zuzuweisen». Was jetzt allerdings unter dem Schlagwort artificial intelligence verhandelt werde, so schreibt Luhmann in der Gesellschaft der Gesellschaft, laufe auf das Zerbrechen einer solchen «menschenbezogenen Kognitionstheorie» hinaus. Nötig sei daher eine Neubeschreibung der Mensch-Maschine-Differenz, die auf einer Revision anthropozentrischer Verständnisse von Kognition beruhen und diese auch als eine von Maschinen vollziehbare Leistung anerkennen müsse.27

Tatsächlich hatte die beginnende Forschung zu KI ab Mitte der 1950er Jahre im Rahmen der ‹kognitiven Wende› mit dem Schlagwort mind as a machine nicht nur die entscheidenden Impulse für die Formierung der Kognitionswissenschaft gegeben, sondern seitdem auch aus dieser zahlreiche Impulse erhalten.28 Impliziert war in der Bestimmung der kognitiven Potenziale von Maschinen stets das Problem, ob eine KI nur als spezialisierte KI (ohne Bewusstsein) oder als allgemeine KI (mit einer Form von Bewusstsein) realisierbar ist. Eine heute zwar weitestgehend historische, aber noch nachwirkende Kontroverse betraf die Beurteilung der Rolle und der Leistungen symbolischer Repräsentationen. Dabei standen sich zwei Positionen gegenüber: Die erste Perspektive basiert auf logisch-mathematischen Verfahren und Semantiken und hat als die bereits erwähnte symbolische KI z.B. bei der Entwicklung von Expertensystemen und der Mediatisierung von Entscheidungen große Bedeutung. Die zweite Sichtweise steht eher in der Tradition von Behaviorismus und Informationstheorie, wie sie in biologisch orientierten kybernetischen Konzepten diskutiert wurde:29 Nicht das bewusste rationale Handeln (des Menschen), sondern die dynamische Verkopplung von Organismus oder Maschine mit der Welt avancierte dort zum Leitbild für die Modellierung intelligenten Verhaltens; an die Stelle des Paradigmas ‹individuellen Denkens› trat ‹soziales Handeln›, an die Stelle des ‹Computers› die ‹Biologie›, an die Stelle eines ‹statischen Atomismus› ein ‹dynamischer Holismus›.30

Für die Idee von KI hatte dieser Wandel große Folgen. Hubert Dreyfus konnte dem Programm symbolischer KI Anfang der 1970er Jahre noch (erfolgreich) den Vorrang eines impliziten, praktischen Weltwissens als des für die praktische Orientierung in der Welt nötigen Kontext- und Relevanzwissens entgegengehalten und damit die Unterschiede zwischen menschlicher und maschineller Welterschließung betonen.31 Von Mitte der 1980er Jahre an wandelten sich die ‹kognitiven Architekturen› der technischen Systeme aber in einer Weise, die eine derartige humanistische Intervention zunehmend problematisch werden ließ. KI wurde nunmehr als eine ‹situierte› und ‹verkörperte› Technologie konzipiert, die auf immer engere Tuchfühlung mit einer ihr unbekannten Umwelt zu gehen vermag – eine Umwelt, die über verschiedene mediale Verfahren, wie Sensoren für Bild- oder Spracherkennung, erschlossen werden soll.32 Neu gestellt war damit nicht nur die Frage nach dem ‹Menschen› generell, sondern im Besonderen auch die nach denjenigen medialen Verfahren, die als ‹intelligent› eingestuft werden können. Dafür ist der später sogenannte Turing-Test eine herausragende historische Referenz.33

Turing schlug in seinem Text «Computing Machinery and Intelligence» einen Versuchsaufbau – ein «Imitation Game» – vor, um die Frage zu untersuchen, ob eine Maschine denken kann. Ausgangspunkt dafür war ein Geschlechter-Rate-Spiel, in dem eine Person (unklaren Geschlechts) zwei anderen Personen, von denen eine männlich und eine weiblich sei, schriftlich Fragen stellt und darauf Antworten erhält. Basierend auf dieser Kommunikation entscheidet die ratende Person, welche_r ihrer Kommunikationspartner_innen männlich oder weiblich ist. Dieses Setting wird nun dahingehend geändert, dass der männliche Antwortende durch einen Computer ersetzt wird. Die ratende Person soll nun also herausfinden, welche der Antwortenden weiblich bzw. Maschine ist.34 Die Verschiebung von der Frage: «Können Maschinen denken?», auf die Frage, ob sich die ratende Person im Maschinen-Erkennungstest genauso häufig irrt wie im Geschlechter-Erkennungstest, ging mit der Verschiebung vom Denken zur Kommunikation (und Konversation) einher und der Verschiebung des Problems (der Denkfähigkeit) von Maschinen zum (Irrtum der) Beobachter_innen. Damit traten Kommunikation und Kulturtechniken sowie deren Simulation in den Fokus.

Eine weitere wichtige Etappe derartiger Imitationsspiele war (und ist) Weizenbaums Programm ELIZA, dessen Geschichte CLEMENS APPRICH in seinem Beitrag im Kontext der computerbasierten Psychotherapie darstellt und einer psychoanalytisch grundierten Kritik unterzieht.35GABRIELE GRAMELSBERGER, MARKUS RAUTZENBERG, SERJOSCHA WIEMER und MATHIAS FUCHS weisen in ihrem Beitrag darauf hin, dass sich die Geschichte der KI entlang der Geschichte der durch die KI in Angriff genommenen Spiele erzählen lässt und dass zunehmend massenhaft verbreitete ‹sozio-intelligente Spielräume› die ideale Umgebung für eine ‹Exteriorisierung des Geistes› darstellen.

Die Komplexität dieser Szenarien steigert sich nun aber nochmals, wenn man in Rechnung stellt, dass ‹Intelligenz› immer schon als eine über menschliche und nicht-menschliche Akteure verteilte Leistung angesehen werden kann – denn dann war sie nie etwas allein auf das ‹Gehirn› oder den ‹Geist› Reduzierbares, sondern etwas schon immer auf Verhältnisse der Vermittlung Angewiesenes, also Mediales.36 Konsequenterweise hat Susan Leigh Star – im Einklang mit dem oben angesprochenen Paradigmenwechsel – die selbstverständlich vorausgesetzte individualpsychologische Grundlage des Turing-Tests angegriffen und stattdessen einen ‹Durkheim-Test› gefordert, der die Frage nach KI vielmehr in jeden kollektiven und kooperativen Arbeitsprozess einrückt, in dem ein Computer normalerweise operiert. Ein solcher ‹Durkheim-Test› wäre dann bestanden, wenn nicht Mann und/oder Frau richtig erkannt wären und auch der Unterschied Mensch/Maschine nicht stabilisiert und/oder verwischt wäre. Stattdessen entspräche

[d]er Durkheim-Test […] dem Design, der Akzeptanz, dem Gebrauch und der Modifikation eines Systems durch eine Gemeinschaft in Echtzeit. Seine Intelligenz bestünde im direkten Maß seiner Nützlichkeit bei der Anwendung auf die gemeinschaftliche Arbeit; sowie in seiner Fähigkeit, sich zu verändern und multiple Standpunkte einzubeziehen.37

Damit wird auch wieder die Frage nach der Rolle der Arbeit in den Operationen Künstlicher Intelligenzen aufgeworfen. Mit Blick auf die gegenwärtig zur Disposition stehenden Verfahren der KI geht es folglich nicht allein darum, den Black-Box-Status gegenwärtiger KNN kritisch auszuloten, sondern den Fokus auf die soziotechnischen Infrastrukturen, Institutionen und Organisationen gleichsam im Rücken der Lernalgorithmen zu richten. So können PETER KLIMCZAK, ISABEL KUSCHE, KONSTANZE TSCHÖPE und MATTHIAS WOLFF anhand des Blicks in die Technikgeschichte zeigen, dass Lösungen zur Kontrolle und Akzeptanz der KI in einen Kontext von Organisationsbildung und technischer Standardisierung eingebettet sein müssen, der die soziale Akzeptanz der neuen Technologie erhöht. Dabei geht es neben technischen Kontrollgewinnen auch um die Akzeptanz der Organisationen, die KI verwenden und kontrollieren. Ähnliches gilt für die Diskussionen um die ethischen Implikationen Künstlicher Intelligenzen, wie sie im Beitrag von TOBIAS MATZNER am Beispiel des Trolley-Problems und der damit verbundenen boundary practices zwischen Mensch und KI adressiert werden.38

III.Kulturelle Imaginationen und soziotechnische Realisierungen

Insofern Intelligenz, wie im Turing-Test impliziert, wesentlich als intelligentes Verhalten beobachtet werden kann, lässt sich KI – zumal als Hinterfragung der Mensch-Maschine-Differenz – in die Geschichte der Automaten einreihen.39 Sind diese in der Antike als selbstbewegte Maschinen eher der Auseinandersetzung um (künstliches) Leben zuzurechnen,40 legen sie mit den schreibenden, musizierenden und rechnenden Automaten des Barocks auch ein als ‹intelligent› adressierbares Verhalten an den Tag.41 Die Automatisierung von ursächlich dem Menschen zugerechneten Leistungen gehört zur Faszinationsgeschichte von KI, die seit ihren Anfängen von der Differenz zwischen kultureller Imagination und soziotechnischer Realisierung geprägt ist.

In der Geschichte der Automaten beruhte der ‹automatische Charakter› nicht selten auf verborgener menschlicher Tätigkeit, wie etwa im Falle des 1769 durch Wolfgang von Kempelen konstruierten ‹Schachtürken›.42 Auch dies findet man in manchen heutigen vorgeblichen Anwendungen von KI wieder, die in Wirklichkeit auf verdeckter menschlicher Arbeit basieren.43 Hier klafft eine große Lücke zwischen den Imaginationen des ‹Automatischen› oder eben des ‹Künstlichen› und ihrer tatsächlichen soziotechnischen Realisation. Dies unterstreicht auch der Beitrag von RAINER MÜHLHOFF, der die Einhegung menschlicher kognitiver Ressourcen in hybride Mensch-Maschine-Apparate fokussiert – denn im Zentrum jedes deep learning-basierten KI-Projektes steht heute die Beschaffung eines konstanten Stroms an Trainings- oder Verifikationsdaten, die durch menschliche Mitarbeit gewonnen werden. Insofern müssen Diskurse zur KI auch kritisch in Bezug auf die möglicherweise invisibilisierte menschliche Arbeit sein. Eine vergleichbare Klasse von Beispielen sind die Automatisierungen des Turing-Tests in Sicherheitsabfragen für Websites, die wiederum zum Training von Mustererkennung genutzt werden – der sogenannte CAPTCHA (Completely Automated Public Turing Test to Tell Computers and Humans Apart). Darauf folgten als Entwicklung ReCAPTCHA sowie aktuell NoCAPTCHA.44

Zu den aktuellen Imaginationen innerhalb der KI-Debatte gehört auch die Frage, inwieweit Maschinen als quasiautonome Entitäten zu kreativ-künstlerischen Leistungen fähig sind.45 Einen aktuellen Anknüpfungspunkt dazu stellt die medienwirksame Versteigerung eines Gemäldes namens Portrait of Edmond De Belamy bei Christie’s für 432.500US-Dollar im Jahr 2018 dar. Dieses Gemälde wurde mittels sogenannter generative adversarial networks erzeugt. Kurz gefasst treten dabei zwei konkurrierende KNN gegeneinander an: Eines erzeugt – in dem hier betrachteten Beispiel – Gemälde mit bestimmten Stilelementen, die es anhand eines Samples von Porträts gelernt hat;46 ein zweites Netzwerk entscheidet (quasi als inframaschinelle Iteration des Turing-Tests), ob die erzeugten Porträts durch einen Menschen geschaffen oder automatisiert erzeugt wurden. Als besondere Pointe war das Gemälde mit einer Gleichung ‹signiert›, die einen Teil der verwendeten Algorithmen präsentieren sollte. Mit diesem Vorgang und der recht bald hochkochenden Diskussion um die neue «AI Art»47 taucht eine ältere Diskussion um die Formalisierbarkeit von Kreativität und künstlerischer Produktion wieder auf, die in den 1960er Jahren unter dem Signum der ‹Informationsästhetik› firmierte.48 Dabei werden Fragen der Autor_innenschaft neu verhandelt, aber auch ein verblüffend konservatives Kunstkonzept ausgestellt – die skurrile ‹Signatur› der KI auf dem Portrait of Edmond De Belamy fällt hinter zahlreiche avantgardistische Strategien der Kunst des 20. und 21. Jahrhunderts zurück, die gerade konventionelle Begriffe (menschlicher) Autor_innenschaft attackiert haben (genannt seien nur Andy Warhol und in direktem Bezug zu Warhol Elaine Sturtevant). In diesem Kontext diskutiert DIETER MERSCH kritisch die Imaginationen maschineller Kreativität, denn für den Übergang von einem Regelsystem zu einem anderen gibt es, so Mersch, nicht wieder eine Regel, vielmehr muss eine solche erst erfunden werden. Zugleich gibt es aber zahlreiche Versuche im Feld der künstlerischen Praxis, sich mit verschiedenen Formen der und Umgangsweisen mit KI auseinanderzusetzen, wie es exemplarisch in dem Gespräch zwischen TAHANI NADIM und NELI WAGNER mit ANJA BRELJAK und CHRISTIAN SCHWINGHAMMER in Bezug auf sogenannte Bots besprochen wird.

Inwieweit mit Beteiligung moderner maschineller Lernverfahren produzierte Malerei, Filme oder Musik die Zuschreibung von Kreativität an verteilte Autor_innenpositionen zwischen Menschen und Maschinen verkomplizieren wird, bleibt abzuwarten. Festzuhalten ist, dass für die Unterscheidung zwischen Menschen und Maschinen nach der Beherrschung von Kulturtechniken (z.B. Malerei oder Konversation) gefragt wird und dabei immer wieder auch der soziale Kontext der Situation von Bedeutung ist, wie man am jüngeren Beispiel von Google Duplex ablesen kann, eine als Telefonassistenz eingesetzte KI.49

An allen diesen Beispielen zeigt sich: Über viele Jahrzehnte existierte in der Geschichte intelligenter Computersysteme eine verhältnismäßig große Kluft. Sie bestand zwischen KI als Idee und Gegenstand des (kulturellen) Imaginären50 und der Realität ihrer empirisch-technologischen Erforschung und Entwicklung. In den letzten zehn Jahren sind zahlreiche technische Utopien und Ideen der Vergangenheit hinsichtlich der Entwicklung intelligenter Maschinen (wenn auch oft auf verschobene Weise) Wirklichkeit geworden. Gegenwärtige ebenso wie historische Verfahren der KI sind dabei auf unterschiedliche und vielfältige Weise mit Medien(-technologien) verschränkt. Technologien der KI sind Material medienkultureller Imaginationen und Inszenierungen, wie sie etwa im vorliegenden Text dieses Themenschwerpunkts von KILIAN HAUPTMANN und MARTIN HENNIG am Beispiel der Werbung für Assistenzsysteme untersucht werden.

IV.Fazit

Technologien der KI transformieren zunehmend alle Bereiche der Medienkultur: Man kann sicher schon davon sprechen, dass sich Medienkulturen Künstlicher Intelligenz etabliert haben, da Verfahren der KI in immer stärkerem Maße die Möglichkeiten der Wissensvermittlung und Wahrnehmung von Welt umgestalten. In Bezug auf Medien und der mit ihnen verbundenen Diskurse und Praktiken ergeben sich also verschiedene Überschneidungsbereiche. Wenn KI heute und mehr denn je eine prägende Kraft zeitgenössischer Formen von Medialität geworden ist und ihre Operationen in unterschiedlicher Form Medien voraussetzen, steht die Frage im Raum, welche Formen von Medialität KI in Relation zu ihren materiellen Bedingungen und zur Kommunikation mit anderen Entitäten ausbildet.

Was sind etwa die medialen Operationen von KI in Weiterführung der klassischen Größen des Prozessierens, Speicherns und Übertragens? Was sind Realisierungen von Intelligenz und wie verschränkt sich das ‹Künstliche› dieser Intelligenz mit seinen sozialen Kontexten? Und falls zuträfe, dass Intelligenz vor allem in Repräsentationen und ‹Ergebnissen› von Operationen zu finden ist, wäre dann nicht die alte Frage neu zu stellen, ob KI Realisierungen von Intelligenz kennt, die einem am Menschen orientierten Verständnis von Intelligenz fremd bleiben?51 Wie verändern Künstliche Intelligenzen unser Verständnis davon, was Medien sind? Wenn Medien neuerlich und verschärft (eigen-)tätig werden, nicht Kanal sind, sondern Inhalte erzeugen und auch die Bedingungen ihrer eigenen Existenz (Software) schaffen, was heißt das für Medienbegriffe? Hier zeichnen sich auch medienphilosophische Perspektiven ab, insofern die an Medien wie dem Film und an Gilles Deleuze geschulte Theorie, dass Medien ihr eigenes ‹Denken› und ihre eigene ‹Theorie› hervorbringen,52 im Zusammenhang mit KI eine andere Bedeutung bekommen kann. Aber KI wird in Zukunft nicht nur Gegenstand (medien-)kulturwissenschaftlicher Forschung sein – sondern wahrscheinlich auch eines ihrer Werkzeuge. Es ist deshalb eine laufende Diskussion, ob und wie KI-getriebene Data Science als methodisches Verfahren in Forschungsgebieten der Digital Humanities integriert werden kann. Wissenschaftler_innen und Forschungsverbünde sind mit Nachdruck darum bemüht, die Möglichkeiten der KI auch in methodischer Hinsicht auszuloten, insbesondere in Bezug – ähnlich wie in der Medienindustrie – auf die Erhebung, Analyse, Auswertung und Präsentation großer Datenbestände, was wiederum kontrovers diskutiert wird.53

Die Beiträge des vorliegenden Schwerpunkts nehmen genauere Analysen in dem hier skizzierten Feld vor, verfolgen einige der Linien, geben Überblicke und werfen Fragen auf.

CHRISTOPH ERNST, IRINA KALDRACK,JENS SCHRÖTER, ANDREAS SUDMANN

1 Hier in Anlehnung an Sheila Jasanoff: Future Imperfect. Science, Technology, and the Imagination of Modernity, in: dies., Sang-Hyun Kim (Hg.): Dreamscapes of Modernity. Sociotechnical Imaginaries and the Fabrication of power, Chicago, London 2015, 1-33.

2 Vgl. den kleinen Aufsatz von Vernor Vinge, der für die neuere Debatte um intelligente Maschinen und ihren Folgen einflussreich war: ders.: The Coming Technological Singularity. How to Survive in the Post-Human Era, in: NASA. Lewis Research Center, Vision 21.Interdisciplinary Science and Engineering in the Era of Cyberspace, Cleveland 1993, 11-22, https://ntrs.nasa.gov/archive/nasa/casi.ntrs.nasa.gov/19940022855.pdf, gesehen am 26.4.2019. Vgl. auch Nick Bostrom: Superintelligenz. Szenarien einer kommenden Revolution, Berlin 2014, oder Catrin Misselhorn: Grundfragen der Maschinenethik, Stuttgart 2018. Unermüdlich ist natürlich seit vielen Jahren auch Ray Kurzweil, siehe etwa ders.: KI – Das Zeitalter der Künstlichen Intelligenz, München, Wien 1993.

3 Vgl. zuletzt etwa Ingo Irsigler, Dominik Orth: Zwischen Menschwerdung und Weltherrschaft. Künstliche Intelligenz im Film, in: Bundeszentrale für politische Bildung (Hg.): Künstliche Intelligenz, Bonn 2018 (= Aus Politik und Zeitgeschichte 68, 6ff.), 39-45.

4 An ehedem prominenter Stelle tauchte KI im medientheoretischen Diskurs punktuell dennoch auf, siehe etwa Norbert Bolz: Vorwort, in: ders., Friedrich Kittler, Georg Christoph Tholen (Hg.): Computer als Medium, München 1994, 9-16, insbesondere 11ff. Allerdings wurde das Thema von der Debatte um die entstehende Netzkultur überlagert. Sybille Krämer hat KI Anfang der 2000er Jahre demgemäß noch als ein veraltetes anthropomorphes Konzept kritisiert und einer nicht anthropozentrischen Beschreibung des Internets gegenübergestellt. Vgl. dies.: Vom Mythos ‹Künstliche Intelligenz› zum Mythos ‹Künstliche Kommunikation› oder: Ist eine nicht-anthropomorphe Beschreibung von Internet-Interaktionen möglich?, in: Stefan Münker, Alexander Roesler (Hg.): Mythos Internet, Frankfurt/M. 2001, 83-107, insbesondere 83ff.

5 Vgl. Robert Dale, Hermann Moisl, Harold Somers: Handbookof Natural Language Processing, New York 2000.

6 Zum Forschungsstand der KI in der Medienwissenschaft im Verhältnis zu anderen Disziplinen siehe die Einleitung in Christoph Engemann, Andreas Sudmann (Hg.): Machine Learning. Medien, Infrastrukturen und Technologien der Künstlichen Intelligenz, Bielefeld 2018, 9-36.

7 Zur Abgrenzung von KNN und symbolischer KI vgl. auch Andreas Sudmann: Szenarien des Postdigitalen. Deep Learning als Medien Revolution, in: Engemann u.a.: Machine Learning, 55-73.

8 «Physikalische Symbolsysteme» werden als den Gesetzen der Physik unterworfen und in technischen Systemen realisierbare Symbolsysteme angesehen, die auch ohne Menschen funktionieren. Vgl. Allen Newell, Herbert A. Simon: Computerwissenschaft als empirische Forschung: Symbole und Lösungsversuche, in: Dieter Münch (Hg.): Kognitionswissenschaft. Grundlagen, Probleme, Perspektiven, Frankfurt/M. 2000, 51-91, hier 59. Vgl. zur Geschichte der Idee symbolischer KI John Haugeland: Artificial Intelligence – The Very Idea, Cambridge, London 1985. Dort findet sich auch die viel zitierte Bezeichnung als «Good Old Fashioned Artificial Intelligence» (GOFAI). Vgl. dazu auch Margaret A. Boden: GOFAI, in: Keith Frankish, William M. Ramsey (Hg.): The Cambridge Handbook of Artificial Intelligence, Cambridge 2014, 89-107.

9 Vgl. als Übersicht zur Technologie des deep learning: Ian Goodfellow, Yoshua Bengio, Aaron Courville: Deep Learning, Cambridge, London 2016.

10 Vgl. Andreas Sudmann: Wenn die Maschinen mit der Sprache spielen, in: Frankfurter Allgemeine Zeitung, 2.11.2016, N2.

11 Bereits 2011 hatte ein Team um Jürgen Schmidhuber den ersten ‹übermenschlichen› Lernerfolg im Bereich computer vision. Vgl. Christian Honey: Die Suche nach dem Babelfisch, in: Zeit Online, dort datiert 23.9.2016, www.zeit.de/digital/internet/2016-08/kuenstliche-intelligenz-geschichte-neuronale-netze-deep-learning/, gesehen am 17.4.2019.

12 Vgl. Engemann u.a.: Machine Learning, 9-36.

13 Warren McCulloch, William Pitts: A Logical Calculus of the Ideas Immanent in Nervous Activity, in: Bulletin of Mathematical Biophysics, Nr. 5, 1943, 115-133.

14 Vgl. zur Hebb’schen Lernregel Donald Hebb: The Organization of Behavior. A Neuropsychological Theory, Manwah 2002 [1949].

15 Vgl. John McCarthy, Marvin L. Minsky, Nathaniel Rochester u.a.: A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence, dort datiert 31.8.1955, www-formal.stanford.edu/jmc/history/dartmouth.pdf, gesehen 23.5.2019.

16 Erkenntnisleitend sind dabei oft «dual process»-Theorien aus der kognitiven Psychologie, am bekanntesten aus diesem Kontext ist wohl der Bestseller Daniel Kahnemann: Schnelles Denken, langsames Denken, München 2012.

17 Vgl. Rosalind W. Picard: Affective Computing, Cambridge, London 1997, darin auch ein Kapitel zu «Affective Wearables».

18 Hinzuweisen ist auf Geoffrey Hinton, Yann LeCun oder Yoshua Bengio als Chief Scientists bzw. Berater. Den Dreien wurde jüngst der Turing Award 2018, die höchste Auszeichnung im Feld der Computer Science, verliehen. Der Wettbewerb um die Vorherrschaft der KI-Technologie wird weltweit als erbitterter Kampf um die smart thinkers geführt: Andrew Ng, eine weitere Schlüsselgestalt im Feld des machine learning und des deep learning, war von 2014 bis 2017 Chief Scientist und Leiter der AI Group von Baidu.

19 The Foundation for Law and International Affairs (Hg.): China’s New Generation of Artificial Intelligence Development Plan, dort datiert 30.7.2017, www.flia.org/notice-state-council-issuing-new-generation-artificial-intelligence-development-plan/, gesehen am 17.4.2019.

20 Ebd. Die Frage, welche Rolle Künstliche Intelligenzen für Strategien der (Welt-)Herrschaft spielen, hat auch schon die Medientheorie beschäftigt, vgl. Friedrich Kittler: Die künstliche Intelligenz des Weltkriegs. Alan Turing, in: ders., Georg Christoph Tholen (Hg.): Arsenaleder Seele. Literatur- und Medienanalyse seit 1870, München 1989, 187-202.

21 Vgl. Timo Daum: Die Künstliche Intelligenz des Kapitals, Hamburg 2019.

22 Zur Technologie des machine learning in Bezug auf Empfehlungsalgorithmen bei Netflix: Andreas Sudmann: Serielle Überbietung. Zurtelevisuellen Philosophie und Ästhetikexponierter Steigerungen, Stuttgart 2017, 81-87.

23 Vgl. Shazeda Ahmed: The Messy Truth About Social Credit, in: Logic 7, logicmag.io/07-the-messy-truth-about-social-credit/, gesehen am 22.4.2019.

24 Vgl. Ramón Reichert (Hg.): Big Data. Analysen zum digitalen Wandel von Wissen, Macht und Ökonomie, Bielefeld 2014; Florian Sprenger, Christoph Engemann (Hg.): Internet der Dinge. Über smarte Objekte, intelligente Umgebungen und die technische Durchdringung der Welt, Bielefeld 2015.

25 Vgl. Adrian MacKenzie: Machine Learners. An Archaeology of Data Practice, Cambridge, London 2017, hier insbesondere 17ff. Vgl. auch den Band von Engemann u.a.: Machine Learning.

26 MacKenzie: MachineLearners, 14.

27 Niklas Luhmann: Die Gesellschaft der Gesellschaft, Bd. 2, Frankfurt/M. 1998, 121f.

28 Vgl. Margaret Boden: Mind as a Machine. A History of Cognitive Science, Bd. 1 und 2, Oxford, New York 2006.

29 Vgl. Rodney A. Brooks: Intelligence without Representation, in: Artificial Intelligence 47, 1991, 139-159.

30 Vgl. die entsprechende Gegenüberstellung in Konstantine Arkoudas, Selmer Bringsjord: Philosophical Foundations, in: Keith Frankish, William M. Ramsey (Hg.): The Cambridge Handbook of Artificial Intelligence, Cambridge 2014, 34-63, hier 55f.

31 Vgl. Hubert Dreyfus: WhatComputers Can’t Do. A Critique ofArtificial Reason, New York 1972.

32 Für eine Aktualisierung der Perspektive von Dreyfus vgl. John Haugeland: Mind Embodied and Embedded, in: ders.: Having Thought. Essays in the Metaphysics of Mind, Cambridge 1998 [1995], 207-237.

33 Vgl. Alan M. Turing: Rechenmaschinen und Intelligenz, in: Bernhard Dotzler, Friedrich Kittler (Hg.): Intelligence Service, Berlin 1987, 147-182. Englisches Original: Alan M. Turing: Computing Machinery and Intelligence, in: ders., Jack Copeland (Hg.): The Essential Turing:Seminal Writings in Computing, Logic,Philosophy, Artificial Intelligence, andArtificial Life: Plus The Secrets of Enigma, Oxford, New York 2004, 433-464.

34 Zuletzt hat Ulrike Bergermann das Gendering der Grundlegung im Turing-Test beleuchtet und nachgezeichnet, wie Geschlechterrollen in Werbung, Interfaces und im kulturell Imaginären reaktualisiert, verschoben und gleichermaßen bekräftigt werden. Vgl. Ulrike Bergermann: Biodrag. Turingtest, KI-Kino und Testosteron, in: Engemann u.a.: Machine Learning, 339-364; außerdem Bettina Heintz: Die Herrschaft der Regel. Zur Grundlagengeschichte des Computers, Frankfurt/M., New York 1993; N. Katherine Hayles: How We Became Posthuman, Chicago, London 1999.

35 Vgl. auch Marianna Baranovska, Stefan Höltgen (Hg.): Hello I’m Eliza. Fünfzig Jahre Gespräche mit Computern, Bochum, Freiburg 2018.

36 Zur verteilten Kognition, wenn auch ohne expliziten Bezug auf KI, vgl. Ed Hutchins: Cognition in the Wild, Cambridge, London 1995.

37 Susan Leigh Star: Die Struktur schlecht strukturierter Lösungen. Grenzobjekte und heterogenes verteiltes Problemlösen, in: dies., Sebastian Gießmann, Nadine Taha (Hg.): Grenzobjekte und Medienforschung, Bielefeld 2017, 130-150, hier 135. Vgl. Sebastian Gießmann: Von der verteilten Künstlichen Intelligenz zur Diagrammatik der Grenzobjekte, in: ebd., 151-166. Beide Texte beziehen sich auf «Verteilte Künstliche Intelligenz», vgl. dazu Nikos Vlassis: A Concise Introduction to Multiagent Systems and Distributed ArtificialIntelligence, San Rafael 2007.

38 Vgl. überdies zur aktuellen Problematik autonomer Waffensysteme Lucy Suchman, Jutta Weber: Human-Machine Autonomies, in: Nehal Buta, Susanne Beck, Robin Geiß u.a. (Hg.): AutonomousWeapon Systems. Law, Ethics, Policy, Cambridge 2016, 75-102.

39 Vgl. Ralf Bülow: Der künstlicheMensch, das unbekannte Wesen. Kleine Geschichte der Automaten,Androiden, Golems, Roboter, Homunculi und Cyborgs, Wetzlar 2016 (= Schriftenreihe und Materialien der phantastischen Bibliothek Wetzlar, Kleine Reihe, Bd. 5); Bernhard Dotzler, Peter Gendolla, Jörgen Schäfer (Hg.): MaschinenMenschen. Eine Bibliographie, Frankfurt/M. u.a. 1992; Wolf-Andreas Liebert (Hg.): Künstliche Menschen. Transgressionen zwischen Körper, Kultur und Technik, Würzburg 2014.

40 Siehe zu dem anders gelagerten Diskurs des artificial life Hans-Joachim Metzger: Genesis in Silico. Zur digitalen Biosynthese, in: Martin Warnke, Wolfgang Coy, Georg Christoph Tholen (Hg.): HyperKult. Geschichte, Theorie und Kontext digitaler Medien, Basel 1997, 461-510. Siehe auch Mark A. Bedau: Artificial Life, in: Keith Frankish, William M. Ramsey (Hg.): The Cambridge Handbook of Artificial Intelligence, Cambridge 2014, 296-315.

41 Systemtheoretisch orientierte Autor_innen, denen theoretisch die Annahme naheliegt, Kommunikation sei der primäre soziale Sachverhalt, bevorzugen den Begriff der «künstlichen Kommunikation», vgl. Elena Esposito: Artificial Communication? The Production of Contingency by Algorithms, in: Zeitschrift für Soziologie, Nr. 46, H. 4, 2017, 249-265.

42 Vgl. Jiri Veselý: Die berühmteste Erfindung Wolfgang von Kempelens, in: Blätter für Technikgeschichte, Nr. 36/37, 1974/1975, 25-46.

43 Vgl. Lilly Irani: The Cultural Work of Microwork, in: NewMedia & Society, Vol.17, Nr. 5, 720-739 2015 [2013].

44 Vgl. exemplarisch Mayumi Takaya, Yusuke Tsuruta, Akihiro Yamamura: Reverse Turing Test Using Touchscreens and CAPTCHA, in: Journal of Wireless Mobile Networks, Ubiquitous Computing, andDependable Applications, Vol.4, Nr. 3, 2013, 41-57.

45 Die Diskussion um Zug 37 im Spiel von AlphaGo gegen Lee Sedol vom 10.3.2016 war auch ein Beispiel für diese Frage: Der Zug überraschte alle Kommentatoren und Go-Kenner und war am Ende erfolgreich – war er also nicht ein gutes Beispiel für die Kreativität der Künstlichen Intelligenz?

46 Siehe die Website des Künstlerkollektivs obvious: www.obvious-art.com/, gesehen am 22.4.2019, und insbesondere das YouTube-Video von Boma en Français: Pierre FAUTREL – À la découverte d’une IA artiste, dort datiert 11.9.2018, youtu.be/xWS__kIJ7ws, gesehen am 22.4.2019.

47 Siehe Ian Bogost: The Al-Art Gold Rush Is Here. An Artificial Intelligence ‹Artist› Got a Solo Show at a Chelsea Gallery. Will it Reinvent Art or Destroy It?, in: The Atlantic, dort datiert 6.3.2019, www.theatlantic.com/technology/archive/2019/03/ai-created-art-invades-chelsea-gallery-scene/584134/, gesehen am 22.4.2019.

48 Vgl. Claudia Giannetti: Kybernetische Ästhetik und Kommunikation, in: Medien Kunst Netz, dort datiert 2004, www.medienkunstnetz.de/themen/aesthetik_des_digitalen/kybernetische_aesthetik/1/, gesehen am 22.4.2019.

49 Vgl. Daniel Herbig: Google Duplex: Guten Tag, Sie sprechen mit einer KI, in: Heise online, dort datiert 11.5.2018, www.heise.de/newsticker/meldung/Google-Duplex-Guten-Tag-Sie-sprechen-mit-einer-KI-4046987.html, gesehen am 22.4.2019.

50 Vgl. u.a. Simone Natale, Andrea Ballatore: Imagining the Thinking Machine: Technological Myths and the Rise of Artificial Intelligence, in: Convergence: The International Journal of Research into New Media Technologies, Juni 2017, doi.org/10.1177/1354856517715164; Paul E. Ceruzzi: Manned Space Flight and Artificial Intelligence: ‹Natural› Trajectories of Technology, in: David L. Ferro, Eric G. Swedin (Hg.): Science Fiction and Computing. Essays on Interlinked Domains, Jefferson, London 2011, 95-116.

51 Diese Frage wird bereits bei Krämer mit Verweis auf die Diskussion von Fremdheit bei Bernhard Waldenfels erwähnt, vgl. dies.: Vom Mythos ‹Künstliche Intelligenz›, 86.

52 Vgl. Lorenz Engell: Medientheorie der Medien selbst, in: Jens Schröter (Hg.): Handbuch Medienwissenschaft, Stuttgart 2014, 207-213. Siehe dazu das aktuelle Forschungsprojekt von Matteo Pasquinelli u.a. «Künstliche Intelligenz und Medienphilosophie», kim.hfg-karlsruhe.de/, gesehen am 22.4.2019.

53 Vgl. zu machine learning in den Digital Humanities einführend Christof Schöch: Quantitative Analyse, in: Fotis Jannidis, Hubertus Kohle, Malte Rehbein (Hg.): Digital Humanities. Eine Einführung, Stuttgart 2017, 279-298.

CLEMENS APPRICH

DIE MASCHINE AUF DER COUCH

Oder: Was ist schon ‹künstlich› an Künstlicher Intelligenz?

Es gibt keine künstliche Intelligenz. Freilich, es gibt ein künstliches Hüftgelenk, weil Säugetiere über ein natürliches Pendant verfügen und es somit ersetzt werden kann.1 Aber was sollte analog dazu künstliche Intelligenz ersetzen? Eine natürliche Intelligenz? Stephen Jay Gould hat in seinem Buch Der falsch vermessene Mensch die wissenschaftlichen Schwächen, aber auch politischen Gefahren in der Suche nach einer biologisch fundierten Intelligenz aufgezeigt.2 Seine historische Studie zeichnet nach, wie Schädel- und Körpervermessung, aber auch der nach wie vor omnipräsente IQ-Test das Phantasma eines auf Biologismus beruhenden Positivismus bedienen. Somit ist auch die Ausrichtung Künstlicher Intelligenz an der Geschichte der Gehirnforschung, wie sie nicht zuletzt in aktuellen medienwissenschaftlichen Debatten erfolgt, zutiefst problematisch.3 Der in der Neurowissenschaft verankerte Konnektionismus, also die Annahme, dass sich Intelligenz auf ihre hirnphysiologische Verdrahtung reduzieren ließe, erfreut sich mit der Wiederentdeckung künstlicher neuronaler Netzwerke großer Beliebtheit. In ihrem Kern geht diese Vorstellung auf die Frühkybernetik, insbesondere die Arbeit von Warren McCulloch und Walter Pitts, zurück.4 Zentral für deren Modell ist das Alles-oder-nichts-Prinzip, wonach Neuronen entweder feuern oder nicht feuern, und so im Sinne einer diskreten Aussagelogik (wahr/falsch) repräsentiert und mithilfe elektronischer Halbleiter (an/aus) operationalisiert werden können. Kombiniert zu einem nervous net sind künstliche Neuronen dem Modell nach in der Lage, jede Funktion einer Turingmaschine, das heißt die schrittweise Berechnung von Zeichenketten nach bestimmten Regeln, durchzuführen.5 Im Folgenden werde ich den Spuren einer solchen kybernetischen Bestimmung von Intelligenz nachspüren und zwei Fallstudien aus dem Bereich der computerbasierten Psychotherapie (ELIZA und PARRY) gegenüberstellen. Im Zentrum steht dabei die Frage, inwieweit das mechanistische Weltbild des Konnektionismus zu einer biologistisch verkürzten Vorstellung von Intelligenz führt und wie diese Vorstellung durch eine psychoanalytische Kritik aufgebrochen werden kann.

I.Das Problem mit der Intelligenz

Wie Orit Halpern in Beautiful Data zeigt, handelt es sich bei dem Neuronenmodell von McCulloch und Pitts um den Versuch, eine Rationalität zu entwerfen, die nicht mehr auf den alten Prinzipien von Vernunft und Verstand basiert.6 McCulloch selbst machte diesen Punkt auf einem kognitionswissenschaftlichen Symposium des California Institute of Technology deutlich, als er die modernen Rechner in Anschluss an Turing als ‹psychotisch› bezeichnete.7 Für den entschiedenen Gegner psychoanalytischer Ansätze war dies insofern von Relevanz, als damit eine mechanistische Vorstellung von Intelligenz transportiert wurde, die letztlich die Hoffnung enthielt, direkt in die Schaltkreise des Hirns eingreifen zu können.8 Abseits irgendwelcher talking cures sollten Neuronen als hirnphysiologische Basiseinheit in Form von elektronischen Logikgattern nachmodelliert werden, um so ‹Denken› als materiell lösbares Problem der Elektrotechnik zu definieren.9 «Treating the brain as a Turing machine»10 umgeht somit die alten psychologischen Fragen nach Bewusstsein und Verstand, indem nicht mehr danach gefragt wird, was Intelligenz ist, sondern wie sie funktioniert.11 Aus dieser kybernetischen Sicht ergeben sich allerdings zwei wesentliche Herausforderungen für das McCulloch-Pitts-Modell:

The first concerns facilitation and extinction, in which antecedent activity temporarily alters responsiveness to subsequent stimulation of one and the same part of the net. The second concerns learning, in which activities concurrent at some previous time have altered the net permanently, so that a stimulus which would previously have been inadequate is now adequate.12

Das Problem vorangegangener, nicht erinnerter Aktivität, die das Netz in seinem gegenwärtigen Tun heimsucht, verweist nicht zuletzt auf das Problem des Unbewussten; insofern es auch nicht weiter verwundern mag, wenn ein dezidiert antipsychoanalytisches Programm, wie es neuronale Netze nach McCulloch und Pitts darstellen, mit unbewussten symbolischen Prozessen seine lieben Mühen hat.13 Das Problem des Lernens, das hier im Zentrum stehen soll, betrifft das Problem der maschinellen Intelligenz bzw. die Frage, inwieweit Maschinen durch schrittweises Lernen so etwas wie menschliche Intelligenz nachahmen können.

Bereits 1950 stellte Alan Turing die Frage, ob Maschinen mithilfe geeigneter Erziehungsmaßnahmen (auch Programmierung genannt) zum Denken gebracht werden können.14 Zu diesem Zwecke ersetzte er die für ihn unpräzise Frage: «Can machines think?» durch ein Gedankenexperiment:

The new form of the problem can be described in terms of a game which we call the ‹imitation game›. It is played with three people, a man (A), a woman (B), and an interrogator (C) who may be of either sex. The interrogator stays in a room apart from the other two. The object of the game for the interrogator is to determine which of the other two is the man and which is the woman.15

Zwei Punkte sind hier von Interesse: zum einen der Umstand, dass es in diesem, auch Turing-Test genannten Spiel eben nicht darum geht, den_die Fragesteller_in hinters Licht zu führen; so ist sich C über den Aufbau des Tests während des gesamten Spiels bewusst, auch wenn und gerade weil A und B in ihren schriftlichen Antworten lügen dürfen; zum anderen das oft übersehene, aber zentrale Detail, dass Turing das Problem der Intelligenzbestimmung mit dem der Geschlechteridentität einleitet. Er legt nahe, dass A über sein Geschlecht lügen soll, um so den_die Fragesteller_in dazu zu bringen, ihn für B zu halten, während B dem_der Fragesteller_in helfen soll, indem sie möglichst wahrheitsgetreue Antworten gibt.16 Von der allzu rigiden Geschlechterbinarität einmal abgesehen, klingt in der queeren Versuchsanordnung die eingangs gestellte Frage nach der vermeintlichen ‹Natürlichkeit› menschlicher Intelligenz wider‚ zumal in Turings Beispiel der Computer die Rolle von A übernimmt:

We now ask the question, ‹What will happen when a machine takes the part of A in this game?› Will the interrogator decide wrongly as often when the game is played like this as he does when the game is played between a man and a woman? These questions replace our original, ‹Can machines think?›.17

Wie Ulrike Bergermann anführt, geht es Turing nicht darum, die Frage nach dem ontologischen Status Künstlicher Intelligenz zu klären, sondern letztlich darum, die Frage selbst zu denaturalisieren.18 Wenn Biologie bei der Bestimmung von Intelligenz nicht mehr als Marker dienen soll, bleibt eben nur noch die mittels Fernschreiber ermöglichte Konversation zwischen Mensch und Maschine, um eine Aussage darüber treffen zu können, ob die Maschine nun intelligentes Verhalten zeigt oder nicht.19

II.Die sprechende Maschine

Turings Hoffnung, dass Maschinen in absehbarer Zeit eine Konversation auf Englisch halten können, erfüllte sich früher als von ihm erwartet.20 Das erste überzeugende Gesprächsprogramm war das von Joseph Weizenbaum am MIT zwischen 1964 und 1966 entwickelte Sprachanalysesystem ELIZA.21 Die Inspiration für das Parsing-Programm kam von George Bernard Shaws Komödie Pygmalion, in welcher der Sprachwissenschafter Henry Higgins die arme und durchwegs naiv dargestellte Blumenverkäuferin Eliza Doolittle zu einer Herzogin macht, indem er ihr Englisch im Akzent der Londoner Oberschicht beibringt.22 Weizenbaum sponn den altgriechischen (und teils misogynen) Stoff weiter: Die Kunstfigur Eliza wird bei ihm zum Sprachprogramm ELIZA, das selbst keine ‹Intelligenz› aufweist, sondern lediglich nach keywords im Eingabetext sucht. Um diese zu interpretieren und eine Konversation zu führen, bedarf es eines Skripts, das im Fall von ELIZA einem Rogerianischen Psychotherapeuten nachempfunden war. DOCTOR, wie das Skript hieß, bot sich als Gesprächspartner allein schon deshalb an, weil Carl Rogers Ansatz einer humanistischen Psychologie dem damaligen Klischee einer bloßen talking cure entsprach: «The Rogerian psychotherapist is relatively easy to imitate because much of his technique consists of drawing his patient out by reflecting the patient’s statements back to him».23 In der personenzentrierten Gesprächstherapie wird kein Wissen über den_die Patient_in bzw. die Welt, in der er_sie lebt, vorausgesetzt, zumal davon ausgegangen wird, dass alles zur Heilung Notwendige bereits in ihm_ihr vorhanden ist. Bei der technischen Umsetzung des Parsing-Systems hat dies den Vorteil, dass das Programm keine explizite Information speichern muss. Um so etwas wie Verständnis zu simulieren, muss es lediglich die Aussage des_der Patient_in als Frage reformulieren. Dieser als ‹Eliza-Trick› bekannte Mechanismus, der in der Folge bei einer Vielzahl von Chat-Bots zum Einsatz kam, stieß immer wieder auf Kritik – nicht zuletzt bei Weizenbaum selbst, der in einer kritischen Reflexion auf seine Schöpfung betonte, dass es sich bei ELIZA (bzw. dem Skript DOCTOR) eben nicht um ein intelligentes System handelte, sondern um eine Versuchsanordnung, welche die Grenzen des Computers beim Verstehen natürlicher Sprache aufzeigen sollte.24

Der aufklärerische Ansatz des Experiments schien aber nicht zu fruchten, wie Weizenbaum anhand einer oft wiederholten Geschichte verdeutlichte. So soll ihn seine Sekretärin, der er bei der Arbeit in jovialer Manier über die Schulter blickte, gebeten haben, den Raum zu verlassen, damit sie sich in Ruhe mit DOCTOR unterhalten könne. In seinem Buch Computer Power and Human Reason kommentiert der Computerwissenschaftler die Szene mit deutlicher Verwunderung, war sich die Sekretärin – ganz im Sinne des Turing-Tests – doch der Tatsache bewusst, dass es sich lediglich um ein Programm und nicht um einen echten Therapeuten handelte. Obwohl er aus Erfahrung wusste, dass Menschen eine emotionale Beziehung zu Maschinen entwickeln können und diesen nicht selten menschliche Eigenschaften zuschreiben, war Weizenbaum sichtlich erstaunt über die Tatsache, dass jemand den Computer als eine Person wahrnahm, mit der man sich unterhalten könnte: «What I had not realized is that extremely short exposure to a relatively simple computer program could induce powerful delusional thinking in quite normal people».25 Dieser als ‹Schock› bezeichnete Moment wurde für ihn nur noch darin übertroffen, dass selbst ernstzunehmende Psychiater_innen ELIZA für psychotherapeutische Zwecke einsetzen wollten.26 Weizenbaums Kritik richtete sich explizit an Kenneth M. Colby, einen Psychiater, der Kliniken und Zentren mit computerbasierten Therapien versorgen wollte, um so hunderte von Patient_innen in kürzester Zeit behandeln zu können.27 Die automatisierte Therapie wird laut Colby möglich, weil der menschliche Therapeut – gleich dem Computer – als «information-processor and decision maker»28 betrachtet werden kann, der im Verlauf des Gesprächs ein kognitives Modell des_der Patienten_in lernt und anhand des jeweiligen Inputs seinen Output in natürlicher Sprache anpasst. Aufgrund der – zumindest hypothetisch vorhandenen – Lernfähigkeit des Systems wird der enge Rahmen von ELIZA als einem bloßen Sprachanalyseprogramm verlassen und durch die Simulation eines echten, weil kontextabhängigen Gesprächs erweitert.29

III.Das schizoide Programm

Glaubt man den Ausführungen von Sherry Turkle, war Kenneth Colby an der ursprünglichen Entwicklung von Weizenbaums ELIZA mitbeteiligt,30 was die spätere Rivalität der beiden Männer erklären könnte. Während Weizenbaum die Grenzen der Computerwissenschaft in Bezug auf das Verständnis natürlicher Sprache aufzeigen wollte, war Colby vom therapeutischen Nutzen eines objektiven, kostengünstigen und immer verfügbaren Computerprogramms überzeugt. Für ihn konnte eine computerbasierte Psychotherapie dabei helfen, aus der Psychiatrie eine präzise Wissenschaft zu machen.31 Einige Jahre nach ELIZA schrieb Colby gemeinsam mit einer Gruppe von Informatiker_innen am Stanford Artificial Intelligence Laboratory das Computerprogramm PARRY, das den Dialog zwischen einem Therapeuten und einem paranoiden Schizophrenen (namens Parry) simulierte.32 Im Gegensatz zu ELIZA bzw. DOCTOR übernahm das Computerprogramm nicht die Rolle des Therapeuten, sondern die des Patienten, was eine andere Gesprächsstrategie erforderlich machte. ELIZA konnte den Input als reformulierte Frage zurückspielen, während PARRY ein Verständnis der Gesprächssituation aufbringen musste: «[T]o understand what information is contained in linguistic expressions, knowledge of syntax and semantics must be combined with beliefs from a conceptual structure capable of making inferences».33 Anstatt eines rein syntaktischen Parsers, der Probleme damit hat, die Konversation weiterzuführen, sobald ein bestimmtes Wort in der Datenbank fehlt, ging es Colby und seinem Team um die Implementierung von symbolverarbeitenden Regeln, die selbstständig darüber entscheiden, was im Gespräch wichtig und was unwichtig ist. Hierzu wird ein Muster im Sinne eines ‹Glaubenssystems› programmiert, das im Fall von PARRY dem bei Paranoia auftretenden – und laut Colby klinisch nachgewiesenen – Charakterzug eines Verfolgungswahns entspricht. Der simulierte Patient, ein 28 Jahre alter männlicher Protestant mit Spielproblemen, glaubt, dass ihm die Wettmafia auf den Fersen ist. Im Gespräch sucht er deshalb nach expliziten und impliziten Hinweisen für eine mögliche böswillige Absicht seines Gegenübers. Im Gegensatz zu ‹normalem› Kommunikationsverhalten ist die Input-Output-Strategie eines solch «paranoid information-processing system» vor allem von Misstrauen, Angst und Feindseligkeit geprägt, was zu einer konsequenten, weil wahnhaften (Fehl-)Interpretation des Gesprächs führt.34

PARRY, der u.a. dazu entwickelt wurde, angehende Psychiater_innen in ihrem Umgang mit paranoid-schizophrenen Patient_innen auszubilden, löste eine lebhafte Debatte über die Möglichkeit maschineller Intelligenz aus.35 Trotz einiger Berichte, wonach PARRY den Turing-Test bestanden hätte,36 blieben erhebliche Zweifel an der Generalisierbarkeit des schizoiden Programms. So schrieb Colby selbst von einem «one-track mind» seines Patienten, das den Vorteil habe, immer wieder zu seinem Wahnkomplex zurückkehren und so den Verlauf des Gesprächs steuern zu können.37 Colbys Absicht in der Programmierung von PARRY war daher weniger, ein möglichst überzeugendes (das heißt generalisierbares) Exemplar Künstlicher Intelligenz zu entwickeln, als vielmehr ein empirisch überprüfbares Modell der Paranoia vorzustellen: «I shall propose a postulated structure of symbol-manipulating processes, strategies, functions, or procedures that is capable of producing the observable regularities of the paranoid mode».38 Hierzu ging er von einer spezifischen Form der Symbolverarbeitung aus, in der das paranoide Verhalten durch eine «underlying organized structure of rules» erzeugt wird, und nicht etwa durch physiologische Ausfälle im Gehirn.39 Dies ist ein entscheidender Punkt, da die der Paranoia zugrundeliegende Struktur somit einem Algorithmus gleicht, der – ganz im Sinne der Computerwissenschaft – die Art und Weise, wie Symbole verarbeitet werden, organisiert und somit kontrolliert.40