11,99 €

Mehr erfahren.

- Herausgeber: FISCHER E-Books

- Kategorie: Bildung

- Sprache: Deutsch

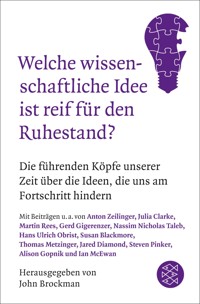

Großreinemachen in der Wissenschaft: Die klügsten Köpfe der Welt zeigen, welche Ideen und Theorien sie für entbehrlich, überkommen oder schlicht für falsch halten. In der Welt der Wissenschaft werden Ideen und Theorien laufend überprüft, verfeinert und angepasst. Und doch gibt es eine Reihe von Vorstellungen, die heute nicht mehr aktuell sind – und sich trotzdem hartnäckig in den Köpfen der Menschen halten. Der bekannte Visionär John Brockman hat daher die führenden Wissenschaftler unserer Zeit gefragt, welche Idee sie am liebsten aufs Altenteil schicken würden. Mit Beiträgen u.a. von Jared Diamond, Richard Dawkins, Alison Gopnik, Hans Ulrich Obrist, Helen Fisher, Stephen Pinker, Sherry Turkle, Andrian Kreye, Laura Betzig, Nicholas A. Christakis, Steward Brand, Anton Zeilinger und Ian McEwan. Sie legen damit ein breites Mosaik aus veralteten Konzepten vor, die uns klarmachen, wie sehr sich die Welt der Wissenschaft ständig in Veränderung befindet.

Das E-Book können Sie in Legimi-Apps oder einer beliebigen App lesen, die das folgende Format unterstützen:

Seitenzahl: 676

Veröffentlichungsjahr: 2016

Ähnliche

John Brockman

Welche wissenschaftliche Idee ist reif für den Ruhestand?

Die führenden Köpfe unserer Zeit über die Ideen, die uns am Fortschritt hindern

Über dieses Buch

In der Welt der Wissenschaft werden Ideen und Theorien laufend überprüft, verfeinert und angepasst. Und doch gibt es eine Reihe von Vorstellungen, die heute nicht mehr aktuell oder schlicht falsch sind – und sich hartnäckig in den Köpfen der Menschen halten.

John Brockman hat daher die führenden Wissenschaftler unserer Zeit gefragt, welche Ideen sie am liebsten aufs Altenteil schicken würden; mit Beiträgen u.a. von Jared Diamond, Richard Dawkins, Alison Gopnik, Hans Ulrich Obrist, Helen Fisher, Stephen Pinker, Sherry Turkle, Andrian Kreye, Laura Betzig, Nicholas A. Christakis, Stewart Brand, Anton Zeilinger und Ian McEwan.

Weitere Informationen finden Sie auf www.fischerverlage.de

Biografie

Der bekannte Visionär John Brockman, ehemaliger Aktionskünstler, Herausgeber der Internetzeitschrift »Edge« und Begründer der »Dritten Kultur« (»Third Culture«), leitet eine Literaturagentur in New York und hat bereits zahlreiche Bücher veröffentlicht, u.a. ›Das Wissen von morgen. Was wir für wahr halten, aber nicht beweisen können: Die führenden Wissenschaftler unserer Zeit beschreiben ihre großen Ideen‹, ›Leben, was ist das? Ursprünge, Phänomene und die Zukunft unserer Wirklichkeit‹, ›Welche Idee wird alles verändern? Die führenden Wissenschaftler unserer Zeit über Entdeckungen, die unsere Zukunft bestimmen werden‹ und ›Wie funktioniert die Welt? Die führenden Wissenschaftler unserer Zeit stellen die brillantesten Theorien vor‹.

Weitere Informationen, auch zu E-Book-Ausgaben, finden Sie bei www.fischerverlage.de

Impressum

Erschienen bei FISCHER E-Books

Die amerikanische Originalausgabe erschien 2015 unter dem Titel

»This Idea Must Die. Scientific Theories That Are Blocking Progress«

im Verlag HarperCollins Publishers, New York

© 2015 by Edge Foundation, Inc.

Für die deutsche Ausgabe:

© 2016 S. Fischer Verlag GmbH, Hedderichstr. 114, D-60596 Frankfurt am Main

Covergestaltung: Hauptmann & Kompanie Werbeagentur, Zürich

Coverabbildung: Shutterstock

Abhängig vom eingesetzten Lesegerät kann es zu unterschiedlichen Darstellungen des vom Verlag freigegebenen Textes kommen.

Dieses E-Book ist urheberrechtlich geschützt.

ISBN 978-3-10-403684-7

Dieses E-Book ist urheberrechtlich geschützt.

Die Nutzung unserer Werke für Text- und Data-Mining im Sinne von § 44b UrhG behalten wir uns explizit vor.

Hinweise des Verlags

Abhängig vom eingesetzten Lesegerät kann es zu unterschiedlichen Darstellungen des vom Verlag freigegebenen Textes kommen.

Im Text enthaltene externe Links begründen keine inhaltliche Verantwortung des Verlages, sondern sind allein von dem jeweiligen Dienstanbieter zu verantworten. Der Verlag hat die verlinkten externen Seiten zum Zeitpunkt der Buchveröffentlichung sorgfältig überprüft, mögliche Rechtsverstöße waren zum Zeitpunkt der Verlinkung nicht erkennbar. Auf spätere Veränderungen besteht keinerlei Einfluss. Eine Haftung des Verlags ist daher ausgeschlossen.

Dieses E-Book enthält möglicherweise Abbildungen. Der Verlag kann die korrekte Darstellung auf den unterschiedlichen E-Book-Readern nicht gewährleisten.

Wir empfehlen Ihnen, bei Bedarf das Format Ihres E-Book-Readers von Hoch- auf Querformat zu ändern. So werden insbesondere Abbildungen im Querformat optimal dargestellt.

Anleitungen finden sich i.d.R. auf den Hilfeseiten der Anbieter.

Für Richard Dawkins, Daniel C. Dennett, Jared Diamond und Steven Pinker

Pioniere der Dritten Kultur

Mein Dank geht an Laurie Santos für den Vorschlag der diesjährigen Edge-Frage und an Paul Bloom und Jonathan Haidt für ihre Verfeinerungen. Wie immer danke ich Stewart Brand, Kevin Kelly, George Dyson und Steven Pinker für ihre ständige Unterstützung. Ich möchte auch Peter Hubbard von HarperCollins für seine Ermutigung danken. Außerdem stehe ich in der Schuld meines Agenten, Max Brockman, der das Potential für dieses Buch erkannte, und wie immer von Sara Lippincott für ihre umsichtige und sorgfältige Redaktionsarbeit.

John Brockman Verleger & Herausgeber, Edge

Vorwort

Die Edge-Frage

Die Wissenschaft schreitet durch die Entdeckung neuer Dinge und die Entwicklung neuer Ideen voran. Nur wenige wirklich neue Ideen werden jedoch entwickelt, ohne dass man zuerst ältere aufgibt. Wie der theoretische Physiker Max Planck (1858–1947) bemerkte: »Eine neue wissenschaftliche Wahrheit pflegt sich nicht in der Weise durchzusetzen, dass ihre Gegner überzeugt werden und sich als belehrt erklären, sondern vielmehr dadurch, dass ihre Gegner allmählich aussterben und dass die heranwachsende Generation von vornherein mit der Wahrheit vertraut gemacht ist.« Mit anderen Worten, die Wissenschaft schreitet durch eine Reihe von Begräbnissen voran. Warum so lange warten?

WELCHE WISSENSCHAFTLICHE IDEE IST REIF FÜR DEN RUHESTAND?

Ideen ändern sich, und die Zeiten, in denen wir leben, ändern sich. Die vielleicht größte Änderung heutzutage ist die Veränderungsrate. Welche etablierte wissenschaftliche Idee ist reif dafür, beiseitegeschoben zu werden, damit die Wissenschaft voranschreiten kann?

Geoffrey West

Die Theorie von Allem

Theoretischer Physiker; Distinguished Professor und ehemaliger Präsident, Santa Fe Institute

Von Allem? Nun, Moment mal. Eine Theorie von Allem in Frage zu stellen könnte als etwas Überflüssiges erscheinen, da ich gewiss nicht der erste bin, der an der impliziten Übertreibung dieses Begriffs Anstoß nimmt. Aber wenn wir ehrlich sind, dann hat die Bezeichnung des eigenen Forschungsgebiets als »Theorie von Allem« einen Beigeschmack von Arroganz und Naivität. Obwohl dieser Ausdruck (wenn auch sicherlich nicht das Bestreben) erst seit verhältnismäßig kurzer Zeit in Umlauf ist und vielleicht schon bald eines natürlichen Todes stirbt, sollte er aus der ernsthaften Wissenschaftsliteratur in den Ruhestand versetzt werden.

Lassen Sie mich das näher erläutern. Die Suche nach großen Synthesen, nach Gemeinsamkeiten, Regelmäßigkeiten, Ideen und Begriffen, die über die engen Grenzen spezifischer Probleme oder Disziplinen hinausgehen, ist eine der großen inspirierenden Triebfedern der Wissenschaft und der Wissenschaftler. Sie ist wohl auch ein bestimmendes Merkmal von Homo sapiens sapiens. Vielleicht ist die binomische Form von sapiens eine verzerrte poetische Anerkennung dieser Tatsache. Ebenso wie die Erfindung von Göttern und Gott bezeichnet der Begriff einer Theorie von Allem die großartigste Vision überhaupt, die Inspiration aller Inspirationen, nämlich dass wir die Gesamtheit des Universums in einer kleinen Menge von Regeln einfangen und verstehen können – in diesem Fall einer bündigen Menge mathematischer Gleichungen. Wie der Begriff Gottes ist das jedoch möglicherweise irreführend und in intellektueller Hinsicht gefährlich.

Zu den klassischen großen Synthesen der Naturwissenschaft gehören Newtons Gesetze, die uns lehrten, dass die Gesetze des Himmels sich von denen der Erde nicht unterscheiden; Maxwells Vereinheitlichung der Elektrizität und des Magnetismus, die den flüchtigen Äther in unser Leben einführte; Darwins Theorie der natürlichen Selektion, die uns daran erinnerte, dass wir letztendlich nur Tiere und Pflanzen sind; und die Gesetze der Thermodynamik, die nahelegen, dass wir nicht ewig existieren werden. Jede dieser Synthesen hatte tiefgreifende Folgen – nicht nur durch die Veränderung unserer Vorstellung der Welt, sondern auch durch die Bereitstellung der Grundlagen für technische Fortschritte, die zu dem Lebensstandard geführt haben, den viele von uns privilegierterweise genießen. Dennoch sind sie alle in unterschiedlichem Maße unvollständig. Tatsächlich haben das Verständnis der Grenzen ihrer Anwendbarkeit und der Grenzen ihrer Vorhersagekraft sowie die laufende Suche nach Ausnahmen, Verletzungen und Fehlschlägen noch tiefere Fragen und Herausforderungen aufgeworfen, wodurch der kontinuierliche Fortschritt der Wissenschaft und die Entwicklung neuer Ideen, Techniken und Begriffe angeregt wurden.

Eine der großen wissenschaftlichen Herausforderungen ist die Suche nach einer großen vereinheitlichten Theorie der Elementarteilchen und ihrer Wechselwirkungen, einschließlich der Erweiterung dieser Theorie auf das Verständnis des Kosmos und sogar auf den Ursprung der Raumzeit selbst. Eine solche Theorie würde auf einer sparsamen Menge zugrundeliegender mathematisierbarer universeller Prinzipien beruhen, die alle grundlegenden Kräfte der Natur zusammenschließen und erklären, von der Gravitation und dem Elektromagnetismus bis zur schwachen und starken Kernkraft, wobei Newtons Gesetze, die Quantenmechanik und die allgemeine Relativitätstheorie darin enthalten wären. Grundlegende Größen wie die Lichtgeschwindigkeit, die Dimensionalität der Raumzeit und die Massen der Elementarteilchen würden alle vorhergesagt werden, und die Gleichungen, die den Ursprung und die Evolution des Universums bis zur Bildung von Galaxien und darüber hinaus regieren, würden abgeleitet werden – und so weiter. Darin besteht die Theorie von Allem. Es handelt sich um eine bemerkenswerte und äußerst ehrgeizige Bestrebung, die Tausende von Forschern über fünfzig Jahre lang mit einem Aufwand von Milliarden Dollar beschäftigt hat. Wenn man an diese Bestrebung, die immer noch weit von ihrem Endziel entfernt ist, nahezu jeden beliebigen Maßstab anlegt, ist sie äußerst erfolgreich gewesen und hat beispielsweise zur Entdeckung der Quarks und des Higgs-Bosons geführt, zu schwarzen Löchern und zum Urknall, zur Quantenchromodynamik und Stringtheorie … und zu vielen Nobelpreisen.

Aber »von Allem«? Nun, wohl kaum. Wo ist das Leben, wo sind Tiere und Zellen, Gehirne und Bewusstsein, Städte und Firmen, Liebe und Hass, usw., usw.? Wie entsteht die außergewöhnliche Mannigfaltigkeit und Komplexität, die wir hier auf der Erde sehen? Die grob vereinfachende Antwort darauf ist, dass diese Phänomene unvermeidliche Ergebnisse der Wechselwirkungen und der Dynamik sind, die die Theorie beinhaltet. Die Zeit entwickelt sich aus der Geometrie und Dynamik von Strings, das Universum expandiert und kühlt sich ab, und die Hierarchie – von Quarks zu Nukleonen, zu Atomen und Molekülen, zu Zellen, Gehirnen und Gefühlen und allem Übrigen – bricht daraus hervor, eine Art von Deus ex machina, ein Ergebnis davon, dass »einfach nur« an der Kurbel zunehmend komplizierter Gleichungen und Berechnungen gedreht wurde, von denen man annimmt, dass sie im Prinzip zu jedem beliebigen hinreichenden Genauigkeitsgrad gelöst werden können. In qualitativer Hinsicht mag diese extreme Version des Reduktionismus eine gewisse Gültigkeit haben, aber etwas fehlt hier.

Dieses »Etwas« beinhaltet Begriffe wie Information, Emergenz, Zufälle, historische Kontingenz, Anpassung und Selektion – alles Merkmale komplexer adaptiver Systeme, ob es sich um Organismen, Gesellschaften, Ökosysteme oder Wirtschaften handelt. Diese Dinge bestehen aus unzähligen einzelnen Bestandteilen oder Wirkkräften, die kollektive Eigenschaften annehmen, welche im Allgemeinen anhand ihrer zugrundeliegenden Bestandteile nicht vorhersagbar sind (jedenfalls nicht im Detail), auch wenn man die Dynamik der Wechselwirkungen kennt. Im Unterschied zum Newton’schen Paradigma, auf dem die Theorie von Allem beruht, kann die vollständige Dynamik und Struktur komplexer adaptiver Systeme nicht in einer kleinen Anzahl von Gleichungen enkodiert werden. Ja, in den meisten Fällen wahrscheinlich nicht einmal in einer unendlichen Anzahl! Darüber hinaus sind Vorhersagen mit einem beliebigen Genauigkeitsgrad unmöglich, auch im Prinzip.

Vielleicht ist dann die überraschendste Konsequenz einer visionären Theorie von Allem ihre Implikation, dass das Universum – einschließlich seiner Ursprünge und Evolution – im großen Maßstab nicht komplex, sondern tatsächlich überraschend einfach ist, auch wenn es äußerst verwickelt ist, da es in einer begrenzten Anzahl von Gleichungen enkodiert werden kann. Möglicherweise in nur einer einzigen. Das steht in deutlichem Gegensatz zu dem, was uns hier auf der Erde begegnet, wo wir wesentlich zu einigen der vielfältigsten, komplexesten und chaotischsten Phänomene gehören, die im Universum insgesamt auftreten und die zusätzliche, möglicherweise nicht mathematisierbare Begriffe zu ihrem Verständnis erfordern. Obwohl wir der Suche nach einer großen vereinheitlichten Theorie aller Grundkräfte der Natur Beifall spenden und sie bewundern, sollten wir die Implikation aufgeben, dass sie im Prinzip alles erklären und vorhersagen kann. Stattdessen sollten wir uns auf eine parallele Suche nach einer Großen Vereinheitlichten Theorie der Komplexität begeben. Die Herausforderung, einen quantitativen, analytischen, prinzipienbasierten und prädiktiven Rahmen für das Verständnis komplexer adaptiver Systeme zu entwickeln, ist sicherlich eine große Herausforderung für das 21. Jahrhundert. Wie alle großen Synthesen wird sie zwangsläufig unvollständig bleiben, aber trotzdem wird sie zweifellos bedeutende, möglicherweise revolutionäre neue Ideen, Begriffe und Techniken anregen.

Marcelo Gleiser

Vereinheitlichung

Theoretischer Physiker am Dartmouth College; Autor von The Island of Knowledge: The Limits of Science and the Search for Meaning

So! Ich hab’s gesagt! Die ehrwürdige Vorstellung der Vereinheitlichung muss verschwinden. Ich meine nicht die kleineren Vereinheitlichungen, nach denen wir Wissenschaftler die ganze Zeit suchen und die so wenig Prinzipien wie möglich mit so vielen Naturphänomenen wie möglich verknüpfen. Diese Art wissenschaftlicher Sparsamkeit ist ein bedeutendes Fundament unserer Arbeit: Wir forschen und wir vereinfachen. Im Lauf der Jahrhunderte haben Wissenschaftler, die diesem Motto folgten, Wunder gewirkt. Newtons Gesetz der universellen Gravitation, die Gesetze der Thermodynamik, des Elektromagnetismus, das universelle Verhalten bei Phasenübergängen …

Die Probleme beginnen, wenn wir diese Idee zu weit treiben und nach der Über-Vereinheitlichung suchen, der Theorie von Allem, die erzreduktionistische Vorstellung, dass alle Naturkräfte bloß Manifestationen einer einzigen Kraft sind. Das ist die Idee, die verschwinden muss. Und ich sage das schweren Herzens; meine frühen beruflichen Bestrebungen und prägenden Jahre waren sehr stark von dem Impuls angetrieben, alles zu vereinheitlichen.

Die Idee der Vereinheitlichung ist ziemlich alt, so alt wie die abendländische Philosophie. Thales, der erste vorsokratische Philosoph, postulierte, dass »alles Wasser ist« und träumte so von einem einzigen materiellen Prinzip, um die gesamte Natur zu beschreiben. Platon schlug trügerische geometrische Formen als die archetypischen Strukturen hinter allem Wirklichen vor. Die Mathematik wurde mit Schönheit gleichgesetzt, und Schönheit mit Wahrheit. Von da aus bestand die höchste der nachplatonischen Bestrebungen darin, eine rein mathematische Erklärung für alles Existierende zu konstruieren: die alles umfassende kosmische Blaupause, das Meisterwerk einer höchsten Intelligenz. Natürlich ging es bei dem Ganzen immer um unsere eigene Intelligenz, auch wenn man sich dabei häufig auf die nebulöse Metapher des »Geistes Gottes« bezog. Wir erklären die Welt so, wie wir sie uns vorstellen. Wir können nicht aus unserem Geist heraustreten.

Der Impuls, alles zu vereinheitlichen, ist tief in den Seelen der Mathematiker und theoretischen Physiker verwurzelt, vom Langlands-Programm bis zur Superstringtheorie. Aber da liegt der Haken: Reine Mathematik ist keine Physik. Die Leistungsfähigkeit der Mathematik stammt gerade von ihrer Abgelöstheit von der physikalischen Wirklichkeit. Eine Mathematikerin kann jedes beliebige Universum schaffen, das sie will und alle möglichen Spiele damit spielen. Ein Physiker kann das nicht; seine Aufgabe besteht darin, die Natur so zu beschreiben, wie wir sie wahrnehmen. Trotzdem ist das Vereinheitlichungsspiel ein wesentlicher Bestandteil der Physik seit Galilei gewesen und hat das hervorgebracht, was es sollte, nämlich annähernde Vereinheitlichungen.

Ja, sogar die heiligsten unserer Vereinheitlichungen sind nur Annäherungen. Betrachten wir beispielsweise den Elektromagnetismus. Die Gleichungen, die die Elektrizität und den Magnetismus beschrieben, sind nur bei Abwesenheit jeglicher Ladungs- oder Magnetismusquellen vollkommen symmetrisch – d.h. im leeren Raum. Oder nehmen wir das berühmte (und schöne) Standardmodell der Elementarteilchenphysik, das auf der »Vereinheitlichung« des Elektromagnetismus und der schwachen Kernkraft beruht. Auch hier haben wir keine wirkliche Vereinheitlichung, da die Theorie überall zwei Kräfte beibehält (technischer ausgedrückt, gibt es zwei Kopplungskonstanten und zwei Eichgruppen). Eine wirkliche Vereinheitlichung, wie beispielsweise die vermutete große Vereinheitlichung zwischen der starken, der schwachen und der elektromagnetischen Kraft, die vor vierzig Jahren vorgeschlagen wurde, bleibt unerfüllt.

Was ist hier los? Warum beharren so viele darauf, in der Natur das Eine zu finden, obwohl die Natur uns ständig sagt, dass es bei ihr in Wirklichkeit um das Viele geht?

Zum einen ist der wissenschaftliche Impuls zur Vereinheitlichung kryptoreligiös. Der Westen hat Tausende von Jahren im Monotheismus gebadet, und selbst in polytheistischen Kulturen gibt es immer einen verantwortlichen Alpha-Gott (Zeus, Ra, Parabrahman). Zum anderen gibt es etwas zutiefst Anziehendes an der Gleichsetzung der ganzen Natur mit einem einzigen schöpferischen Prinzip: Die Entzifferung des »Geistes Gottes« bedeutet, etwas Besonderes zu sein, einer höheren Bestimmung zu entsprechen. Reine Mathematiker, die an die Wirklichkeit mathematischer Wahrheiten glauben, sind Mönche eines Geheimordens, der nur den Eingeweihten offen steht. Im Falle der Hochenergiephysik beruhen alle Vereinheitlichungstheorien auf einer hochentwickelten Mathematik, die sich auf reine geometrische Strukturen bezieht: Die Überzeugung ist, dass der letztendliche Code der Natur in der ätherischen Welt mathematischer Wahrheiten existiert und dass wir ihn entziffern können.

Experimentelle Daten aus der jüngeren Vergangenheit hatten eine verheerende Wirkung auf diese Überzeugung – keine Spur von supersymmetrischen Teilchen, von zusätzlichen Dimensionen oder von dunkler Materie irgendeiner Art, alles seit langem erwartete Signaturen einer Vereinheitlichungsphysik. Vielleicht wird noch etwas ans Tageslicht kommen; um es zu finden, müssen wir danach suchen. Das Problem mit der Vereinheitlichung in der Hochenergiephysik besteht darin, dass man sie immer über den Bereich experimentell zugänglicher Daten hinausschieben kann. »Der Large Hadron Collider erreichte 7 TeV und hat nichts gefunden? Kein Problem! Wer hat gesagt, dass die Natur sich für die einfachsten Varianten der Vereinheitlichung entscheiden sollte? Vielleicht geschieht alles bei viel höheren Energien, die weit jenseits unserer Reichweite liegen.«

An dieser Art von Haltung ist nichts auszusetzen. Man kann daran glauben, bis man stirbt, und man kann glücklich sterben. Oder man kann schließen, dass das, was wir am besten können, die Konstruktion von Näherungsmodellen mit Bezug darauf ist, wie die Natur funktioniert, und dass die Symmetrien, die wir entdecken, nur Beschreibungen dessen sind, was wirklich geschieht. Vollkommenheit ist eine zu schwere Last, um sie der Natur aufzubürden.

Diese Art von Argument wird häufig als defätistisch betrachtet, als von jemandem stammend, der frustriert wurde und aufgegeben hat. (Wie in »Er hat seinen Glauben verloren.«) Das ist ein großer Fehler. Die Suche nach Einfachheit ist wesentlich für die Arbeit von Wissenschaftlern. Meine eigene Arbeit besteht darin. In der Natur gibt es wesentliche organisierende Prinzipien, und die Gesetze, die wir entdecken, sind ausgezeichnete Beschreibungen dieser Prinzipien. Aber es gibt viele Gesetze, und nicht nur eines. Wir sind erfolgreiche, nach Mustern suchende, rationale Säugetiere. Allein schon das ist ein Grund zum Feiern. Wir sollten jedoch unsere Beschreibungen und Modelle nicht mit der Wirklichkeit verwechseln. In unserem geistigen Auge können wir die Vollkommenheit als eine Art ätherischer Muse bewahren. Unterdessen geht die Natur da draußen ihre eigenen Wege. Die Tatsache, dass wir es schaffen, einen Blick auf ihre innere Funktionsweise zu erhaschen, ist tatsächlich wunderbar. Und das sollte gut genug sein.

A.C. Grayling

Einfachheit

Philosoph; Gründer und Leiter des New College of the Humanities, London; außerordentliches Mitglied des St. Anne’s College, Oxford; Autor von The Good Argument: The Case Against Religion and for Humanism

Wenn zwei Hypothesen gleich gut zu den Daten passen und dieselbe Vorhersagekraft besitzen, können außertheoretische Kriterien für die Entscheidung zwischen ihnen ins Spiel kommen. Diese beinhalten nicht nur Fragen mit Bezug darauf, welche am besten zu anderen Hypothesen oder Theorien passt, die bereits erforscht wurden, sondern auch mit Bezug auf die ästhetischen Qualitäten der konkurrierenden Hypothesen selbst – welche ist ansprechender, eleganter, schöner? –, und natürlich die Frage, welche einfacher ist.

Einfachheit ist ein Desiderat in der Naturwissenschaft, und das Streben danach ist eine Triebfeder bei der Aufgabe, komplexe Phänomene auf ihre Bestandteile zurückzuführen. Sie liegt hinter der Annahme, dass es eine einzige Kraft in der Natur geben muss, von der die Gravitationskraft, die elektroschwache und die starke Kernkraft nur Erscheinungsweisen sind; und diese Annahme ist wiederum ein Vertreter der allgemeinen Ansicht, dass es letztendlich eine einzige Art von Ding (oder Materie oder Feld oder noch unbekanntem Phänomen) geben könnte, aus dem die Vielfalt durch Prinzipien hervorgeht, die selbst fundamental und einfach sind.

So bestechend die Idee der Einfachheit auch ist, gibt es doch keine Garantie dafür, dass die Natur selbst ein ebenso großes Interesse an der Einfachheit hat wie jene, die sie zu beschreiben versuchen. Wenn die Vorstellung emergenter Eigenschaften immer noch einen Wert hat, können biologische Entitäten nicht völlig erklärt werden außer durch sie, d.h. in ihrer vollen Komplexität, auch wenn Erwägungen mit Bezug auf Struktur und Zusammensetzung unverzichtbar sind.

Zwei Maße für Komplexität sind die Länge der Botschaft, die zur Beschreibung eines bestimmten Phänomens erforderlich ist, und die Länge der Evolutionsgeschichte dieses Phänomens. In gewisser Hinsicht wird dadurch ein Gemälde von Jackson Pollock nach dem ersten Maß komplex, und nach dem zweiten einfach, während ein glatter Kieselstein an einem Strand nach dem ersten Maß einfach und nach dem zweiten komplex ist. Die Einfachheit, die man in der Naturwissenschaft anstrebt, könnte man sich als das vorstellen, was durch die Reduktion der Länge der deskriptiven Botschaft erreicht wird – etwa das Einfangen in einer Gleichung. Aber könnte es eine umgekehrte Beziehung zwischen dem Grad der erreichten Einfachheit und dem Grad der resultierenden Annäherung geben?

Natürlich wäre es schön, wenn sich am Ende alles als einfach herausstellen würde oder einer einfachen Beschreibung zugeführt werden könnte. Aber manche Dinge könnten besser oder angemessener in ihrer Komplexität erklärt werden – wieder denken wir an biologische Systeme. Widerstand gegen eine zu verschwenderische Form des Reduktionismus könnte jene albernen Arten der Kritik abhalten, die behaupten, dass die Naturwissenschaft darauf abzielt, in der Perle nichts als die Krankheit der Auster zu sehen.

Scott Atran

IQ

Antropologe am Centre National de la Recherche Scientifique in Paris; Autor von Talking to the Enemy: Religion, Brotherhood, and the (Un)Making of Terrorists

Es gibt keinen Grund zu glauben und viele Gründe nicht zu glauben, dass das Maß des sogenannten Intelligenzquotienten auf irgendeine Weise eine grundlegende kognitive Fähigkeit oder »natürliche Art« des menschlichen Geistes widerspiegelt. Das bereichsübergreifende Maß des IQ wird nicht durch irgendeine jüngste Entdeckung der Kognitions- oder Entwicklungspsychologie motiviert. Es verwischt im Grunde bereichsspezifische Fähigkeiten – ausgeprägte geistige Fähigkeiten beispielsweise für geometrisches und räumliches Denken über Formen und Lagen, mechanisches Denken über Masse und Bewegung, taxonomisches Denken über biologische Arten, soziales Denken über die Überzeugungen und Wünsche anderer Menschen usw. –, die die einzige Art kognitiver Fähigkeiten sind, für die eine evolutionäre Erklärung im Sinne der natürlichen Selektion für aufgabenspezifische Kompetenzen plausibel zu sein scheint.

Nirgendwo im Tier- oder Pflanzenreich scheint es je eine natürliche Selektion für eine aufgabenübergreifende Anpassung gegeben zu haben. Ein Gesamtmaß für Intelligenz oder geistige Kompetenz gleicht einem Gesamtmaß für »den Körper«, wobei die verschiedenen und besonderen Körperorgane und Funktionen, wie Herz, Lunge, Magen, Blutkreislauf, Atmung, Verdauung usw. nicht besonders berücksichtigt werden. Ein Arzt oder Biologe, dem man ein einziges Maß für den »Körperquotienten« (KQ) vorlegen würde, wäre nicht in der Lage, diesem viel Sinn abzugewinnen.

Der IQ ist ein allgemeines Maß für gesellschaftlich akzeptable Fertigkeiten der Kategorisierung und des Denkens. IQ-Tests wurden in der Blütezeit des Behaviorismus entworfen, als nur ein geringes Interesse an der kognitiven Struktur bestand. Das Punktesystem wurde so entwickelt, dass es eine Normalverteilung von Punkten ergab mit einem Mittelwert von 100 und einer Standardabweichung von 15.

In anderen Gesellschaften könnte eine Normalverteilung eines bestimmten allgemeinen Maßes für soziale Intelligenz ganz anders aussehen; einige »normale« Mitglieder unserer Gesellschaft könnten durchaus eine Punktzahl erreichen, die eine Standardabweichung von den »normalen« Mitgliedern einer anderen Gesellschaft im Sinne des Tests dieser anderen Gesellschaft entfernt ist. In Einfachwahlaufgaben [mit nur einer richtigen Antwort] neigen ostasiatische Studenten (Chinesen, Koreaner, Japaner) dazu, eine feldabhängige gegenüber einer objektzentrierten Wahrnehmung zu bevorzugen, thematisches Denken gegenüber taxonomischem Denken und an Beispielen orientierte Kategorisierung gegenüber einer an Regeln orientierten Kategorisierung. Amerikanische Studenten bevorzugen in der Regel das Gegenteil. Bei Tests, die diese verschiedenen Kategorisierungs- und Denkkompetenzen messen, erreichen die Ostasiaten höhere Durchschnittswerte bei ihren eigenen Präferenzen und die Amerikaner erreichen höhere Werte bei ihren. An diesen verschiedenen Verteilungen ist nichts besonders aufschlussreich, außer dass sie zugrundeliegende soziokulturelle Unterschiede widerspiegeln.

Es gibt eine lange Geschichte erbitterter Auseinandersetzungen darüber, welche Aspekte des IQ erblich sind. Die überzeugendsten Untersuchungen betreffen Zwillinge, die getrennt aufgezogen wurden, und Adoptionen. Zwillingsuntersuchungen verfügen selten über große Stichprobenumfänge; darüber hinaus geht es bei ihnen häufig um Zwillinge, die bei der Geburt getrennt wurden, weil ein Elternteil stirbt oder es sich nicht leisten kann, beide zu unterstützen, und einer der Zwillinge dann zur Erziehung durch Verwandte, Freunde oder Nachbarn übergeben wird. Dadurch wird es unmöglich, die Effekte der sozialen Umgebung und Erziehung beim Hervorbringen einer Konvergenz zwischen den Zwillingen auszuschließen. Das Hauptproblem mit Adoptionsuntersuchungen besteht darin, dass die bloße Tatsache der Adoption den IQ auf zuverlässige Weise erhöht, unabhängig von jeder Korrelation zwischen den IQs der Kinder und denen ihrer biologischen Eltern. Niemand hat auch nur die geringste kausale Erklärung dafür, wie oder warum Gene, einzeln oder in Kombination, den IQ beeinflussen könnten. Ich glaube nicht, dass das daran liegt, dass das Problem zu schwierig ist, sondern daran, dass der IQ etwas fadenscheiniges und nichts natürliches ist.

Leo M. Chalupa

Die Plastizität des Gehirns

Vizepräsident für Forschung an der George Washington University

Die Plastizität des Gehirns bezieht sich auf die Fähigkeit von Nervenzellen, ihre strukturellen und funktionellen Eigenschaften mit der Erfahrung zu ändern. Das scheint kaum überraschend zu sein, da jeder Teil des Körpers sich mit dem Alter verändert. Das Besondere an der Plastizität des Gehirns (aber nicht ausschließlich auf dieses Organ beschränkt) ist, dass die Veränderungen durch Ereignisse vermittelt werden, die in einem gewissen Sinne adaptiv sind. Das Gebiet der Plastizität des Gehirns leitet sich in erster Linie aus den richtungsweisenden Untersuchungen von Torsten Wiesel und David Hubel ab, die gezeigt haben, dass die Deprivation eines Auges von normalem visuellen Input während der frühen Entwicklung zu einem Verlust funktioneller Verbindungen dieses Auges mit dem visuellen Kortex führte, während die Verbindungen des Auges, dem kein visueller Input vorenthalten wurde, expandierten.

Diese Untersuchungen zeigten auf überzeugende Weise, dass frühe Verbindungen im Gehirn nicht fest verdrahtet sind, sondern durch frühe Erfahrung modifiziert werden können; daher sind sie plastisch. Für diese Arbeit und verwandte Untersuchungen, die sie in den 1960er Jahren durchgeführt hatten, erhielten Hubel und Wiesel 1981 den Nobelpreis für Physiologie oder Medizin. Seit jener Zeit hat es Tausende von Untersuchungen gegeben, die ein breites Spektrum neuronaler Veränderungen in so gut wie jeder Region des Gehirns nachgewiesen haben, welche von der molekularen bis zur Systemebene reichen und junge, erwachsene und ältere Versuchspersonen umfassen. Infolgedessen hat sich gegen Ende des 20. Jahrhunderts unsere Vorstellung des Gehirns von etwas Festverdrahtetem zum anscheinend immer Veränderbaren gewandelt. Heute ist »Plastizität« eines der gebräuchlichsten Wörter in der neurowissenschaftlichen Literatur. Tatsächlich habe ich diesen Begriff oftmals in meinen eigenen Forschungsartikeln und im Titel einiger meiner herausgegebenen Bücher verwendet. Daher werden Sie wohl fragen, was damit nicht stimmt.

Zum einen hat die weitverbreitete Anwendung von »Plastizität des Gehirns« auf nahezu jede Art der Veränderung neuronaler Struktur und Funktion den Begriff weitgehend sinnlos gemacht. Wenn fast jede Veränderung an Neuronen als Plastizität bezeichnet wird, umfasst der Begriff so viel, dass er keine brauchbare Information mehr vermittelt. Außerdem nehmen viele Untersuchungen die Plastizität des Gehirns als zugrundeliegende Ursache für ein verändertes Verhalten in Anspruch, ohne irgendwelche direkten Belege für neuronale Veränderungen zu haben. Besonders ungeheuerlich sind Untersuchungen, die eine Verbesserung der Leistung bei einer bestimmten Aufgabe aufgrund von Übung nachweisen. Die Tatsache, dass Übung die Leistung verbessert, wurde bereits bemerkt, bevor man überhaupt irgendetwas über das Gehirn wusste. Ist es wirklich eine zusätzliche Information, wenn man sagt, dass Verbesserungen der Funktion einen bemerkenswerten Grad an Gehirnplastizität demonstrieren? Das Wort »bemerkenswert« wird häufig verwendet, um Übungseffekte bei älteren Personen zu bezeichnen, als ob diejenigen, die alt genug sind, um Sozialhilfe zu erhalten, nicht in der Lage wären, eine verbesserte Leistung durch Übung zu erzielen.

Untersuchungen dieser Art haben zur Gründung der Gehirntrainingsindustrie geführt. Viele dieser Programme konzentrieren sich auf die Jüngsten. Besonders beliebt in den letzten Jahren war der »Mozarteffekt«, der Eltern ohne jedes Interesse an klassischer Musik dazu brachte, ihren Kindern ständig Stücke von Mozart vorzuspielen. Diese Bewegung scheint nachgelassen zu haben und wurde durch eine Vielzahl von Spielen ersetzt, die angeblich das Gehirn von Kindern aller Altersstufen verbessern soll. Aber das größte Wachstum in der Industrie der Gehirnplastizität hat sich auf das alternde Gehirn konzentriert. Vor dem Hintergrund der Sorgen, die die meisten von uns mit Bezug auf Gedächtnisverlust und schwindende kognitive Fähigkeiten im Alter haben, ist das verständlich. Große Profite können gemacht werden, wie man an der Anzahl der Unternehmen ablesen kann, die in den letzten Jahren auf diesem Sektor aus dem Boden geschossen sind.

Natürlich ist nichts Schlimmes dabei, wenn man Kinder oder ältere Menschen an Tätigkeiten teilnehmen lässt, die ihre kognitiven Funktionen herausfordern. Tatsächlich könnte es dabei auch einen echten Nutzen geben. Sicherlich ist die Teilnahme an einem solchen Training dem täglichen stundenlangen Fernsehen vorzuziehen. Außerdem ist es so, dass jegliche Leistungsveränderungen irgendwelche zugrundeliegenden Veränderungen des Gehirns widerspiegeln. Wie könnte es auch anders sein, da das Gehirn alles Verhalten steuert? Aber bislang wissen wir noch nicht, was im Gehirn geschieht, wenn sich die Leistung bei einem bestimmten Videospiel verbessert, und wir verstehen auch nicht, wie solche Veränderungen dauerhaft gemacht werden könnten und auf unterschiedliche kognitive Zustände verallgemeinerbar sind. Die Bezeichnung solcher Bemühungen als »Gehirntraining« oder »gesteigerte Gehirnplastizität« ist häufig einfach Reklameschwindel, mit dem ein Produkt verkauft werden soll. Das bedeutet nicht, dass man die sogenannten Gehirnübungen aufgeben sollte; sie schaden wahrscheinlich nicht und können sogar positive Effekte haben. Aber bitte lassen Sie es, sich auf die Plastizität des Gehirns, ob sie nun bemerkenswert ist oder nicht, zu berufen, um die resultierenden Verbesserungen zu erklären.

Howard Gardner

Die Veränderung des Gehirns

Hobbs-Professor für Kognition und Bildung an der Harvard Graduate School of Education; Autor von Truth, Beauty, and Goodness Reframed

Wenn ich zu Studenten oder einem Laienpublikum über irgendeine Art digitaler Innovation spreche, lautet die Rückmeldung meiner Hörer in etwa: »Verändern Smartphones das Gehirn?«, oder: »Wir können unsere Kinder nicht mit iPads spielen lassen, weil das ihr Gehirn verändern könnte.« Ich versuche dann zu erklären, dass alles, was wir tun, das Nervensystem beeinflusst und dass ihre Kommentare deshalb entweder sinnlos sind oder weiterer Erläuterung bedürfen.

Folgendes ist eine solche Erläuterung: »Hat diese Erfahrung einen bedeutenden und vielleicht sogar dauerhaften Einfluss auf das Nervensystem?« Eine andere: »Meinen Sie ›Einfluss auf den Geist‹ oder ›Einfluss auf das Gehirn‹?«

Wenn der Fragesteller verblüfft ist, habe ich das Gefühl, dass er oder sie einen Auffrischungskurs in Philosophie, Psychologie und Neurowissenschaften braucht.

Victoria Wyatt

»Der Raketenforscher«

Außerordentliche Professorin für indigene Kunst Nordamerikas an der University of Victoria

Es ist an der Zeit, den klischeehaft berühmten »Raketenforscher« – »Man braucht kein Raketenforscher zu sein, um …« – in den Ruhestand zu schicken.

»Der Raketenforscher« ist eine Persönlichkeit und kein Prinzip, und eine fiktive Persönlichkeit obendrein. Er (oder sie) wurde durch den Alltagssprachgebrauch erschaffen, und nicht von Wissenschaftlern. Doch das Klischee schreibt überholte öffentliche Wahrnehmungen wissenschaftlicher Prinzipien fort, und das ist entscheidend. »Der Raketenforscher« braucht eine gute Ruhestandsparty.

Ich werde mit einem Dementi beginnen. Mein Traum von dieser Ruhestandsgala könnte durch Berufsneid gefärbt sein. Ich habe nie jemanden sagen hören: »Man braucht kein Ethnohistoriker zu sein, um …« Das werde ich auch niemals hören. Also zugegeben, das Klischee ignoriert die Geisteswissenschaften, aber darum geht es mir nicht. Vielmehr ignoriert »der Raketenforscher«, so wie er landläufig verstanden wird, die Naturwissenschaften auf gefährliche Weise. Das kann sich unsere Erde nicht leisten.

»Der Raketenforscher« steht außerhalb der Gesellschaft, bewegungslos auf einer höheren Ebene. Das Klischee, das weit gehegt und häufig wiederholt wird, spiegelt die Bereitwilligkeit der Öffentlichkeit wider, die Naturwissenschaft von der persönlichen Erfahrung zu trennen. Das Klischee setzt eine Trennlinie (der Genialität) zwischen dem Naturwissenschaftler und allen anderen. Das wird zwar von populären Filmen und Fernsehshows ausgebeutet, aber es ist heimtückisch. Künstlich geschaffene Trennlinien isolieren. Sie konzentrieren die Aufmerksamkeit auf Unterschiede und Unterscheidungen. Im Gegensatz dazu nährt die Erforschung von Beziehungen und Prozessen rasche wissenschaftliche Entwicklungen – Systembiologie, Epigenetik, Neurologie und Hirnforschung, Astronomie, Medizin, Quantenphysik. Komplexe Beziehungen formen auch die drängenden Herausforderungen, denen wir gegenüberstehen: globale Epidemien, Klimawandel, Aussterben von Arten, endliche Ressourcen – all diese Dinge beinhalten wesentlich wechselseitige Verknüpfungen.

Die Annäherung an solche Probleme erfordert einen Sinn für Vielfältigkeit, Komplexität, Beziehungen und Prozesse. Das landläufige Verständnis der zeitgenössischen Naturwissenschaft erfordert dasselbe. Wir können dringliche globale Probleme nur dann in Angriff nehmen, wenn die Entscheidungsträger ein klares Verständnis der Naturwissenschaft haben – wenn sie Vielfältigkeit, Komplexität, Beziehungen und Prozesse als wesentlich für das Verstehen auffassen, anstatt als Hindernisse dafür.

Gegenwärtig durchdringen jedoch gezogene Trennlinien nicht nur unsere Klischees, sondern auch unsere Institutionen und politischen Strukturen. Dafür gibt es zahlreiche Beispiele. Universitäten teilen Forscher und Studenten in Abteilungen verschiedener Disziplinen ein, die unterschiedliche Haushaltslinien haben und um knappe Ressourcen konkurrieren. (»Interdisziplinär« ist zwar als Schlagwort gut, aber das Paradigma, auf dem unsere Institutionen beruhen, spricht dagegen.) Das Modell von Staaten, die als autonome Entitäten verhandeln, hat kläglich dabei versagt, den Klimawandel anzugehen. In der Bürokratie meiner Provinzregierung sind getrennte Abteilungen für Meere und Wälder zuständig, als ob eine verhängnisvolle Schranke das Ökosystem an der Gezeitengrenze auseinanderschneiden würde.

Auch die Zeit leidet darunter. Die Vergangenheit wird von der Gegenwart und die Gegenwart von der Zukunft in dem Maße entfremdet, wie unsere Gesellschaft sich auf kurzfristige finanzwirtschaftliche und politische Termine konzentriert. Eine fragmentierte Zeit bestimmt auch alle anderen Herausforderungen und macht sie nur noch schlimmer.

Ein so großer Teil unserer Gesellschaft operiert immer noch nach einem Paradigma der Vereinfachung, Abschottung und Trennlinien, während wir ein Paradigma der Vielfältigkeit, Komplexität, Beziehungen und Prozesse brauchen. Unsere Gesellschaftsstrukturen stehen in einem grundlegenden Konflikt mit den Botschaften der heutigen Naturwissenschaft. Wie können politische Entscheidungsträger vordringliche globale Probleme angehen und zugleich die Prinzipien der heutigen Naturwissenschaft ignorieren?

Die wirkliche Welt entwickelt sich wie ein Video. Die Beziehungen zwischen den Einzelbildern machen die Geschichte verständlich. Im Gegensatz dazu steht »der Raketenforscher« fiktiv, doch gänzlich allein, auf einem hohen Gipfel und ist von der Gesellschaft getrennt, anstatt ein Teil von ihr zu sein. Zugegeben, es ist zwar nur ein Klischee, aber auf die Sprache kommt es an, und Witze sind lehrreich. Es ist Zeit, dass »der Raketenforscher« in den Ruhestand geht.

Ich werde mit einem weiteren Dementi schließen: Es liegt mir fern, wirkliche Raketenforscher zu beleidigen. (Einige meiner besten Freunde waren Raketenforscher.) Es gibt wirkliche Raketenforscher. Sie wohnen in der wirklichen Welt mit all den damit verbundenen wechselseitigen Verknüpfungen, Beziehungen und Komplexitäten. »Der Raketenforscher« verkörpert das Gegenteil. Mit seiner Pensionierung wäre uns allen gedient.

Nigel Goldenfeld

Indivi-dualität

Center for Advanced Study Professor für Physik, Direktor des Institute for Universal Biology an der University of Illinois at Urbana-Champaign

In der Physik gebrauchen wir die Konvention, dass das Suffix -on eine quantisierte Einheit von etwas bedeutet. In der klassischen Physik gibt es beispielsweise elektromagnetische Wellen. Aber in der Quantenvariante der Theorie, die von Einsteins mit dem Nobelpreis von 1905 ausgezeichneten Arbeiten ausging, wissen wir, dass es unter bestimmten Umständen genauer ist, sich elektromagnetische Strahlungsenergie auf Teilchen verteilt vorzustellen, die Photonen genannt werden. Diese Wellen-Teilchen-Dualität ist die Grundlage der modernen Physik – nicht nur für Photonen, sondern einen ganzen Zoo von einst so genannten Elementarteilchen, die Protonen, Neutronen, Pionen, Mesonen und natürlich auch das Higgs-Boson umfassen. (Neutrino? Das ist eine lange Geschichte …)

Und wie steht es mit Ihnen? Sie sind eine Person. Sind Sie auch ein Quant von etwas? Nun, es gibt eindeutig keine bruchstückhaften Menschen und daher sind wir auf triviale Weise quantisiert. Aber Elementarteilchen oder -einheiten sind begrifflich deshalb nützlich, weil sie isoliert, ohne Interaktionen, betrachtet werden können – wie punktförmige Teilchen in einem idealen Gas. Sie würden diese Beschreibung sicherlich nicht erfüllen, so vernetzt, online und kultiviert, wie Sie zweifellos sind. Ihre starke Wechselwirkung mit anderen Menschen bedeutet, dass Ihre Individualität durch die Tatsache verkompliziert wird, dass Sie Teil einer Gesellschaft sind und nur in einem solchen Milieu angemessen funktionieren können. Wir könnten noch weiter gehen und sagen, dass Sie ein Quant eines räumlich verteilten Feldes sind, das die Dichte um jeden Punkt im Raum der Menschen beschreibt, anstatt die elektromagnetische Feldstärke. Diese Beschreibung erweist sich als technisch leistungsstark für die Charakterisierung des Verhaltens von Ökosystemen in Raum und Zeit, insbesondere für die Beschreibung des Aussterbens von Arten, bei dem diskontinuierliche Veränderungen wesentlich sind. An dieser Stelle scheint sich der merkwürdig selbstwidersprüchliche Begriff der Indivi-dualität anzubieten, ein Gegenstück zur Welle-Teilchen-Dualität.

Der Begriff des »Individuums« hat mehrere andere Nebenbedeutungen. Er kann diskret oder einzeln bedeuten, aber seine Etymologie erinnert auch an »unteilbar«. Offensichtlich sind wir nicht unteilbar, sondern bestehen aus Zellen, die ihrerseits wieder aus Zytoplasma, Nukleinsäuren, Proteinen usw. bestehen, welche selbst aus Atomen bestehen, die Neutronen, Protonen und Elektronen beinhalten, bis hinab zu den Elementarteilchen, von denen man annimmt, dass sie Produkte der Stringtheorie sind, von der wir jetzt wissen, dass sie keine endgültige Beschreibung der Materie ist. Mit anderen Worten, es handelt sich um »eine unendliche Reihe von Schildkröten«, und es gibt keine unteilbaren Einheiten der Materie, keinen Sinn für den Begriff des »Elementarteilchens«, keinen Punkt, an dem die Reihe zum Stillstand kommt. Alles besteht aus etwas und so weiter, ad infinitum.

Das bedeutet jedoch nicht, dass alles einfach nur die Summe seiner Teile ist. Betrachten wir beispielsweise das Proton – das aus drei Quarks besteht. Es hat eine Art von intrinsischem Drehimpuls, der als Spin bezeichnet wird, von dem man anfänglich meinte, er sei die Summe der Spins der Quarks, aus denen das Proton besteht. Doch Experimente, die über die letzten zwanzig oder dreißig Jahre hinweg durchgeführt wurden, haben gezeigt, dass das nicht stimmt: Der Spin entsteht aus einem gemeinsamen kollektiven Aspekt der Quarks und kurzlebiger fluktuierender Teilchen namens Gluonen. Die Vorstellung individueller Quarks ist nicht hilfreich, wenn das Kollektivverhalten so stark ist. Das Proton besteht zwar aus etwas, aber seine Eigenschaften findet man nicht, indem man die Eigenschaften seiner Teile aufsummiert. Wenn wir versuchen, etwas zu bestimmen, stellen wir fest, wie manche Leute über Los Angeles sagen, dass es dort kein »da« gibt.

Sie wissen wahrscheinlich schon, dass ein naiver Reduktionismus häufig zu sehr vereinfachend ist. Es gibt jedoch noch einen anderen Punkt. Sie sind nicht nur ein Kompositum, etwas, das Sie bereits wussten, aber in gewissen Hinsichten sind Sie nicht einmal ein Mensch. Sie haben etwa 100 Billionen Bakterienzellen in Ihrem Körper, zehnmal mehr als Ihre menschlichen Zellen; sie enthalten hundertmal so viele Gene wie Ihre menschlichen Zellen. Diese Bakterien sind nicht nur passive Bewohner des Zoos, der Sie sind. Sie organisieren sich selbst zu Gemeinschaften in Ihrem Mund, Darm und anderswo, und diese Gemeinschaften – Mikrobiome – werden durch vielfältige, dynamische Muster der Konkurrenz und Kooperation zwischen den verschiedenen Bakterien aufrechterhalten, was uns zu leben gestattet.

In den letzten Jahren hat die Genomik uns ein Werkzeug zur Verfügung gestellt, um das Mikrobiom durch die Bestimmung der Mikroben anhand ihrer DNS-Sequenzen zu erforschen. Die Geschichte, die aus diesen Untersuchungen hervorgeht, ist zwar noch nicht vollständig, hat aber schon zu faszinierenden Einsichten geführt. Dank seiner Mikroben kann ein Baby seine Muttermilch besser verdauen. Und Ihre Fähigkeit zur Verdauung von Kohlenhydraten beruht in bedeutendem Maße auf Enzymen, die nur von Genen produziert werden können, die nicht in Ihnen, sondern in Ihrem Mikrobiom vorkommen. Ihr Mikrobiom kann gestört werden – beispielsweise durch die Behandlung mit Antibiotika –, und in extremen Fällen können gefährliche Monokulturen in es eindringen wie z.B. Clostridium difficile, was zu Ihrem Tod führt. Der vielleicht bemerkenswerteste Befund ist die Darm/Gehirn-Achse: Ihr gastrointestinales Mikrobiom kann kleine Moleküle erzeugen, die in der Lage sind, die Blut-Hirn-Schranke zu überwinden und den Zustand Ihres Gehirns zu beeinflussen. Obwohl der genaue Mechanismus noch nicht aufgeklärt ist, gibt es zunehmend Belege dafür, dass Ihr Mikrobiom ein wesentlicher Faktor bei Geisteszuständen wie Depression und Zuständen des Autismusspektrums ist. Kurz, möglicherweise sind Sie eine Kollektiveigenschaft, die aus der engen Wechselwirkung Ihrer Bestandteile entsteht.

Vielleicht stimmt es, dass Sie kein Individuum in einem Sinne des Wortes sind, aber wie steht es mit Ihren Mikroben? Nun, es stellt sich heraus, dass auch Ihre Mikroben ein stark wechselwirkendes System sind: Sie bilden dichte Kolonien in Ihrem Innern und tauschen nicht nur chemische Stoffe zum Stoffwechsel aus, sondern kommunizieren durch die Ausschüttung von Molekülen. Sie können sogar Gene untereinander übertragen, und in einigen Fällen tun sie das als Reaktion auf Signale, die von einem erwartungsvollen Empfänger kommen – ein bakterieller Hilferuf! Eine einzelne, isolierte Mikrobe tut so etwas nicht, also sind diese komplexen Verhaltensweisen eine Eigenschaft des Kollektivs und nicht der individuellen Mikroben. Selbst Mikroben, die aus derselben nominellen Art stammen, können Genome haben, die sich in ihrem Inhalt um bis zu 60 Prozent ihrer Gene unterscheiden. So viel zum intuitiven Begriff der »Art«! Das ist eine weitere zu sehr anthropomorphe wissenschaftliche Idee, die auf den größten Teil des Lebendigen keine Anwendung hat.

Bislang habe ich über Verknüpfungen im Raum gesprochen. Es gibt aber auch Verknüpfungen in der Zeit. Wenn der Stoff, aus dem das Universum besteht, im Raum stark verknüpft ist und nicht angemessen als Gesamtsumme seiner Teile vorgestellt werden kann, dann ist es vielleicht auch nicht sinnvoll, die Ursache eines Ereignisses einem besonderen Bestandteil zuzuordnen. Ebenso wie man den Spin eines Protons nicht einem seiner Bestandteile zuordnen kann, kann man auch ein Ereignis in der Zeit keiner einzelnen früheren Ursache zuweisen. Für komplexe Systeme gibt es weder einen brauchbaren Begriff von Individualität noch einen angemessenen Begriff von Kausalität.

Nicholas Humphrey

Je größer das Gehirn eines Lebewesens ist, umso größer ist seine Intelligenz

Psychologe am Darwin College in Cambridge; Autor von Soul Dust: The Magic of Consciousness

Je größer das Gehirn eines Lebewesens, umso größer seine Intelligenz. Vielleicht meinen Sie, dass die Beziehung offensichtlich ist. Betrachten wir nur die Entwicklungslinie der Menschen. Menschen haben größere Gehirne und sind schlauer als Schimpansen; und Schimpansen haben größere Gehirne und sind schlauer als kleine Affen. Oder betrachten wir als Analogie die Geschichte der Rechenmaschinen im 20. Jahrhundert. Je größer die Maschinen, umso größer ihre Leistungsfähigkeit beim Verarbeiten von Zahlen. In den 1970er Jahren füllte der neue Computer in meiner Universitätsabteilung ein ganzes Zimmer aus.

Von der Phrenologie des 19. Jahrhunderts bis zu den Wissenschaften des 21. Jahrhunderts, die zur Untersuchung des Gehirns bildgebende Verfahren benutzen, galt tatsächlich die weitverbreitete Annahme, dass das Gehirnvolumen die kognitive Kapazität bestimmt. Insbesondere werden Sie die Idee in jedem modernen Lehrbuch wiederholt finden – dass die Gehirngröße verschiedener Primatenarten mit ihrer sozialen Intelligenz kausal verknüpft ist. Ich gestehe, dass ich zum Teil die Verantwortung dafür trage, da ich die Idee in den 1970er Jahren verfochten habe. Doch seit langen Jahren hege ich den Verdacht, dass die Idee falsch ist.

Es gibt zu viele widerspenstige Tatsachen, die nicht dazupassen. Zunächst einmal wissen wir, dass moderne Menschen mit nur zwei Dritteln des normalen Volumens an Gehirngewebe geboren werden und als Erwachsene so gut wie keine kognitiven Defizite aufweisen können. Wir wissen, dass das Gehirn während der normalen menschlichen Hirnentwicklung tatsächlich schrumpft, während die kognitive Leistung besser wird, (ein beachtenswertes Beispiel sind die Veränderungen des »sozialen Gehirns« in der Adoleszenz, wobei die graue Masse der Hirnrinde zwischen dem Alter von zehn und zwanzig Jahren um etwa 15 Prozent im Volumen abnimmt). Am erstaunlichsten von allem ist, dass wir wissen, dass es nichtmenschliche Lebewesen wie z.B. Bienen oder Papageien gibt, die viele Meisterleistungen menschlicher Intelligenz mit Gehirnen nachahmen können, die nur ein Millionstel (Bienen) oder ein Tausendstel (Papageien) der Größe eines menschlichen Gehirns aufweisen.

Das Entscheidende ist natürlich die Programmierung: Was für die kognitive Leistung wirklich den Ausschlag gibt, ist nicht so sehr die Hardware des Gehirns, sondern seine Feld-Software. Und eine intelligentere Software braucht keine größere Hardwaregrundlage. (Wie die Schrumpfung der Hirnrinde während der Adoleszenz zeigt, braucht sie womöglich eine kleinere, aufgeräumtere.) Um eine höhere Leistung zu erbringen, erfordern Programme in der Regel eine Menge Entwicklungsarbeit, entweder durch die natürliche Selektion oder durch Lernen. Aber wenn sie einmal erfunden worden sind, stellen sie wahrscheinlich weniger Anforderungen an die Hardware als ältere Versionen. Um den Sonderfall der sozialen Intelligenz zu nehmen, würde ich sagen, dass es durchaus möglich ist, dass der Algorithmus für die Lösung von Problemen der »Theorie des Geistes«, auf die Rückseite einer Postkarte geschrieben und auf einem iPhone implementiert werden kann. In welchem Fall die weithin angepriesene Vermutung, dass das menschliche Gehirn seine Größe verdoppeln musste, damit Menschen in die Lage versetzt wurden, »Gedankenlesen zweiter Stufe« zu betreiben, wenig Sinn macht.

Warum hat sich dann die Größe des menschlichen Gehirns verdoppelt? Warum ist es viel größer, als es vermutlich sein musste, um unser Intelligenzniveau zu unterstützen? Es besteht kein Zweifel, dass große Gehirne kostspielig in ihrem Aufbau und ihrer Unterhaltung sind. Wenn wir also die »naheliegende Theorie« in den Ruhestand schicken sollen, was können wir an ihre Stelle setzen? Die Antwort, so lautet mein Vorschlag, liegt im Vorteil einer großen Menge kognitiver Reserven. Große Gehirne haben eine Kapazitätsreserve, auf die zurückgegriffen werden kann, falls und wenn funktionierende Teile beschädigt werden oder verschleißen. Vom Erwachsenenalter an beginnen Menschen – wie andere Säugetiere auch – einen bedeutenden Anteil an Gehirngewebe aufgrund von Unfällen, Blutungen und Degeneration zu verlieren. Da Menschen aber von dieser Reserve zehren können, muss der Verlust nicht auffallen. Das bedeutet, dass Menschen ihre geistigen Kräfte bis in ein relativ hohes Alter beibehalten können, lange nachdem ihre Vorfahren mit einem kleineren Gehirn außer Gefecht gesetzt worden wären. (Und tatsächlich besteht eine viel höhere Wahrscheinlichkeit, dass das bedauernswerte Individuum, das mit einem ungewöhnlich kleinen Gehirn auf die Welt kommt, im Alter zwischen vierzig und fünfzig einer senilen Demenz erliegt.)

Zwar sterben viele von uns aus anderen Gründen mit ungenutzten Leistungskapazitäten des Gehirns. Aber einige von uns leben bedeutend länger, als es der Fall gewesen wäre, wenn unser Gehirn nur halb so groß wäre. Welchen evolutionären Vorteil bringt also die Langlebigkeit, selbst die Langlebigkeit nach der Fortpflanzung, die typisch für Menschen ist? Die Antwort ist sicherlich, dass Menschen – wie keine andere Art – vom Vorhandensein geistig gesunder Großeltern und Urgroßeltern profitieren können, deren Rolle bei der Betreuung und Unterrichtung für den Erfolg der menschlichen Kultur entscheidend gewesen ist.

Lee Smolin

Der Urknall war der erste Moment in der Zeit

Physiker am Perimeter Institute in Waterloo, Ontario; Autor von Im Universum der Zeit

Auf meinem Gebiet der Grundlagenphysik und Kosmologie ist die Idee, dass der Urknall der erste Moment in der Zeit war, am reifsten für den Ruhestand.

Im allgemeinen Sprachgebrauch hat der Urknall zwei Bedeutungen. Erstens ist die Urknall-Kosmologie die Hypothese, dass unser Universum sich seit 13,8 Milliarden Jahren von einem extrem heißen und dichten Urzustand, der extremer war als das Zentrum eines Sterns – ja, als jeder Ort, der jetzt existiert – ausgedehnt hat. Damit habe ich keine Probleme; das ist eine belegte wissenschaftliche Tatsache, die zu einer detaillierten Geschichte ausgearbeitet wurde, welche die Ausdehnung des Universums von einem gleichförmigen und dichten heißen Plasma zu der herrlich vielgestaltigen und komplexen Welt erzählt, die unsere Heimat ist. Wir haben detaillierte Theorien, die zahlreiche Beobachtungstests bestehen und die Ursprünge aller sichtbaren Strukturen erklären, von den Elementen zu Galaxien, Sternen, Planeten und den molekularen Bausteinen des Lebens. Wie in jeder guten wissenschaftlichen Theorie gibt es Fragen, die immer noch auf eine Antwort warten, wie beispielsweise die genaue Beschaffenheit der dunklen Materie und dunklen Energie, die prominente Akteure in der Geschichte sind, oder die überaus interessante Frage, ob es eine frühe Phase einer inflationären exponentiellen Expansion gab. Aber diese Dinge legen nicht nahe, dass die Grundvorstellung falsch ist.

Was mir Sorgen macht, ist die andere Bedeutung von Urknall, die in der zusätzlichen Hypothese besteht, dass der letztendliche Ursprung unseres Universums der erste Moment in der Zeit war, als unser Universum aus einem Zustand unendlicher Dichte und Temperatur startete. Dieser Vorstellung zufolge ist nichts Existierendes älter als 13,8 Milliarden Jahre. Es hat keinen Sinn zu fragen, was davor war, weil es davor nicht einmal die Zeit gab.

Das Hauptproblem mit dieser zweiten Bedeutung von Urknall liegt darin, dass sie als wissenschaftliche Hypothese nicht besonders erfolgreich ist, weil sie wichtige Fragen zum Universum unbeantwortet lässt. Es zeigt sich, dass unser Universum in einem außergewöhnlich besonderen Zustand begonnen haben musste, um sich zu etwas entwickeln zu können, das unserem Universum gleicht. Die Hypothese, dass es einen ersten Moment in der Zeit gegeben hat, ist bemerkenswert generisch und unterliegt nur wenigen Beschränkungen, da sie mit einer unendlichen Anzahl möglicher Zustände vereinbar ist, in denen das Universum hätte beginnen können. Das folgt aus einem Theorem, das von Stephen Hawking und Roger Penrose bewiesen wurde – nämlich dass fast jedes expandierende Universum, das von der allgemeinen Relativitätstheorie beschrieben wird, einen solchen ersten Moment in der Zeit besitzt. Im Vergleich zu fast allen dieser Universen war unser eigenes frühes Universum außergewöhnlich homogen und symmetrisch. Warum? Wenn der Urknall der erste Moment in der Zeit war, kann es darauf keine wissenschaftliche Antwort geben, weil es kein »Davor« gab, auf dem man eine Erklärung gründen könnte. An diesem Punkt sehen Theologen ihre Lücke und stehen tatsächlich an den Toren der Naturwissenschaft Schlange, um ihre Art von Erklärung durchzusetzen, nämlich dass Gott das Universum geschaffen hat und dass er es auf eben diese Weise geschaffen hat.

Ebenso kann es keine wissenschaftliche Antwort auf die Frage geben, was die Naturgesetze ausgewählt hat, wenn der Urknall der erste Moment in der Zeit war. Das eröffnet das Gebiet für Erklärungen, wie z.B. das anthropische Multiversum, die unwissenschaftlich sind, weil sie sich alle auf nicht beobachtbare Ansammlungen anderer Universen berufen und keine Vorhersagen machen, durch die ihre Hypothese überprüft und falsifiziert werden könnte.

Es gibt jedoch eine Chance für die Naturwissenschaft, diese Fragen zu beantworten, und die besteht dann, wenn der Urknall nicht der erste Moment in der Zeit war, sondern ein Übergang von einer früheren Epoche des Universums – eine Epoche, die wissenschaftlich erforscht werden kann, weil Prozesse, die damals stattfanden, unsere Welt hervorgebracht haben.

Damit es eine Zeit vor dem Urknall gegeben haben könnte, muss das Hawking-Penrose-Theorem zwar falsch sein. Aber es gibt einen einfachen Grund für den Gedanken, dass es falsch sein muss: Die allgemeine Relativitätstheorie ist als Beschreibung der Natur unvollständig, weil sie Quantenphänomene unberücksichtigt lässt. Die Vereinheitlichung der Quantenphysik mit der allgemeinen Relativitätstheorie ist seit langem eine wichtige Herausforderung der Grundlagenphysik, im Hinblick auf die in den letzten dreißig Jahren viele Fortschritte gemacht wurden. Obwohl eine endgültige Lösung des Problems noch aussteht, gibt es solide Belege anhand von Modellen der Quantenkosmologie dafür, dass die unendlichen Singularitäten, die die Zeit in der allgemeinen Relativitätstheorie zum Stillstand zwingen, eliminiert werden, wodurch der Urknall – im Sinne eines ersten Moments in der Zeit – in einen Ur-Sprung verwandelt wird, der der Zeit gestattet, auch vor dem Urknall bis tief in die Vergangenheit hinein zu existieren. Detaillierte Modelle von Quantenuniversen zeigen eine frühere Epoche, die in einem Kollaps endet, wobei die Dichte bis zu sehr hohen Werten ansteigt, aber bevor das Universum unendlich dicht wird, übernehmen Quantenprozesse die Führung und kehren den Kollaps zu einer Expansion um, wodurch sie eine neue Epoche einleiten, die unser expandierendes Universum sein könnte.

Gegenwärtig werden mehrere Szenarien erforscht, die sich darauf beziehen, was in der Epoche vor dem Urknall geschah und wie das in unser expandierendes Universum überging. Zwei davon nehmen einen Quantensprung an und werden als »Schleifen-Quantenkosmologie« und »Geometrogenese« bezeichnet. Zwei andere – die jeweils auf Roger Penrose und auf Paul Steinhardt und Neil Turok zurückgehen – beschreiben zyklische Szenarios, in denen Universen sterben und neue Universen hervorgebracht werden. Eine fünfte Hypothese postuliert, dass neue Universen dann beginnen, wenn Quanteneffekte über die Singularitäten von schwarzen Löchern hinwegspringen. Diese Szenarien bieten Einsichten darüber an, wie die Naturgesetze, die unser Universum regieren, möglicherweise ausgewählt wurden, und außerdem könnten sie erklären, wie die Anfangsbedingungen unseres Universums sich aus dem vorherigen Universum entwickelt haben. Wichtig ist, dass jede dieser Hypothesen Vorhersagen über wirkliche, durchführbare Beobachtungen macht, durch die sie falsifiziert und voneinander unterschieden werden können.